Cluster Hanwha Vision sans stockage partagé sur un SAN

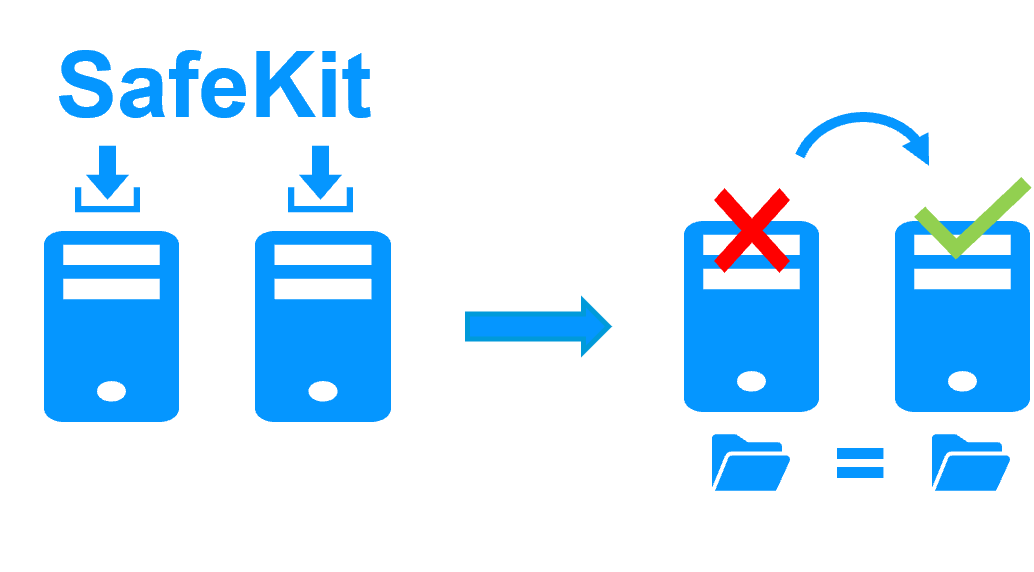

[SafeKit] Réplication temps réel synchrone, haute disponibilité et migration de machines virtuelles entre deux serveurs

La solution apportée à Hanwha Vision

Evidian SafeKit apporte la haute disponibilité à Hanwha Vision entre deux serveurs de n'importe quelle marque.

Cet article explique comment mettre en œuvre rapidement un cluster Hanwha Vision sans stockage partagé sur un SAN et sans compétences spécifiques.

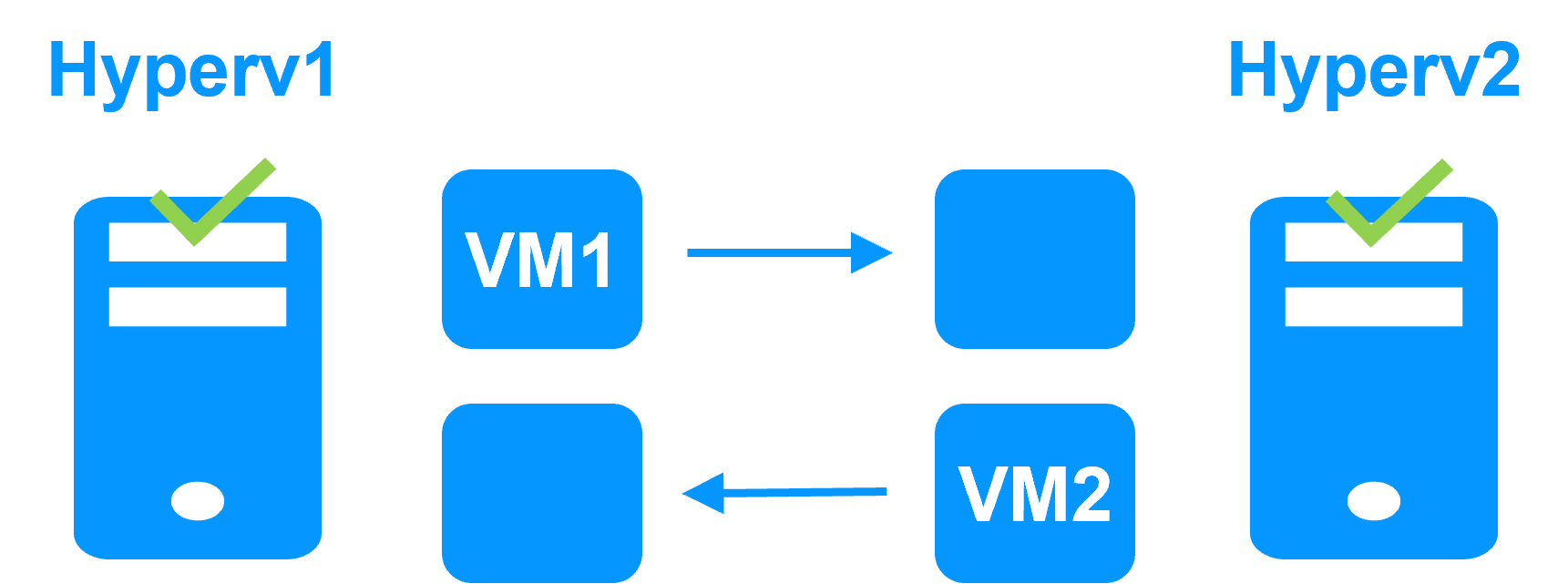

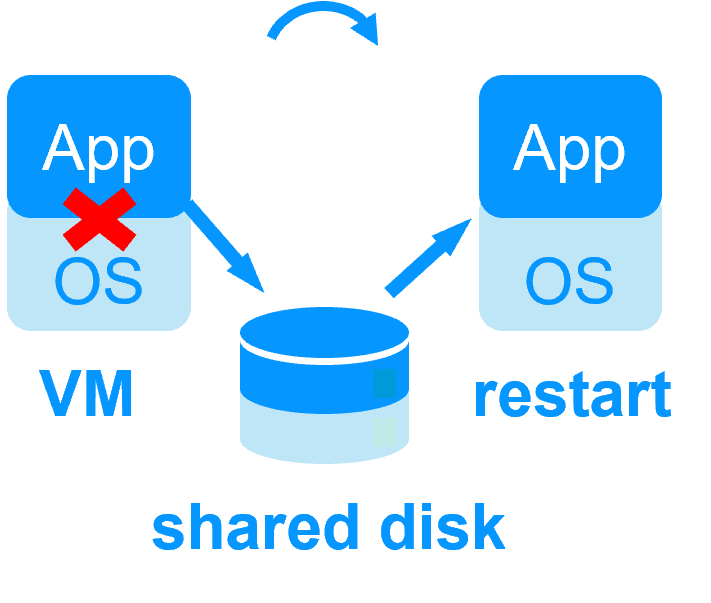

Le principe de la solution est de mettre Hanwha Vision dans une machine virtuelle sous Hyper-V. SafeKit implémente la réplication en temps réel et le basculement automatique de la machine virtuelle.

A noter que Hyper-V est l'hyperviseur gratuit inclus dans toutes les versions de Windows (même Windows pour PC).

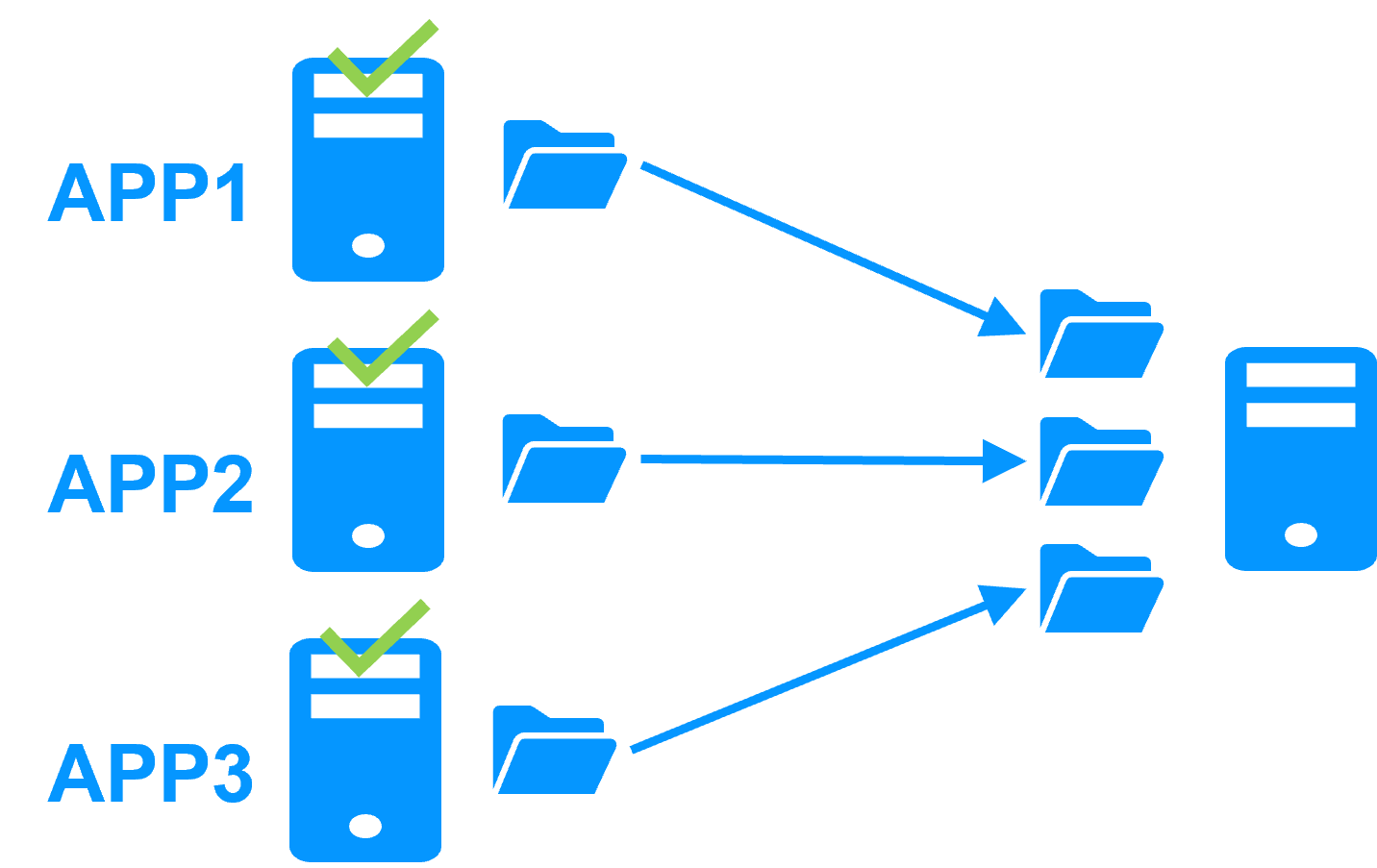

Une solution ouverte à plusieurs applications

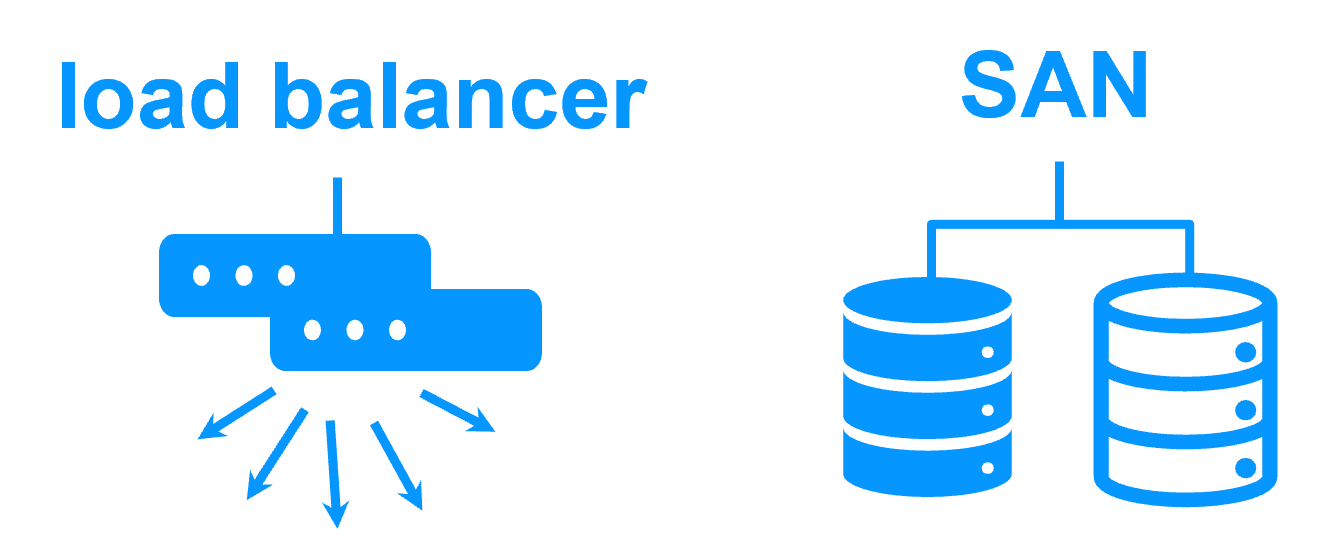

Plusieurs applications peuvent être mises dans plusieurs machines virtuelles répliquées et redémarrées par SafeKit. Vous avez la possibilité de migrer chaque machine virtuelle entre les deux serveurs avec la console SafeKit et ainsi d'équilibrer la charge dans un cluster actif-actif.

Économisez des coûts avec cette solution

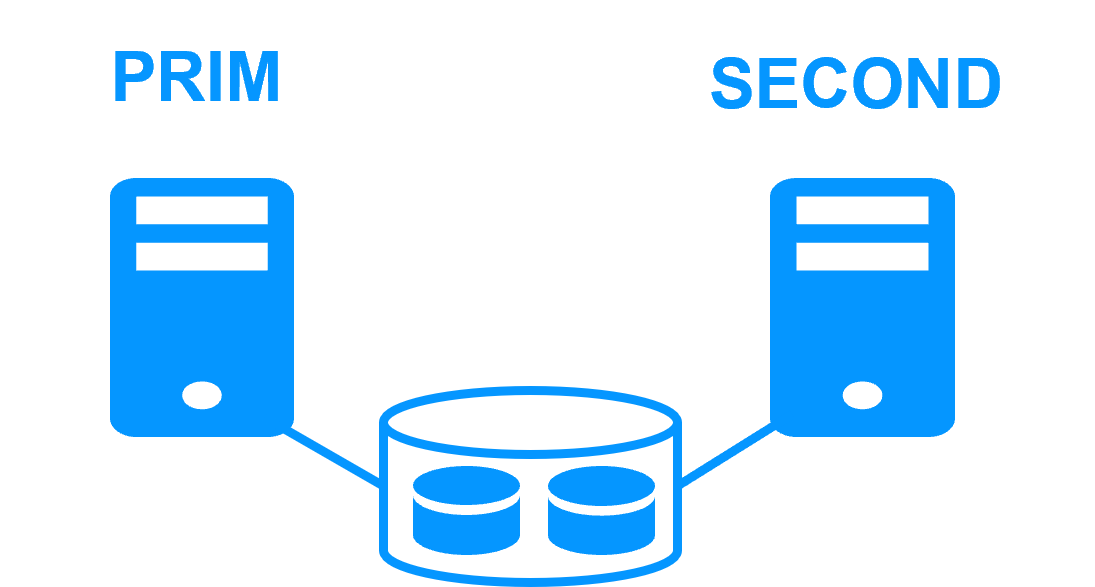

Il n'y a pas besoin d'une solution complexe de type VMware avec trois serveurs et un stockage partagé sur un SAN ou vSAN. Avec SafeKit, vous disposerez à la place d'une réplication synchrone en temps réel et d'un basculement de plusieurs machines virtuelles entre deux serveurs.

Et avec l'interface graphique standard du manager Hyper-V, vous pourrez gérer très simplement vos machines virtuelles.

Notez que vous pouvez implémenter avec le produit SafeKit la réplication et le basculement en temps réel de n'importe quel répertoire de fichiers et service, base de données, machines virtuelles Hyper-V ou KVM complètes, Docker, Podman, K3S, applications Cloud (voir la liste des modules).

Partenaires, le succès avec SafeKit

Cette solution indépendante de la plateforme est idéale pour un partenaire revendant une application critique et qui souhaite proposer une option de redondance et de haute disponibilité simple à déployer auprès de nombreux clients.

Avec de nombreuses références dans de nombreux pays gagnées par des partenaires, SafeKit s'est avéré être la solution la plus simple à mettre en œuvre pour la redondance et la haute disponibilité des logiciels de gestion des bâtiments, vidéosurveillance, contrôle d'accès, systèmes SCADA...

Comment fonctionne un cluster Hyper-V avec réplication et basculement sur panne de Hanwha Vision ?

Les étapes suivantes sont décrites pour une seule machine virtuelle contenant Hanwha Vision dans un seul module miroir. Chaque machine virtuelle répliquée s'exécute dans un module miroir indépendant (dans une limite de 32 machines virtuelles) avec un serveur primaire qui peut être soit le serveur Hyper-V 1 ou le serveur Hyper-V 2.

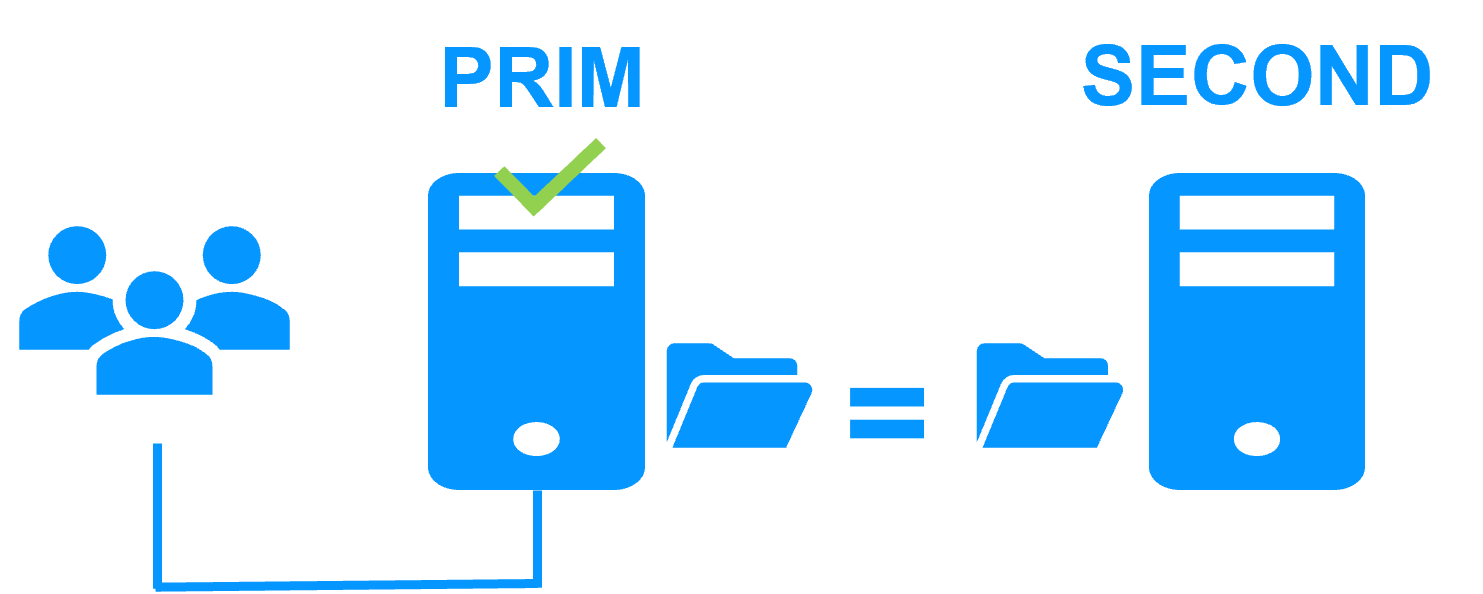

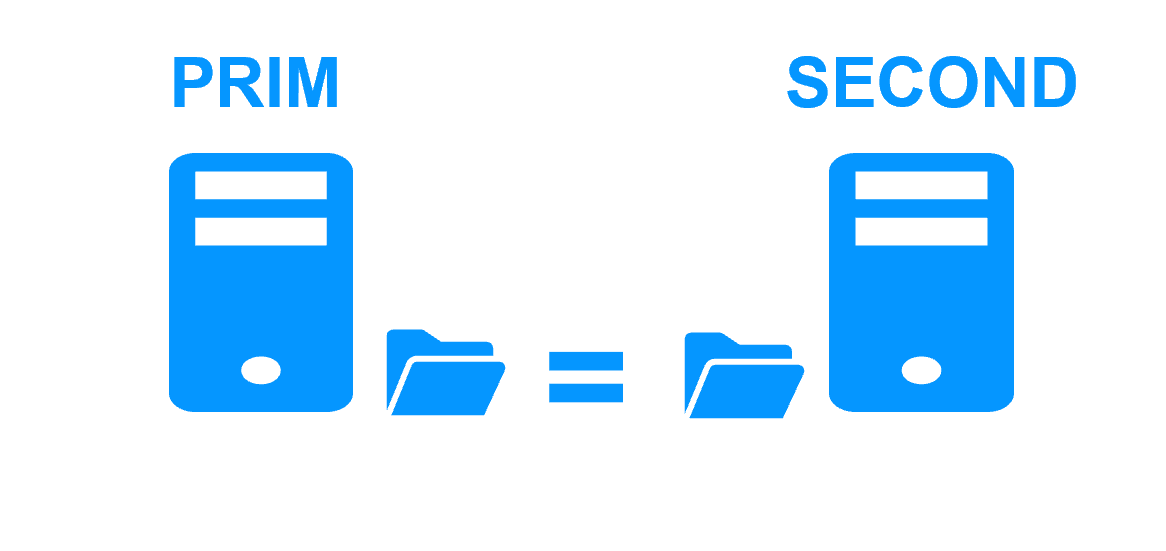

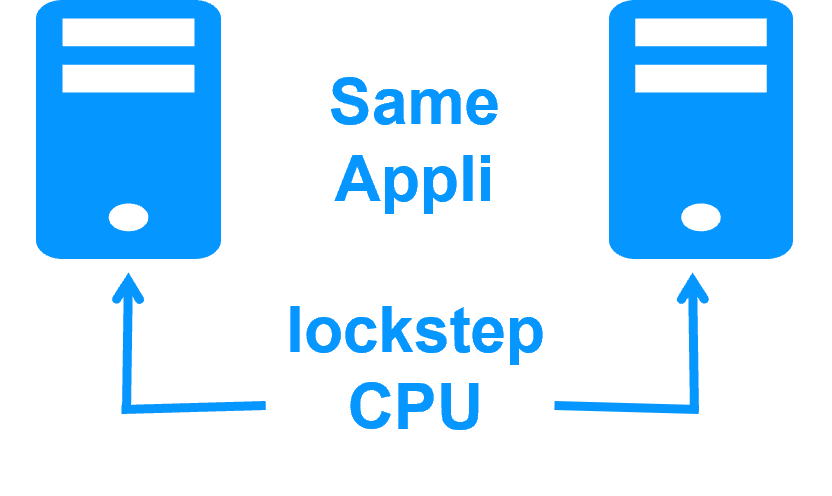

Etape 1. Réplication en temps réel

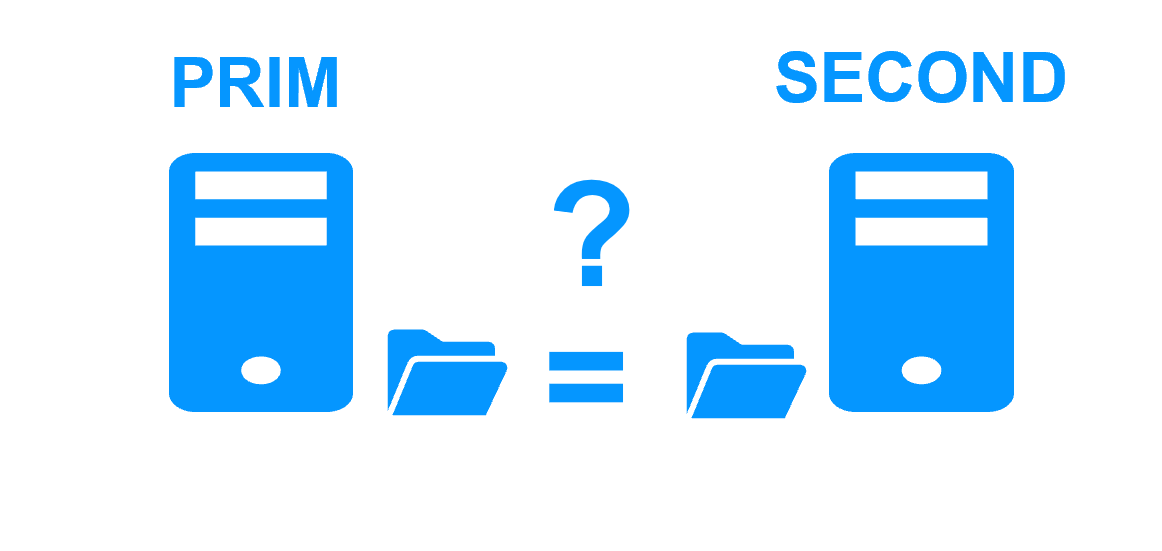

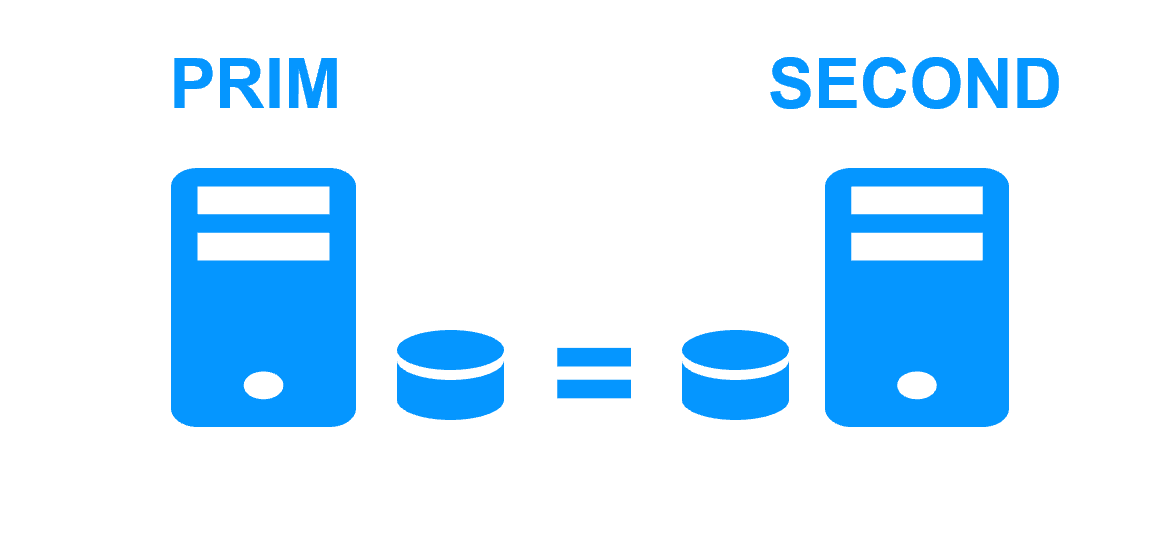

Le serveur 1 (PRIM) exécute la VM (machine virtuelle) contenant Hanwha Vision. SafeKit réplique en temps réel les fichiers de la VM (disques durs virtuels, configuration de la VM). Seules les modifications faites à l'intérieur des fichiers sont répliquées en continue à travers le réseau.

La réplication est synchrone sans perte de données en cas de panne contrairement à une réplication asynchrone.

Il vous suffit de configurer le nom du répertoire contenant la VM dans SafeKit. Il n'y a pas de pré-requis sur l'organisation du disque. Le répertoire peut se trouver sur le disque système.

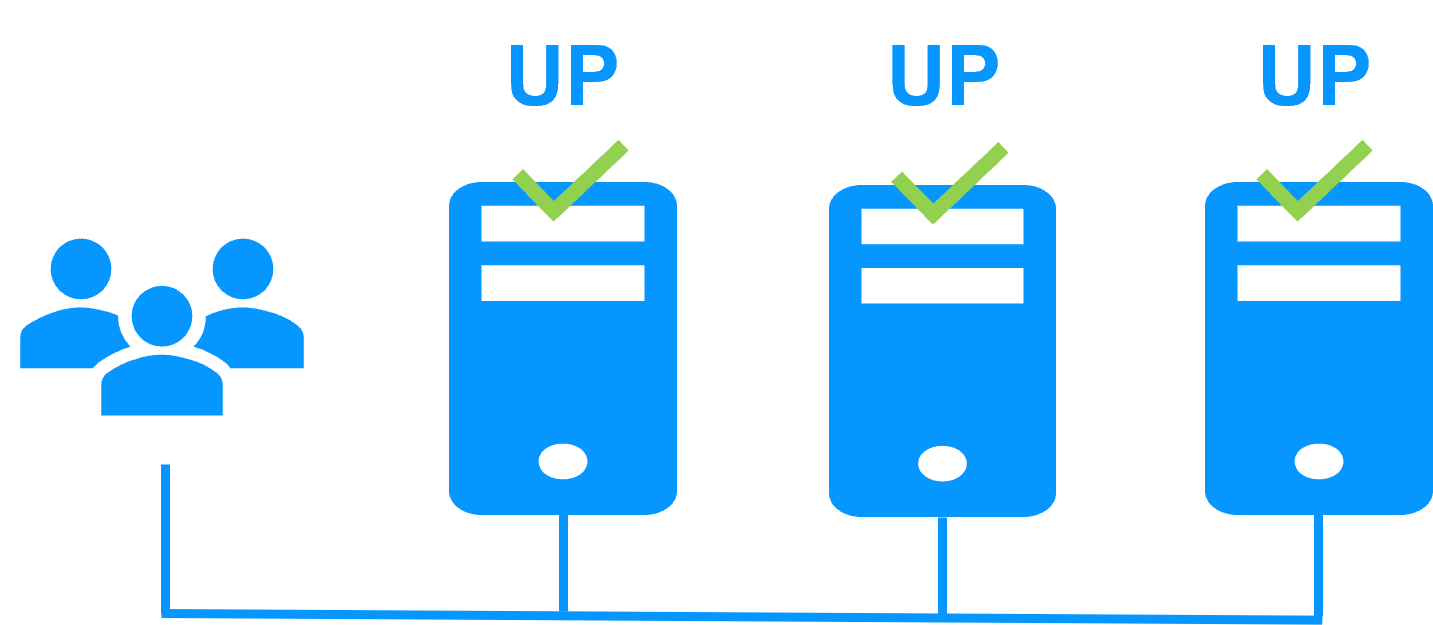

Etape 2. Basculement automatique

Lorsque le serveur 1 tombe en panne, le serveur 2 prend le relais. SafeKit redémarre la VM contenant Hanwha Vision sur le serveur 2. Hyper-V trouve les fichiers répliqués par SafeKit à jour sur le serveur 2.

La VM continue de s'exécuter sur le serveur 2 en modifiant localement ses fichiers qui ne sont pas plus répliqués sur le serveur 1.

Le temps de basculement est égal au temps de détection de panne (30 secondes par défaut) plus le temps de redémarrage de la VM.

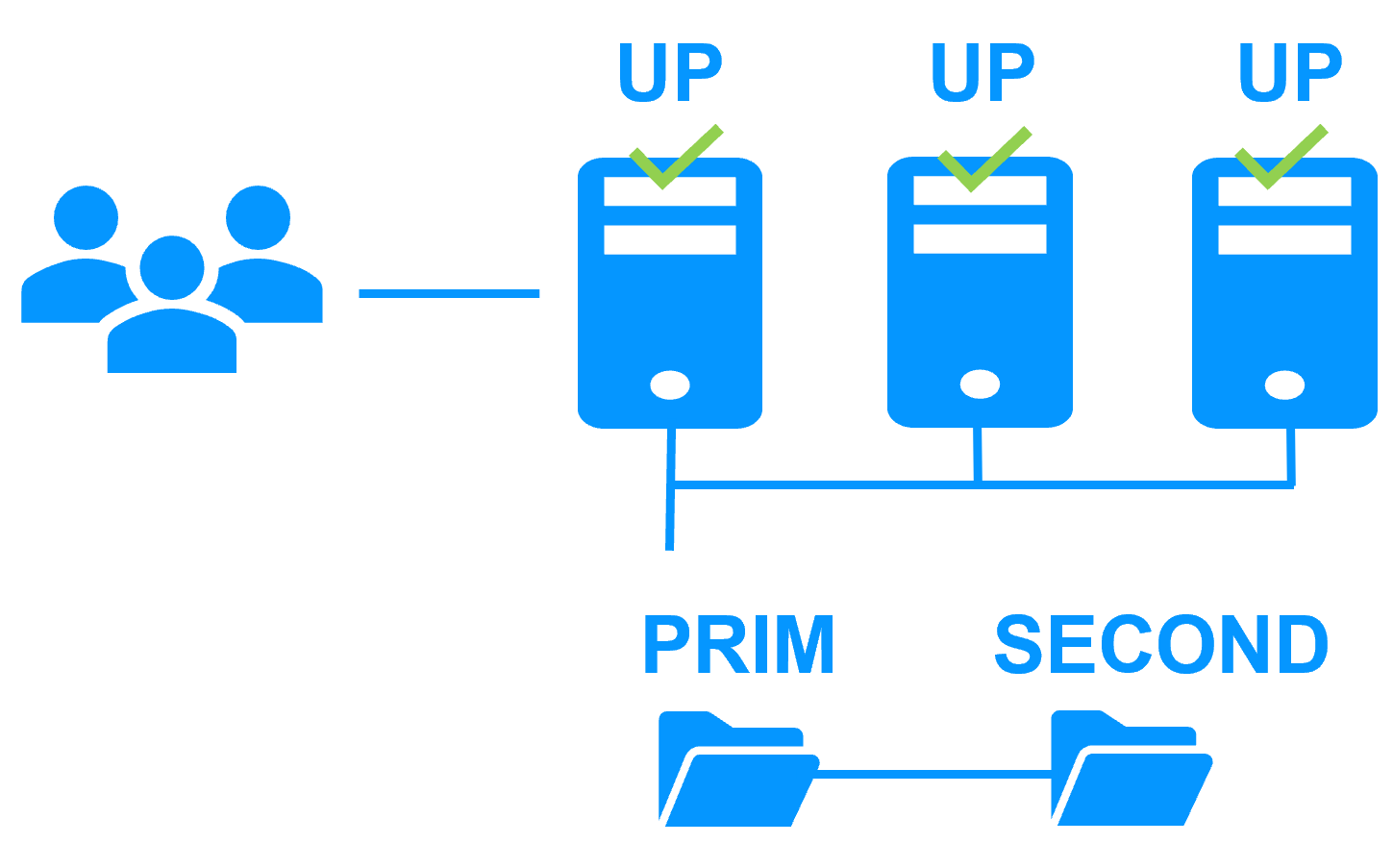

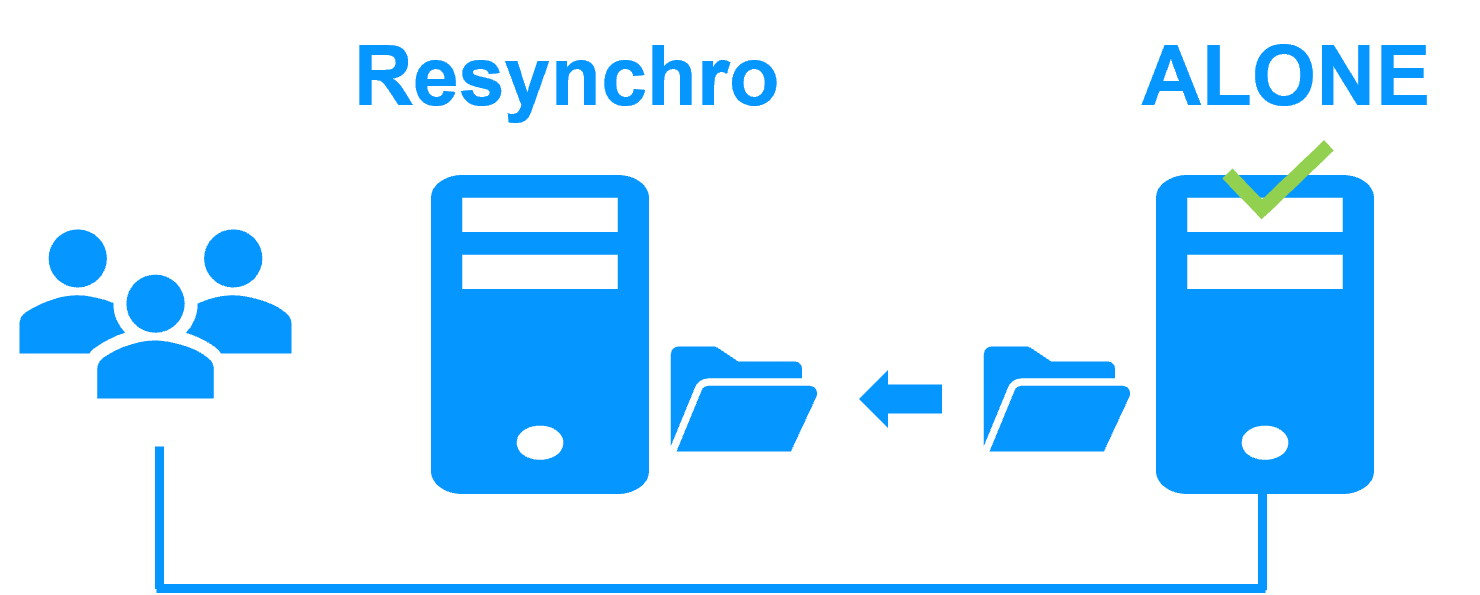

Etape 3. Réintégration après panne

A la reprise après panne du serveur 1 (réintégration du serveur 1), SafeKit resynchronise automatiquement les fichiers de la VM à partir de l'autre serveur.

La réintégration du serveur 1 se fait sans arrêter l'exécution de la VM contenant Hanwha Vision sur le serveur 2.

Etape 4. Retour à la normale

Après la réintégration, les fichiers de la VM sont à nouveau en mode miroir, comme à l'étape 1. Le système est de nouveau en mode haute disponibilité, la VM contenant Hanwha Vision s'exécutant sur le serveur 2 et SafeKit répliquant les mises à jour sur le serveur 1.

Si l'administrateur souhaite que son application s'exécute en priorité sur le serveur 1, il peut exécuter une commande de basculement, soit manuellement à un moment opportun, soit automatiquement par configuration.

Plus d'information sur une coupure de courant et un isolement du réseau dans un cluster.

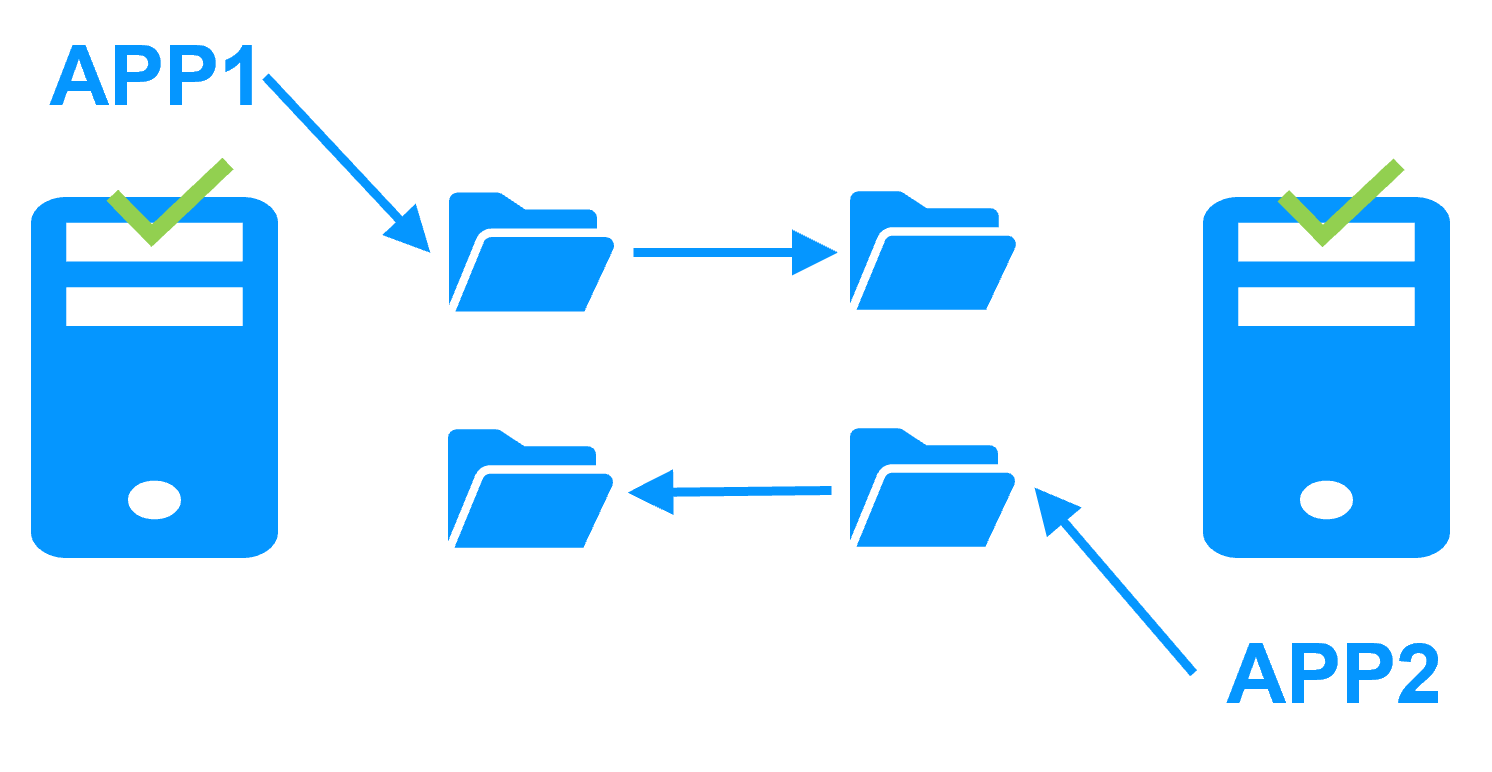

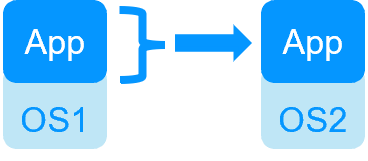

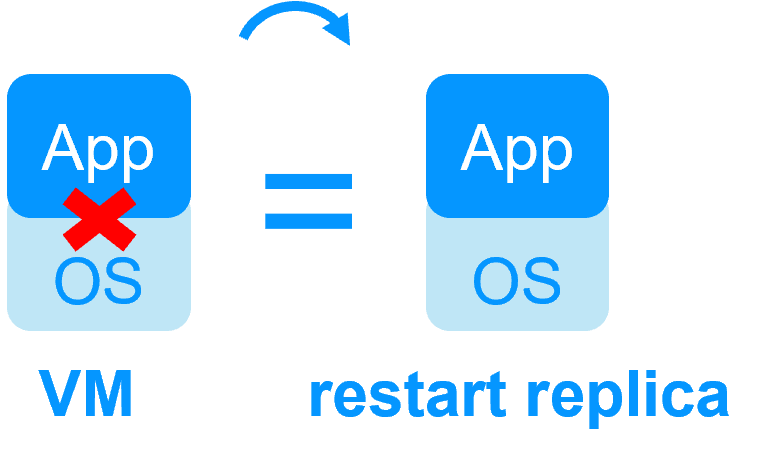

Redondance au niveau de l'application

Dans ce type de solution, seules les données applicatives sont répliquées. Et seule l'application est redémarrée en cas de panne.

Avec cette solution, des scripts de redémarrage doivent être écrits pour redémarrer l'application.

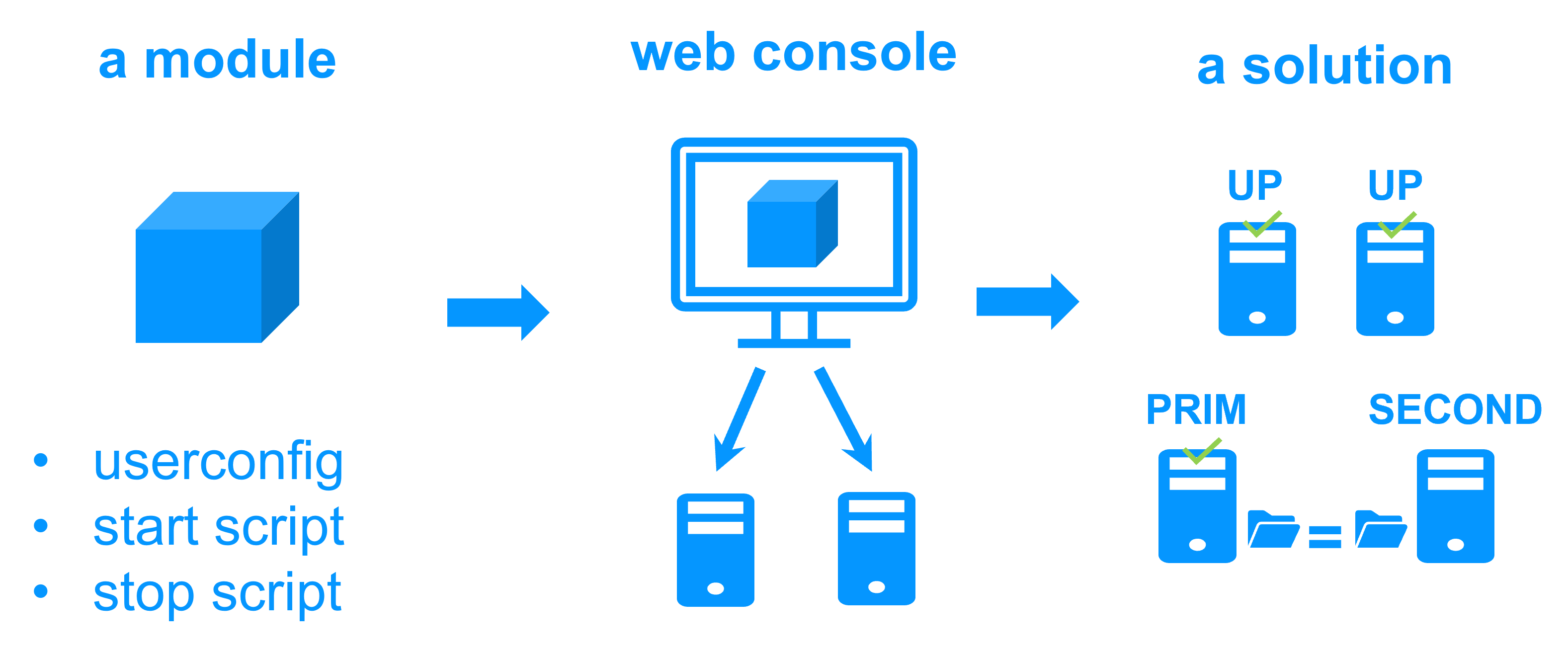

Nous livrons des modules applicatifs pour mettre en œuvre la redondance au niveau applicatif. Ils sont préconfigurés pour des applications et des bases de données bien connues. Vous pouvez les personnaliser avec vos propres services, données à répliquer, checkers d'application. Et vous pouvez combiner les modules applicatifs pour construire des architectures avancées à plusieurs niveaux.

Cette solution est indépendante de la plate-forme et fonctionne avec des applications à l'intérieur de machines physiques, de machines virtuelles, dans le Cloud. Tout hyperviseur est supporté (VMware, Hyper-V...).

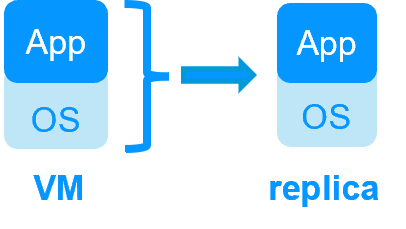

Redondance au niveau de machine virtuelle

Dans ce type de solution, la machine virtuelle (VM) complète est répliquée (Application + OS). Et la machine virtuelle complète est redémarrée en cas de panne.

L'avantage est qu'il n'y a pas de scripts de redémarrage à écrire par application et pas d'adresse IP virtuelle à définir. Si vous ne savez pas comment fonctionne l'application, c'est la meilleure solution.

Cette solution fonctionne avec Windows/Hyper-V et Linux/KVM mais pas avec VMware. Il s'agit d'une solution active/active avec plusieurs machines virtuelles répliquées et redémarrées entre deux nœuds.

- Solution pour une nouvelle application (pas de script de redémarrage à écrire) : Windows/Hyper-V, Linux/KVM

Pourquoi une réplication de quelques Tera-octets ?

Temps de resynchronisation après panne (étape 3)

- Réseau 1 Gb/s ≈ 3 heures pour 1 téraoctet.

- Réseau 10 Gb/s ≈ 1 heure pour 1 téraoctet ou moins en fonction des performances d'écriture disque.

Alternative

- Pour un grand volume de données, utilisez un stockage partagé externe.

- Plus cher, plus complexe.

Pourquoi une réplication < 1 000 000 fichiers ?

- Performance du temps de resynchronisation après panne (étape 3).

- Temps pour vérifier chaque fichier entre les deux nœuds.

Alternative

- Placez les nombreux fichiers à répliquer sur un disque dur virtuel / une machine virtuelle.

- Seuls les fichiers représentant le disque dur virtuel / la machine virtuelle seront répliqués et resynchronisés dans ce cas.

Pourquoi un basculement ≤ 32 VMs répliquées ?

- Chaque VM s'exécute dans un module miroir indépendant.

- Maximum de 32 modules miroir exécutés sur le même cluster.

Alternative

- Utilisez un stockage partagé externe et une autre solution de clustering de VMs.

- Plus cher, plus complexe.

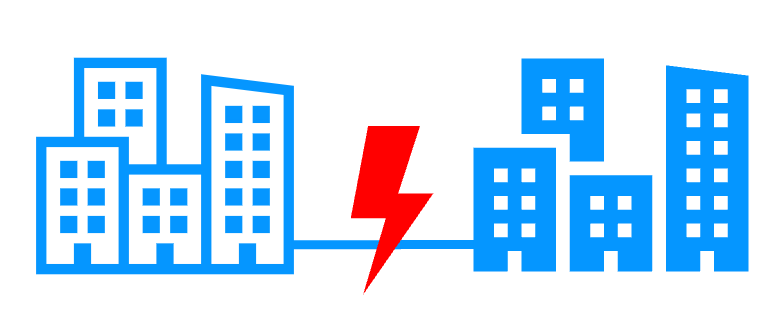

Pourquoi un réseau LAN/VLAN entre sites distants ?

- Basculement automatique de l'adresse IP virtuelle avec 2 nœuds dans le même sous-réseau.

- Bonne bande passante pour la resynchronisation (étape 3) et bonne latence pour la réplication synchrone (typiquement un aller-retour de moins de 2 ms).

Alternative

- Utilisez un équilibreur de charge pour l'adresse IP virtuelle si les 2 nœuds sont dans 2 sous-réseaux (supporté par SafeKit, notamment dans le cloud).

- Utilisez des solutions de backup avec réplication asynchrone pour un réseau à latence élevée.

Prérequis

- Vous avez besoin du rôle Hyper-V installé sur 2 nœuds Windows (intégré gratuitement dans toutes les versions de Windows incluant les versions Windows pour PC).

- Vous devez avoir vos applications critiques installées dans une ou plusieurs machines virtuelles.

- Comme le script de basculement importe la machine virtuelle sur l'Hyper-V secondaire, faites attention aux paramètres Hyper-V et à la compatibilité du processeur entre les 2 nœuds.

Installation du package sous Windows

-

Téléchargez la version gratuite de SafeKit sur 2 nœuds Windows.

Remarque : la version gratuite inclut toutes les fonctionnalités de SafeKit. À la fin de l'essai, vous pouvez activer des clés de licence permanentes sans désinstaller le package.

-

Pour ouvrir le pare-feu Windows, sur les deux nœuds démarrez un powershell en tant qu'administrateur et tapez

c:/safekit/private/bin/firewallcfg add -

Pour initialiser le mot de passe de l'utilisateur admin par défaut de la console, sur les deux nœuds démarrez un powershell en tant qu'administrateur et tapez

c:/safekit/private/bin/webservercfg.ps1 -passwd mdp- Utilisez des caractères alphanumériques pour le mot de passe (pas de caractères spéciaux).

- mdp doit être le même sur les deux nœuds.

-

Exclure des analyses antivirus C:\safekit\ (le répertoire d'installation par défaut) et tous les dossiers répliqués que vous allez définir.

Les antivirus peuvent rencontrer des problèmes de détection avec SafeKit en raison de son intégration étroite avec le système d'exploitation, de ses mécanismes d'IP virtuelle, de sa réplication en temps réel et du redémarrage de services critiques.

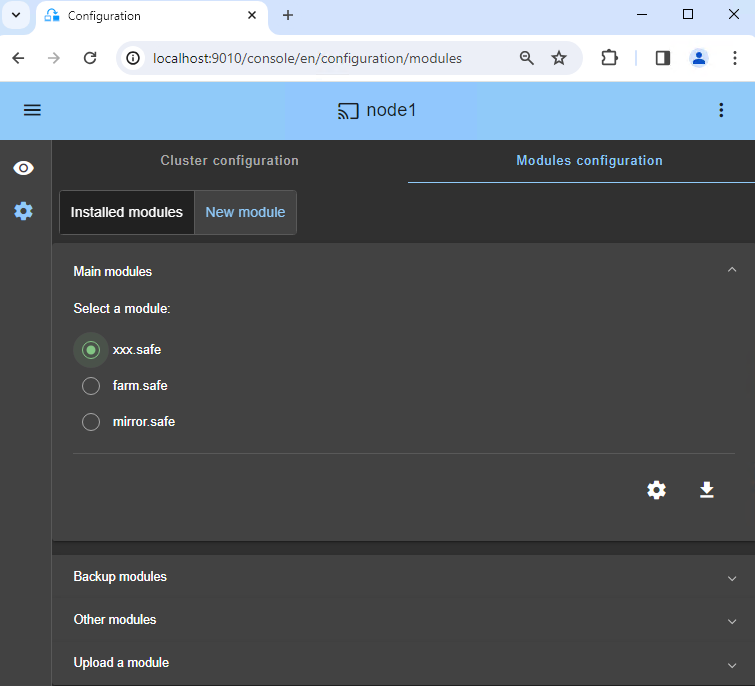

Installation du module sous Windows

-

Téléchargez le module hyperv.safe.

Le module est gratuit. Il contient les fichiers userconfig.xml et les scripts de redémarrage.

- Mettez hyperv.safe sous C:\safekit\Application_Modules\generic\.

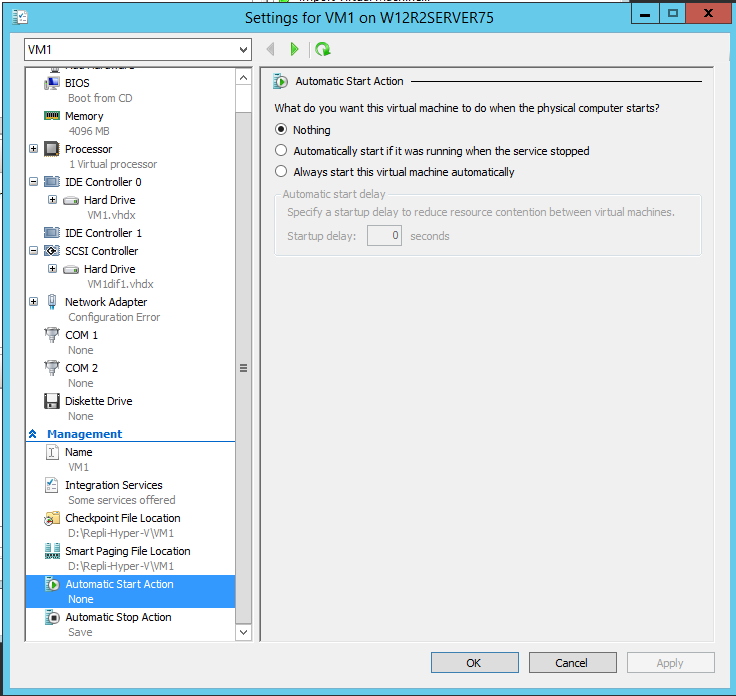

La configuration Hyper-V est présentée avec une machine virtuelle nommée VM1 et contenant l'application à redémarrer en cas de panne.

Vous devrez répéter cette configuration pour toutes les VM que vous souhaitez répliquer et redémarrer. SafeKit prend en charge jusqu'à 25 machines virtuelles.

1. Prérequis

Les fichiers de la machine virtuelle VM1 (fichier de configuration de VM1, disque dur virtuel...) doivent être placés dans un même dossier : ce dossier sera répliqué par SafeKit.

Assurez-vous que le ou les noms des switchs virtuels référencés par la machine virtuelle existent sur les deux serveurs Hyper-V et correspondent au même réseau physique.

Si tous les fichiers de VM1 ne sont pas dans le même dossier, utilisez le gestionnaire Hyper-V :

- Exporter VM1 dans un dossier, par exemple dans D:\Repli-Hyper-V

- Cet export créera un dossier D:\Repli-Hyper-V\VM1\ contenant tous les fichiers de VM1

- Supprimer VM1 de l'inventaire du gestionnaire Hyper-V

- Importer VM1, précédemment exporté, dans le gestionnaire Hyper-V

VM1 ne doit être créé que sur un seul nœud. La seule chose à créer sur l'autre nœud est le répertoire de VM1 (D:\Repli-Hyper-V\VM1\).

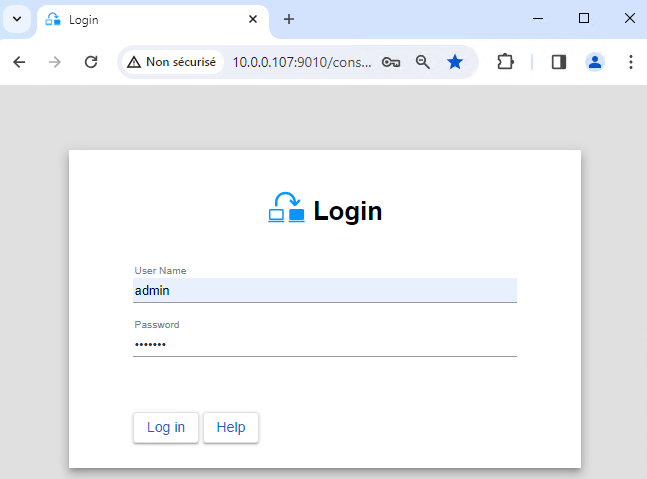

2. Lancez la console SafeKit

- Lancez la console Web dans un navigateur sur un nœud du cluster en vous connectant à

http://localhost:9010. - Entrez

admincomme nom d'utilisateur et le mot de passe défini lors de l'installation.

Vous pouvez également exécuter la console dans un navigateur sur un poste de travail externe au cluster.

La configuration de SafeKit se fait sur les deux nœuds à partir d'un seul navigateur.

Pour sécuriser la console Web, consultez 11. Sécurisation du service web de SafeKit dans le Guide de l'utilisateur.

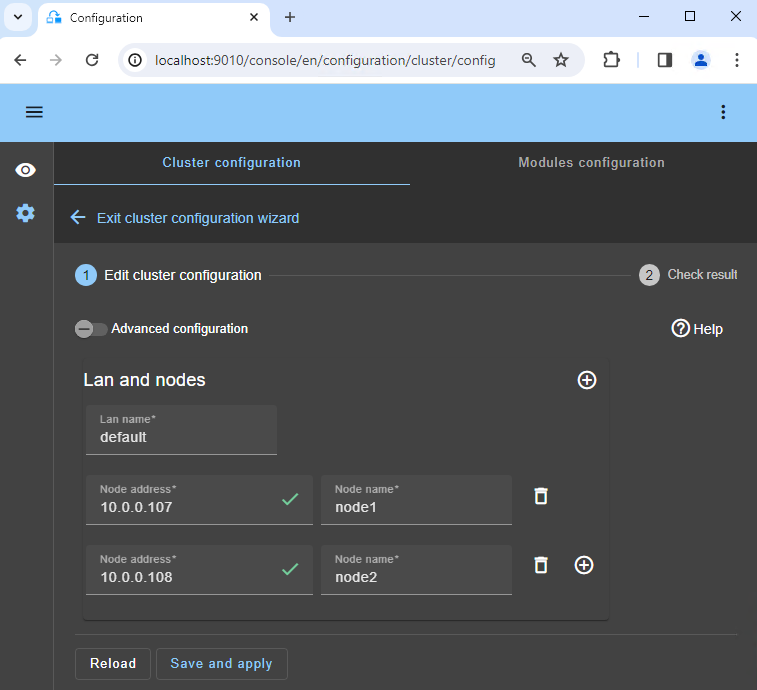

3. Configurer les adresses des nœuds

- Entrez les adresses IP des nœuds et appuyez sur la touche Tabulation pour vérifier la connectivité et remplir le nom des nœuds.

- Ensuite, cliquez sur

Save and applypour enregistrer la configuration.

Si le nœud 1 ou le nœud 2 a une couleur rouge, vérifiez la connectivité du navigateur aux deux nœuds et vérifiez le pare-feu sur les deux nœuds pour résoudre le problème.

Si vous le souhaitez, vous pouvez ajouter un nouveau LAN pour un deuxième heartbeat et pour un réseau de réplication dédié.

Cette opération placera les adresses IP dans le fichier cluster.xml sur les deux nœuds (plus d'informations dans le training avec les lignes de commande).

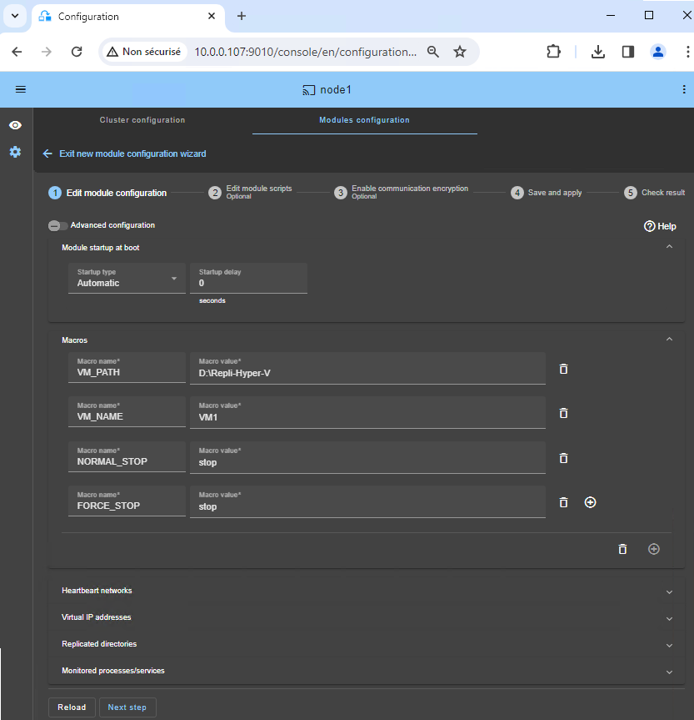

5. Configurer le module

- Choisissez un démarrage

Automaticdu module au boot sans délai. - Normalement, vous disposez d'un seul réseau

Heartbeatsur lequel la réplication est effectuée. Mais vous pouvez définir un réseau privé si nécessaire (en ajoutant un LAN à l'étape 3). - Mettez dans

VM_PATH, le chemin racine du répertoire répliqué (D:\Repli-Hyper-V). - Entrez dans

VM_NAME, le nom de la machine virtuelle (VM1).

Nous supposons que tous les fichiers VM1 se trouvent dans D:\Repli-Hyper-V\VM1\ (voir les prérequis). Ce répertoire sera répliqué en temps réel par SafeKit.

Les valeurs NORMAL_STOP et FORCE_STOP peuvent être "stop", "save" ou "off":

- "

stop" arrête la VM lorsque le module est arrêté. - "

save" enregistre l'état actuel de la VM (suspension) lorsque le module est arrêté. - "

off" éteint la VM (mise hors tension) lorsque le module est arrêté.

"stop" est recommandé car il provoque l'arrêt puis le redémarrage de la VM lorsque le module est arrêté et redémarré. Ainsi, si l'application à l'intérieur de la VM échoue, elle est redémarrée.

Ce sera le cas, par exemple, lors du basculement entre les rôles principal et secondaire.

Vous n'avez pas besoin de configurer une adresse IP virtuelle. La VM1 sera redémarrée sur l'Hyper-V secondaire avec son adresse IP physique, et cette adresse IP sera reroutée.

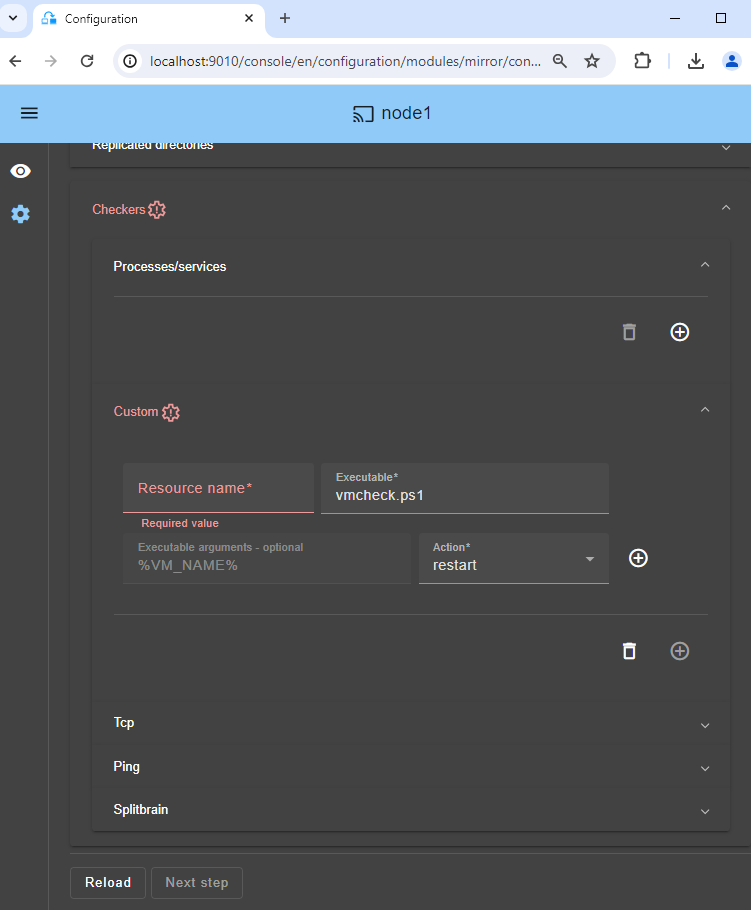

6. Custom checker pour détecter un dysfonctionnement de la VM

Le custom checker envoie des messages de heartbeat de l'hôte à la VM à intervalles réguliers. C'est alors le travail du service Hyper-V Heartbeat installé dans la VM d'envoyer une réponse à chacun de ces messages de heartbeat.

Si le service Hyper-V Heartbeat ne répond pas au message (VM verrouillée, crashée ou a cessé de fonctionner), alors le custom checker exécute une action pour redémarrer la VM sur le même nœud Hyper-V ou sur l'autre.

- Cliquez sur

Checkers / Custom(voir image). - Définissez simplement le nom de votre choix dans

Resource name(exemple VM1).Resource nameidentifie la machine virtuelle avec un nom de ressource dans SafeKit :custom.VM1. - Avec

restartdansAction, la VM est redémarrée sur le même nœud Hyper-V. Après 3 redémarrages infructueux en 24 heures, le module hyperv SafeKit s'arrête sur le nœud primaire et il y a un basculement de la VM sur le nœud secondaire. - Si vous définissez

stopstartdansAction, il y a un basculement direct sur l'autre nœud Hyper-V dès que la VM ne répond plus aux heartbeats.

Pour la maintenance, si vous souhaitez arrêter la machine virtuelle, le custom checker la redémarrera automatiquement. Pour éviter cela, vous pouvez temporairement suspendre le checker. Ou vous pouvez le supprimer en cliquant sur Advanced configuration (bouton en haut de la configuration).

7. Modifier les scripts (facultatif)

- Ne modifiez pas les scripts.

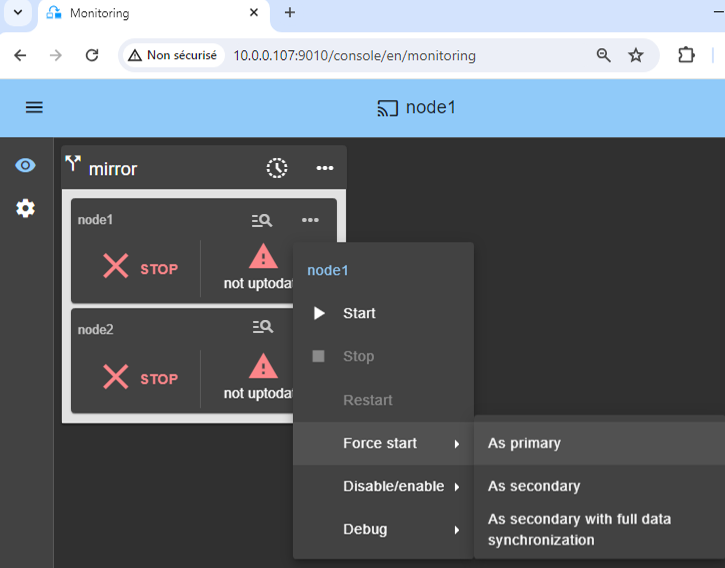

11. Démarrez le nœud avec des données à jour

- Si le nœud 1 possède le répertoires répliqué

VM1/à jour, sélectionnez-le et démarrez-le en tant que primaireAs primary.

Lorsque le nœud 2 sera démarré, toutes les données seront copiées du nœud 1 vers le nœud 2.

Si vous faites le mauvais choix, vous courez le risque de synchroniser des données obsolètes sur les deux nœuds.

Il est également supposé que VM1 est arrêtée sur le nœud 1 afin que SafeKit installe les mécanismes de réplication puis démarre VM1 dans le script start_prim.

Utilisez Start pour les démarrages suivants : SafeKit retient le serveur le plus à jour. Le démarrage As primary est un démarrage spécial la première fois ou lors d'opérations exceptionnelles.

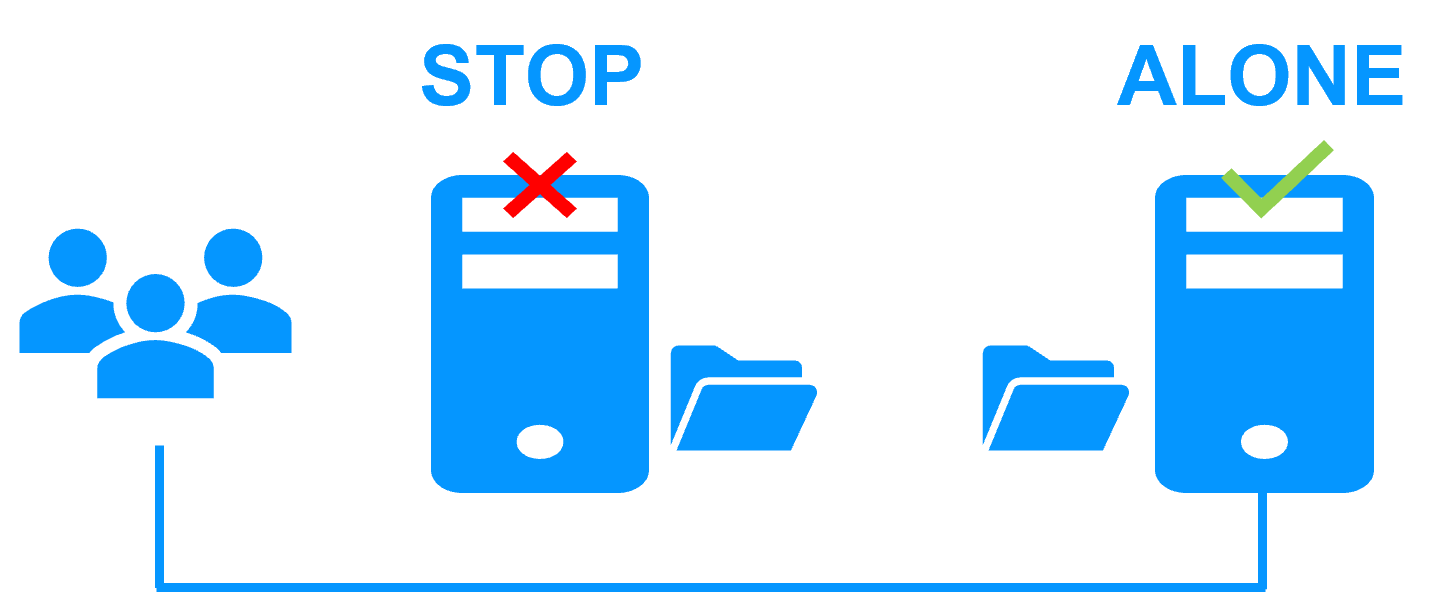

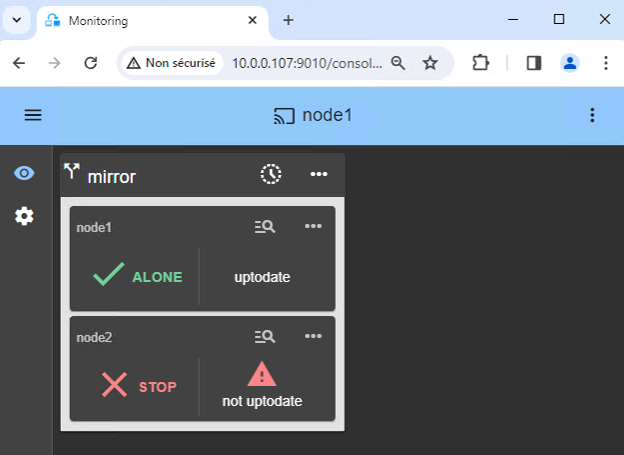

12. Attendez le passage à ALONE (vert)

- Le nœud 1 doit atteindre l'état ALONE (vert), ce qui signifie que le script

start_prima été exécuté sur le nœud 1.

Si ALONE (vert) n’est pas atteint ou si VM1 n'est pas démarrée, analysez pourquoi avec le journal du module du nœud 1.

- cliquez sur l'icône « journal » de

node1pour ouvrir le journal du module et recherchez des messages d'erreur tels qu'un checker détectant une erreur et arrêtant le module. - cliquez sur

start_primdans le journal : les messages de sortie du script sont affichés à droite et des erreurs peuvent être détectées comme VM1 mal démarrée.

Si le cluster est dans l'état WAIT (rouge) not uptodate, STOP (rouge) not upodate, arrêtez le nœud WAIT et forcer son démarrage en tant que primaire.

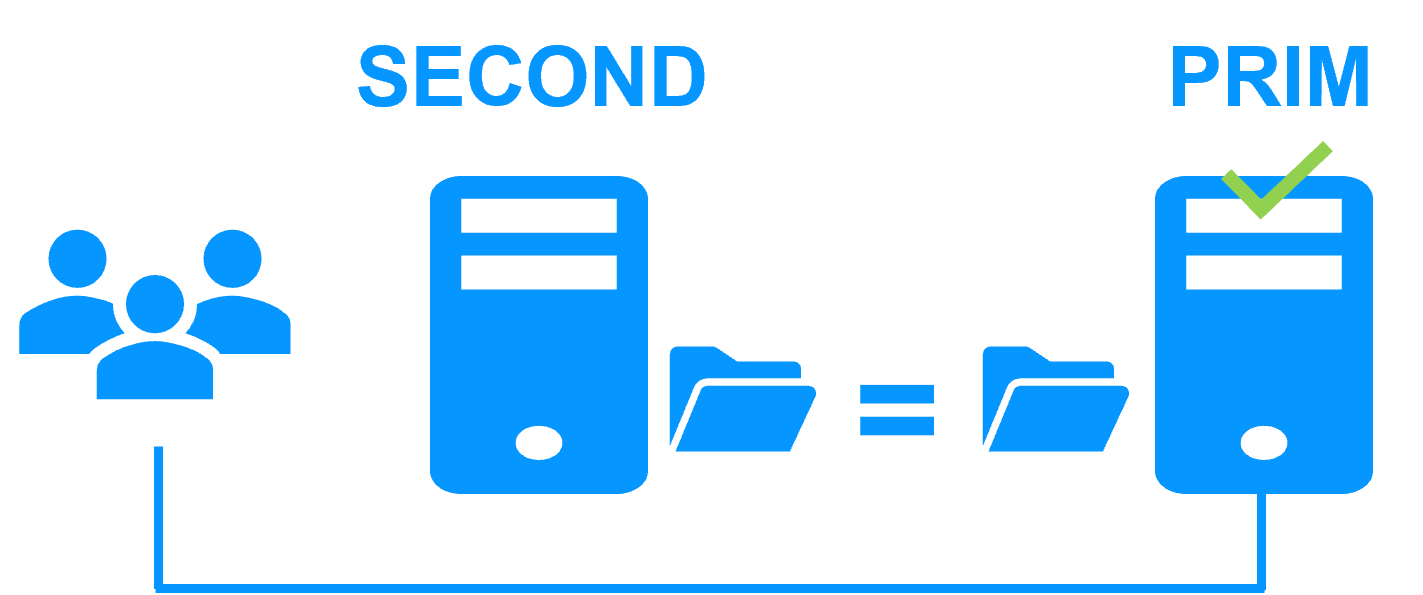

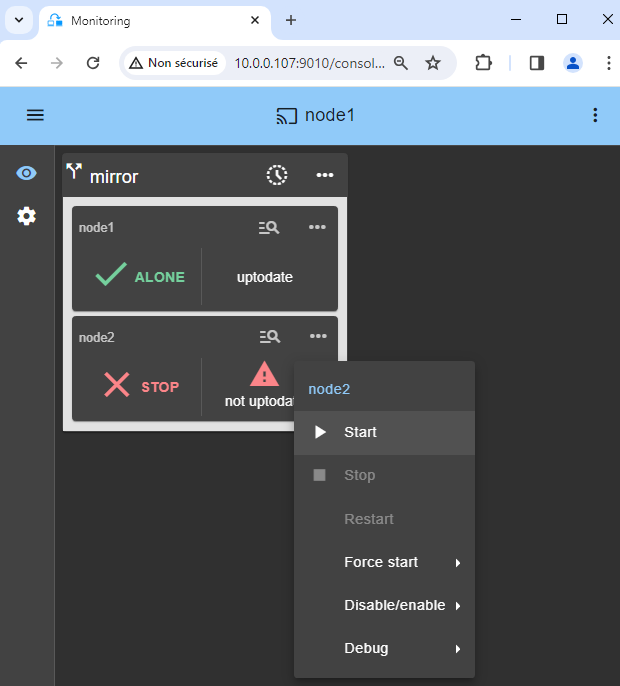

13. Démarrer le nœud 2

- Démarrez le nœud 2 avec son menu contextuel.

- Attendez l'état SECOND (vert).

Le nœud 2 reste dans l'état SECOND (orange) lors de la resynchronisation des répertoires répliqués (copie du nœud 1 vers le nœud 2).

Cela peut prendre un certain temps en fonction de la taille des fichiers à resynchroniser dans les répertoires répliqués et de la bande passante du réseau.

Pour voir la progression de la copie, consultez le log du module et les ressources de réplication du nœud 2.

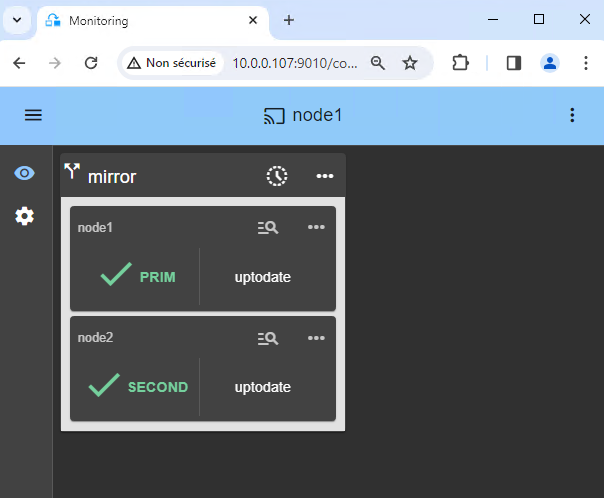

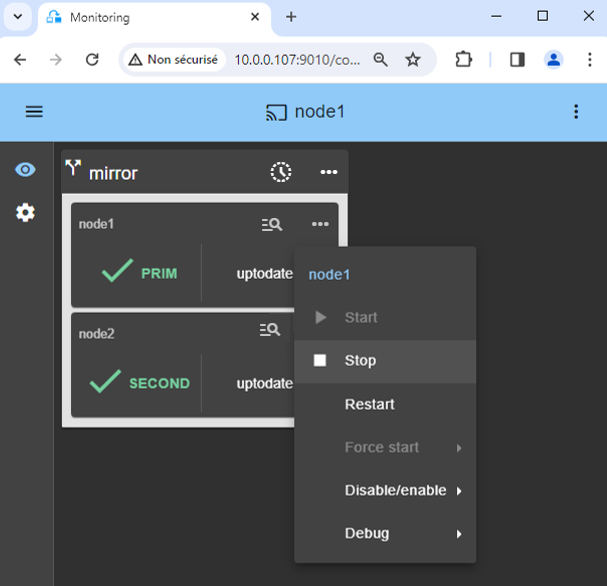

15. Tests

- Arrêtez le nœud PRIM en faisant défiler son menu contextuel et en cliquant sur

Stop. - Vérifiez qu'il y a un basculement sur le nœud 2 qui doit devenir ALONE (vert).

- Vérifiez avec le gestionnaire Hyper-V que VM1 s'exécute sur le nœud 2.

Si ALONE (vert) n’est pas atteint sur le nœud 2 ou si VM1 n'est pas démarrée, analysez pourquoi avec le journal du module du nœud 2.

- cliquez sur l'icône « journal » de

node2pour ouvrir le journal du module et recherchez des messages d'erreur tels qu'un checker détectant une erreur et arrêtant le module. - cliquez sur

start_primdans le journal : les messages de sortie du script sont affichés à droite et des erreurs peuvent être détectées comme VM1 mal démarrée.

Comme le script start_prim importe la machine virtuelle sur le nœud 2, le basculement peut échouer à cause des paramètres Hyper-V (voir cet article).

Si tout va bien, lancez un démarrage du noeud 1, qui resynchronisera les répertoires répliqués depuis le noeud 2.

Si les choses vont mal, arrêtez le noeud 2 et forcez le démarrage en tant que primaire du noeud 1, qui redémarrera avec ses données localement saines au moment de l'arrêt.

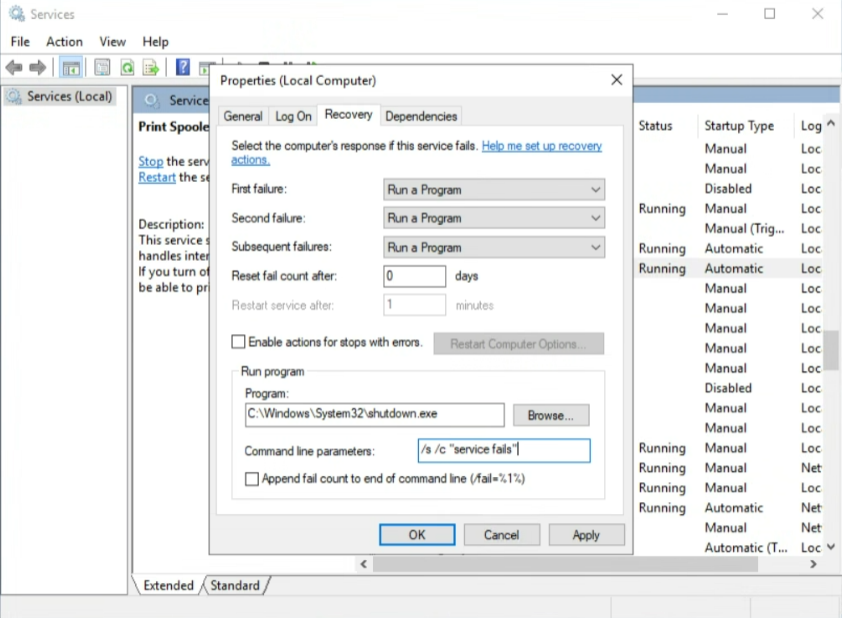

16. Redémarrage automatique en cas de panne d'un service critique dans la VM

Si vous souhaitez un redémarrage ou un basculement automatique lorsqu'un service critique à l'intérieur de la VM tombe en panne, vous pouvez configurer les propriétés de récupération du service (voir image).

Vous devez d'abord configurer le custom checker décrit précédemment.

Et puis dans Microsoft Service Manager à l'intérieur de la VM, sélectionnez votre service critique et dans la propriété de récupération du service, il vous suffit de configurer le shutdown de la VM en cas de panne du service critique.

Pour cela, dans les options de Recovery de votre service critique, choisissez "Run a program" en cas de panne et dans les options de Run program, définissez "C:\Windows\System32\shutdown.exe" et dans "Command line parameters", définissez /s /c "service fails".

Bien sûr, vous pouvez mettre en œuvre une récupération plus subtile avec vos propres scripts. Mais sachez simplement que l'arrêt de la VM activera le custom checker dans l'hôte. Le custom checker détectera que le heartbeat Hyper-V ne répond plus et redémarrera la VM sur le même serveur Hyper-V ou effectuera un basculement sur l'autre serveur Hyper-V (en fonction de sa configuration).

Pour tester la fonctionnalité, utilisez le Gestionnaire des tâches et supprimez le processus (End task) associé au service critique. Un arrêt propre du service via Service Manager ou la commande "net stop" ne déclenche pas l'action de récupération dans Windows Service Manager.

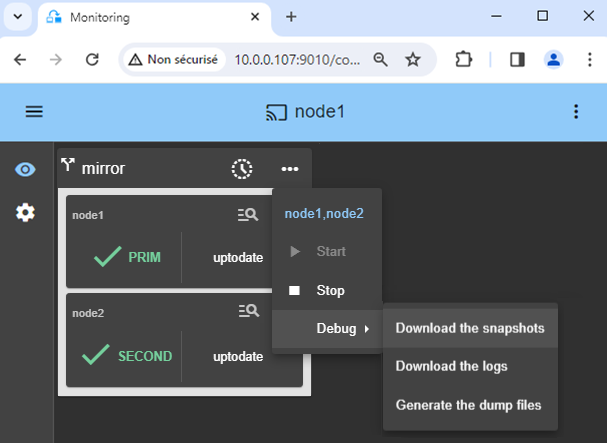

18. Support

- Pour obtenir du support, prenez deux

snapshotsSafeKit (deux fichiers .zip), un pour chaque nœud. - Si vous avez un compte sur https://support.evidian.com, téléchargez-les dans l'outil call desk.

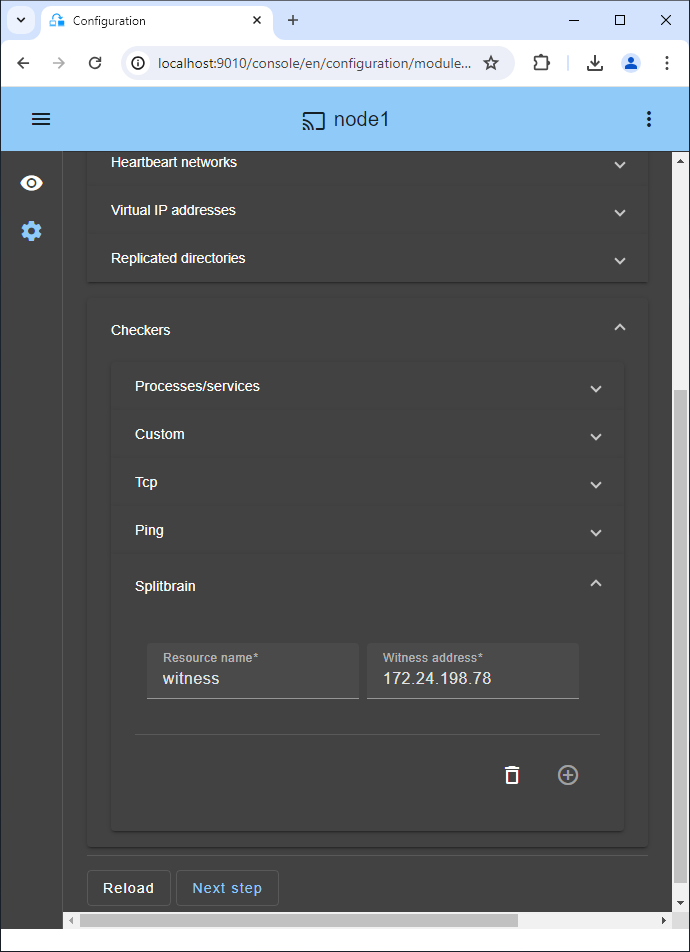

19. Si nécessaire, configurez un checker splitbrain

- Voir ci-dessous "Quels sont les différents scénarios en cas d'isolement réseau dans un cluster ?" pour savoir si vous devez configurer un checker splitbrain.

- Allez dans la configuration du module et cliquez sur

Checkers / Splitbrain(voir image) pour modifier les paramètres du splitbrain. Enregistrez et appliquezla nouvelle configuration pour la redéployer sur les deux nœuds (le module doit être arrêté sur les deux nœuds pour enregistrer et appliquer).

Paramètres :

Resource nameidentifie le témoin avec un nom de ressource :splitbrain.witness. Vous pouvez modifier cette valeur pour identifier le témoin.Witness addressest l'argument du ping lorsqu'un nœud passe de PRIM à ALONE ou de SECOND à ALONE. Changez cette valeur avec l'IP du témoin (un élément robuste, typiquement un routeur).- Remarque : vous pouvez définir plusieurs adresses IP séparées par des espaces. Attention, les adresses IP doivent être accessibles depuis un nœud mais pas depuis l'autre en cas d'isolement du réseau.

Un seul réseau

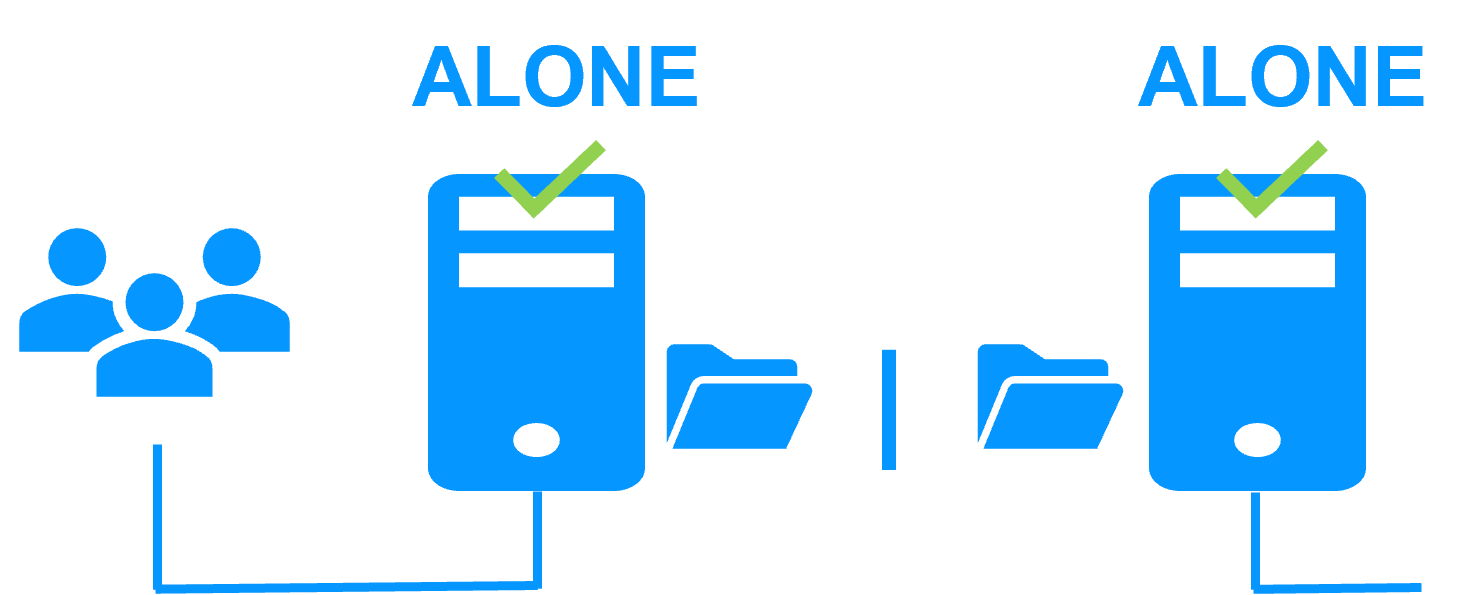

Lorsqu'il y a un isolement réseau, le comportement par défaut est :

- comme les heartbeats sont perdus pour chaque nœud, chaque nœud passe en ALONE et exécute l'application avec son adresse IP virtuelle (double exécution de l'application modifiant ses données locales),

- lorsque l'isolement est réparé, un nœud ALONE est obligé de s'arrêter et de resynchroniser ses données depuis l'autre nœud,

- à la fin, le cluster est PRIM-SECOND (ou SECOND-PRIM selon la détection d'adresse IP virtuelle en double faite par Windows).

Deux réseaux avec un réseau de réplication dédié

Lorsqu'il y a un isolement réseau, le comportement avec un réseau de réplication dédié est :

- un réseau de réplication dédié est implémenté sur un réseau privé,

- les heartbeats sur le réseau de production sont perdus (réseau isolé),

- les heartbeats sur le réseau de réplication fonctionnent (réseau non isolé),

- le cluster reste à l'état PRIM/SECOND.

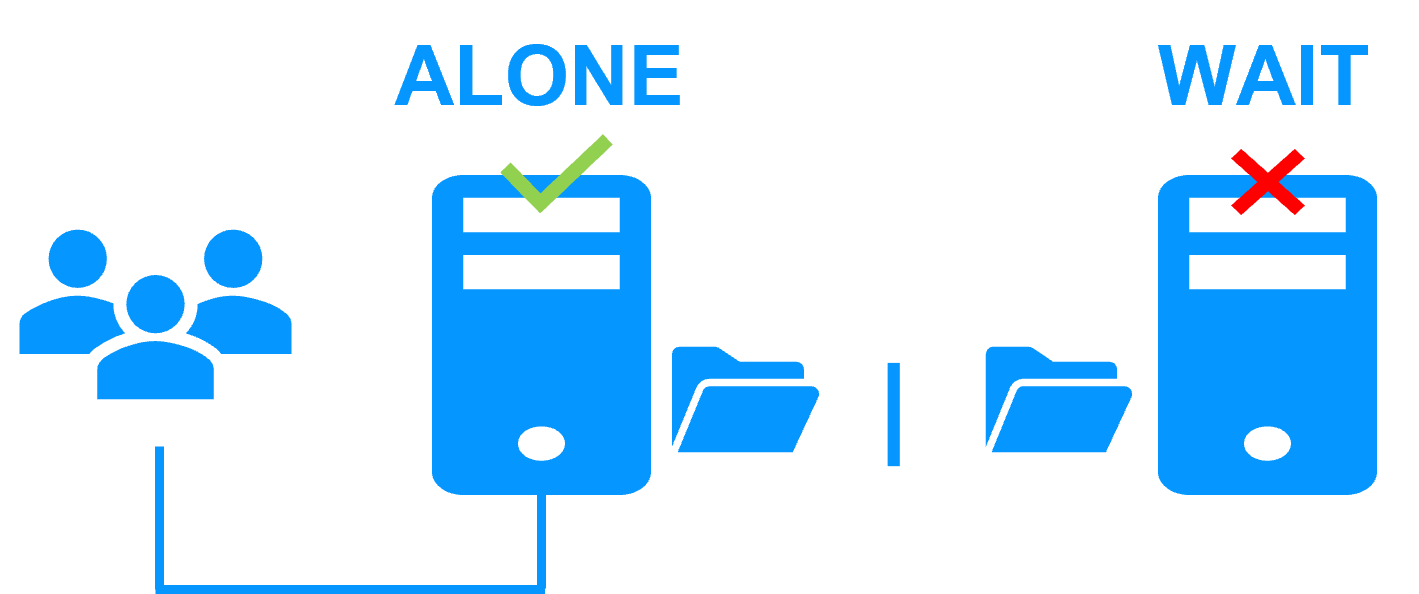

Un seul réseau et un checker split-brain

Lorsqu'il y a un isolement du réseau, le comportement avec un split-brain checker est :

- un split-brain checker a été configuré avec l'adresse IP d'un témoin (typiquement un routeur),

- le split-brain agit lorsqu'un serveur passe de PRIM à ALONE ou de SECOND à ALONE,

- en cas d'isolement du réseau, avant de passer en ALONE, les deux nœuds testent l'adresse IP,

- le nœud qui peut accéder à l'adresse IP passe à ALONE, l'autre passe à WAIT,

- lorsque l'isolement est réparé, le nœud WAIT resynchronise ses données et devient SECOND.

Remarque : Si le témoin est en panne ou déconnecté, les deux nœuds passent à WAIT et l'application n'est plus en cours d'exécution. C'est pourquoi vous devez choisir un témoin robuste comme un routeur.

Partage de charge réseau et reprise sur panne |

|

|

Windows farm |

Linux farm |

| Generic farm > | Generic farm > |

| Microsoft IIS > | - |

| NGINX > | |

| Apache > | |

| Amazon AWS farm > | |

| Microsoft Azure farm > | |

| Google GCP farm > | |

| Other cloud > | |

Architectures de clustering avancée

Plusieurs modules peuvent être déployés dans le même cluster. Ainsi, des architectures de clustering avancées peuvent être mises en œuvre :

- un cluster qui mixte ferme et miroir avec le déploiement d’un module ferme et d’un module miroir dans le même cluster,

- un cluster actif/actif avec réplication en déployant plusieurs modules miroirs sur 2 serveurs,

- un cluster Hyper-V ou un cluster KVM avec réplication temps réel et reprise de machines virtuelles complètes entre 2 hyperviseurs actifs,

- un cluster N-1 avec le déploiement de N modules miroirs sur N+1 serveurs.

Réplication de fichiers temps réel et reprise sur panne |

|||||||||||||||||||||||||||||||

|

Windows mirror |

Linux mirror |

||||||||||||||||||||||||||||||

| Generic mirror > | Generic mirror > | ||||||||||||||||||||||||||||||

| Microsoft SQL Server > | - | ||||||||||||||||||||||||||||||

| Oracle > | |||||||||||||||||||||||||||||||

| MariaDB > | |||||||||||||||||||||||||||||||

| MySQL > | |||||||||||||||||||||||||||||||

| PostgreSQL > | |||||||||||||||||||||||||||||||

| Firebird > | |||||||||||||||||||||||||||||||

| Windows Hyper-V > | Linux KVM > | ||||||||||||||||||||||||||||||

| - | Docker > Podman > Kubernetes K3S > |

||||||||||||||||||||||||||||||

| - | |||||||||||||||||||||||||||||||

| - | Elasticsearch > | ||||||||||||||||||||||||||||||

| Milestone XProtect > | - | ||||||||||||||||||||||||||||||

| Genetec SQL Server > | - | ||||||||||||||||||||||||||||||

|

Hanwha Vision > Hanwha Wisenet > |

- | ||||||||||||||||||||||||||||||

| Nedap AEOS > | - | ||||||||||||||||||||||||||||||

|

Siemens SIMATIC WinCC > Siemens SIMATIC PCS 7 > Siemens Desigo CC > Siemens Siveillance suite > Siemens Siveillance VMS > Siemens SiPass > Siemens SIPORT > |

- | ||||||||||||||||||||||||||||||

|

Bosch AMS > Bosch BIS > Bosch BVMS > |

- | ||||||||||||||||||||||||||||||

| Amazon AWS mirror > | |||||||||||||||||||||||||||||||

| Microsoft Azure mirror > | |||||||||||||||||||||||||||||||

| Google GCP mirror > | |||||||||||||||||||||||||||||||

| Other cloud > | |||||||||||||||||||||||||||||||

- Demonstration

- Examples of redundancy and high availability solution

- Evidian SafeKit sold in many different countries with Milestone

- 2 solutions: virtual machine cluster or application cluster

- Distinctive advantages

- More information on the web site

| SafeKit avec le module Hyper-V ou le module KVM | Microsoft Hyper-V Cluster & VMware HA |

|

|

Notez que les solutions Hyper-V/SafeKit et KVM/SafeKit sont limitées à la réplication et au basculement de 25 machines virtuelles.

| HA de VMs avec le module Hyper-V ou KVM de SafeKit | HA d'application avec les modules applicatifs de SafeKit |

|

SafeKit dans 2 hyperviseurs

|

SafeKit dans 2 machines virtuelles ou physiques |

| Réplique plus de données (App+OS) | Réplique seulement les données applicatives |

|

Reboot de la machine virtuelle sur l'hyperviseur 2 si l'hyperviseur 1 crash Temps de reprise dépendant du reboot de l'OS |

Temps de reprise rapide avec redémarrage de l'application sur OS2 en cas de panne du serveur 1 Autour d'1 mn ou moins (voir RTO/RPO ici) Checker applicatif et reprise sur panne logicielle |

| Solution générique pour n'importe quelle application / OS | Scripts de redémarrage à écrire dans des modules applicatifs de haute disponibilité |

|

|

|

|

Cluster de type "shared nothing"" vs cluster à disque partagé |

|

|

|

|

|

|

|

|

Haute disponibilité vs tolérance aux fautes |

|

|

|

|

|

Réplication synchrone vs réplication asynchrone |

|

|

|

|

|

Réplication de fichiers au niveau octet vs réplication de disque au niveau du bloc |

|

|

|

|

|

Heartbeat, reprise sur panne et quorum pour éviter 2 serveurs maîtres |

|

|

|

|

|

|

|

Evidian SafeKit 8.2

Toutes les nouvelles fonctionnalités par rapport à la SafeKit 7.5 décrites dans le release notes

Packages

- Windows (with Microsoft Visual C++ Redistributable)

- Windows (without Microsoft Visual C++ Redistributable)

- Linux

- OS supportés et derniers fixes

Licence d'essai gratuit d'un mois

Documentation technique

Training

Information produit

Introduction

-

- Demonstration

- Examples of redundancy and high availability solution

- Evidian SafeKit sold in many different countries with Milestone

- 2 solutions: virtual machine or application cluster

- Distinctive advantages

- More information on the web site

- SafeKit training

-

- Cluster of virtual machines

- Mirror cluster

- Farm cluster

Installation, Console, CLI

- Install and setup / pptx

- Package installation

- Nodes setup

- Upgrade

- Web console / pptx

- Configuration of the cluster

- Configuration of a new module

- Advanced usage

- Securing the web console

- Command line / pptx

- Configure the SafeKit cluster

- Configure a SafeKit module

- Control and monitor

Advanced configuration

- Mirror module / pptx

- start_prim / stop_prim scripts

- userconfig.xml

- Heartbeat (<hearbeat>)

- Virtual IP address (<vip>)

- Real-time file replication (<rfs>)

- How real-time file replication works?

- Mirror's states in action

- Farm module / pptx

- start_both / stop_both scripts

- userconfig.xml

- Farm heartbeats (<farm>)

- Virtual IP address (<vip>)

- Farm's states in action

Troubleshooting

- Troubleshooting / pptx

- Analyze yourself the logs

- Take snapshots for support

- Boot / shutdown

- Web console / Command lines

- Mirror / Farm / Checkers

- Running an application without SafeKit

Support

- Evidian support / pptx

- Get permanent license key

- Register on support.evidian.com

- Call desk

![[SafeKit] Un cluster Hanwha Vision sans stockage partagé sur un SAN](/wp-content/uploads/2024/02/safekit-hyper-v.png)