Qu'est-ce que le RPO et le RTO avec des exemples ?

Evidian SafeKit

Qu'est-ce que le RPO et le RTO avec des exemples de solutions de haute disponibilité et de sauvegarde ?

Aperçu

Cet article étudie le RTO (Recovery Time Objective) et le RPO (Recovery Point Objective) avec des exemples de solutions de haute disponibilité et de sauvegarde.

Les solutions de haute disponibilité et de sauvegarde sont complémentaires. La première est pour le basculement automatique en cas de panne et la seconde est pour la récupération des données en cas de sinistre tel qu'un ransomware cryptant toutes les données.

L'article explique en détail le RTO et le RPO de SafeKit, un produit logiciel de haute disponibilité.

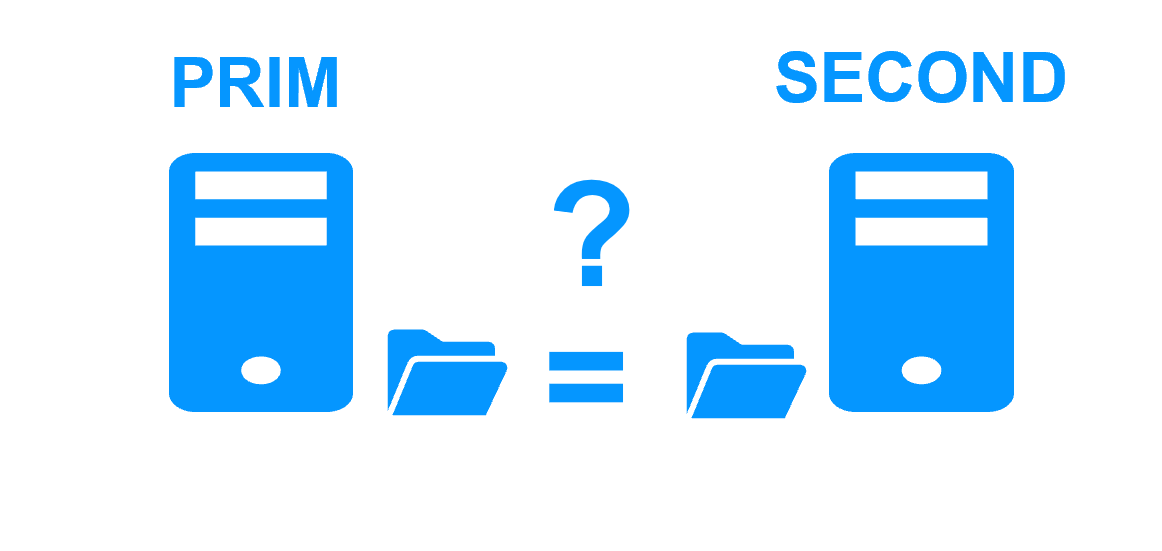

Qu'est-ce que le RPO ?

Le RPO (Recovery Point Objective) reflète la perte de données en cas de panne.

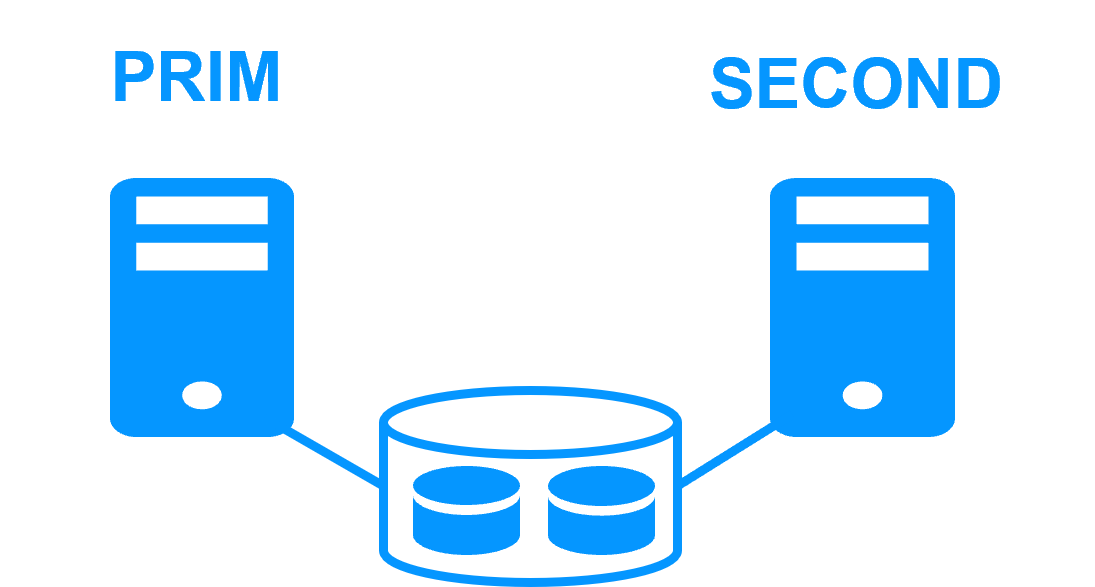

Si vous recherchez un cluster de haute disponibilité avec basculement automatique, alors le RPO doit être de 0. L'application est ainsi redémarrée sans perte de données. Soit vous pouvez choisir un cluster de haute disponibilité matériel avec disque partagé. Ou vous pouvez choisir un cluster de haute disponibilité logiciel avec réplication synchrone en temps réel pour avoir 0 perte de données.

Si vous mettez en place des solutions de sauvegarde, alors le RPO est supérieur à 0 et la récupération n'est pas automatique. Les administrateurs décident de la fréquence de réplication et du nombre de sauvegardes à conserver.

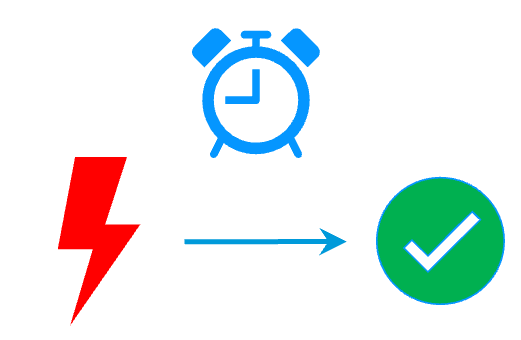

Qu'est-ce que le RTO ?

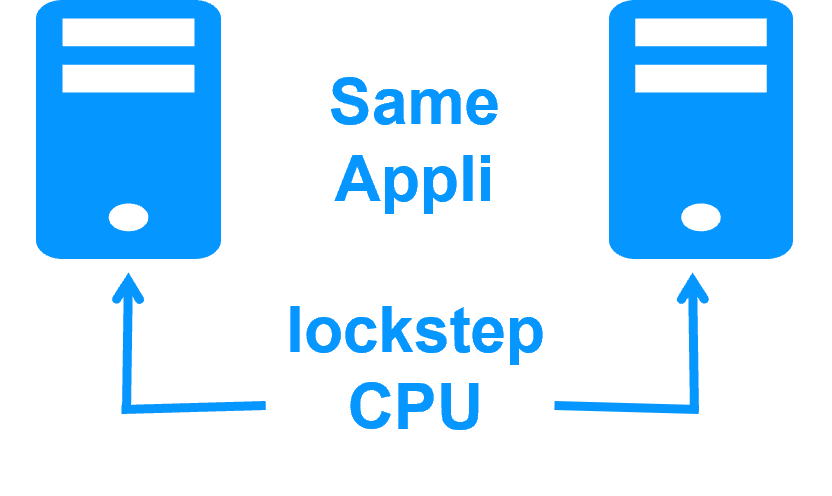

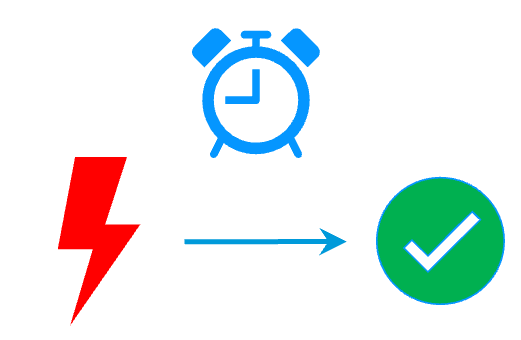

Le RTO (Recovery Time Objective) est le temps pendant lequel une application est indisponible en cas de panne.

Pour une application critique, le RTO doit être minimal. Pour cela, une solution de haute disponibilité est nécessaire avec redémarrage automatique de l'application en cas de panne matérielle ou logicielle. Le RTO est alors d'environ une minute : le temps de détection plus le temps de redémarrage automatique de l'application.

Avec une solution de sauvegarde, le RTO est généralement supérieur à plusieurs heures. Les administrateurs tenteront d'abord de réparer le matériel et de redémarrer l'application avec des données à jour. Le redémarrage à partir d'une sauvegarde est la dernière décision lorsque les actions précédentes ne fonctionnent pas, car ça entraîne une perte de données.

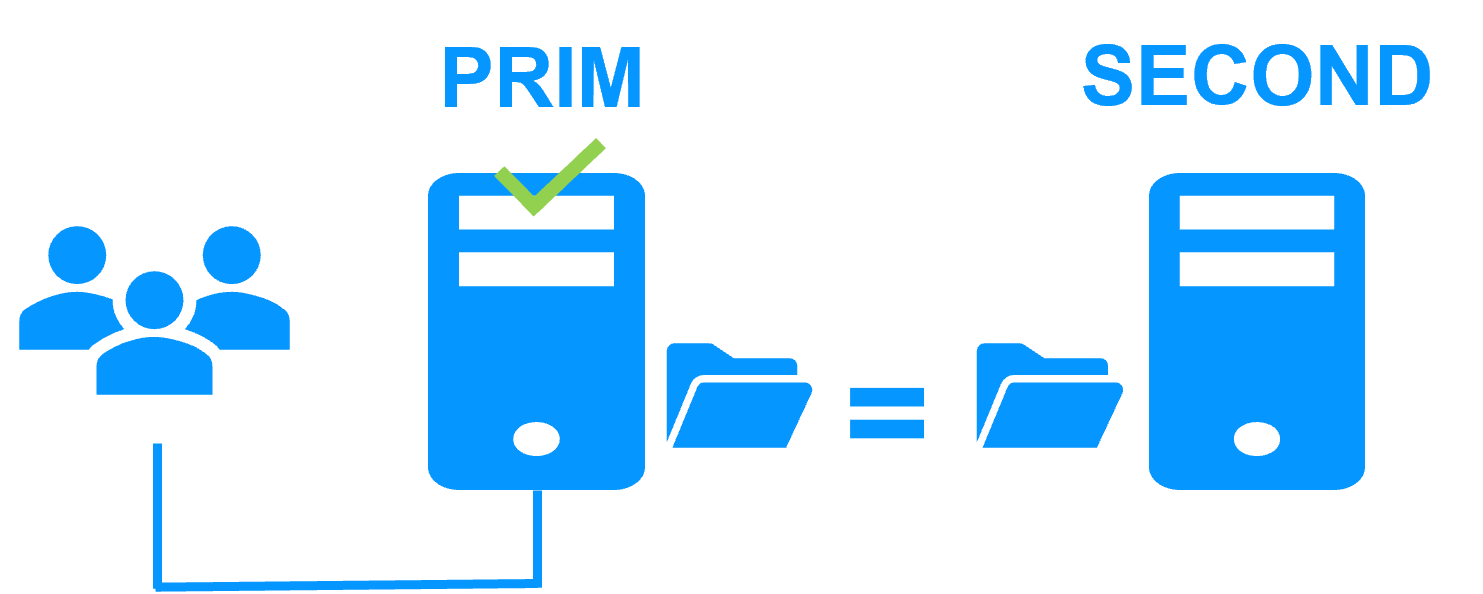

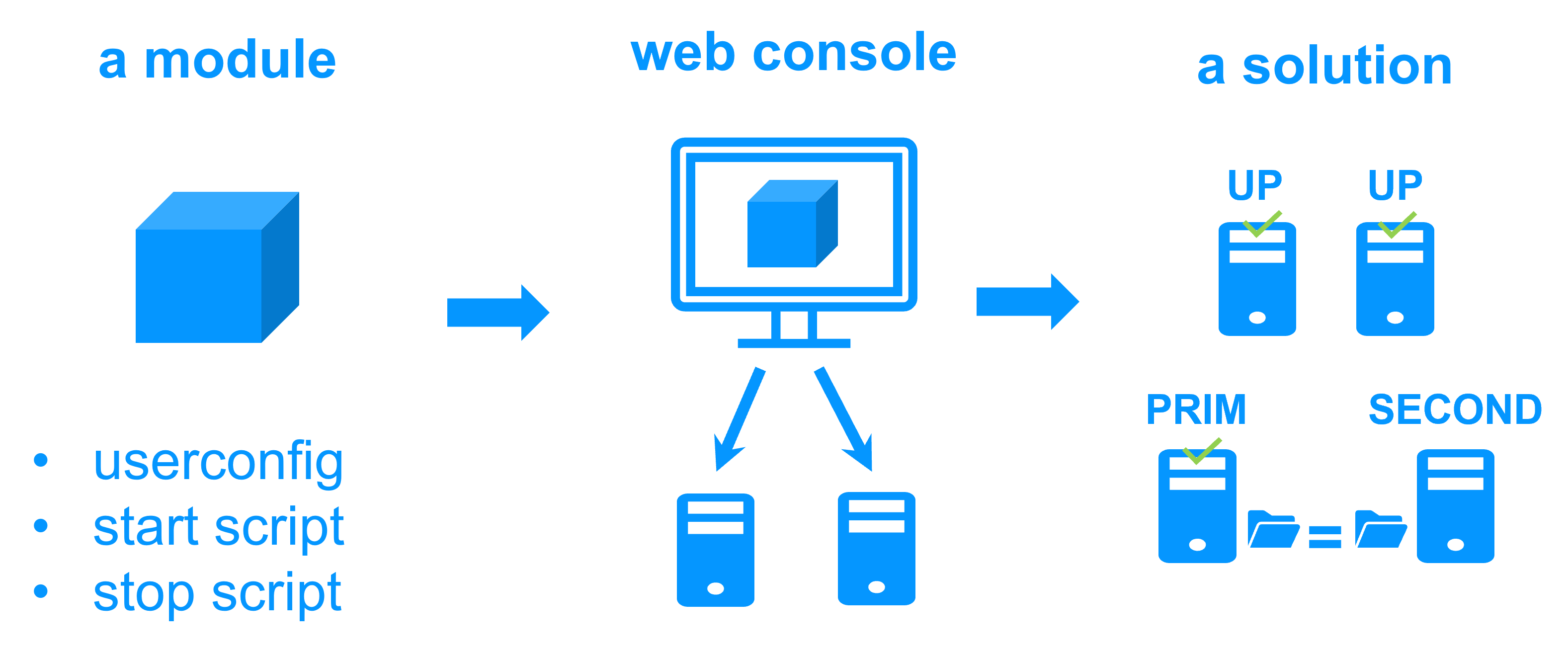

RTO avec l'exemple du cluster miroir de SafeKit

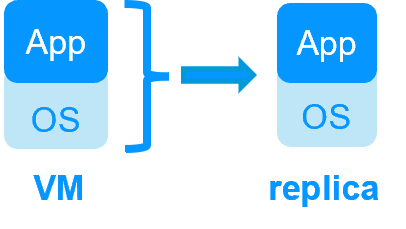

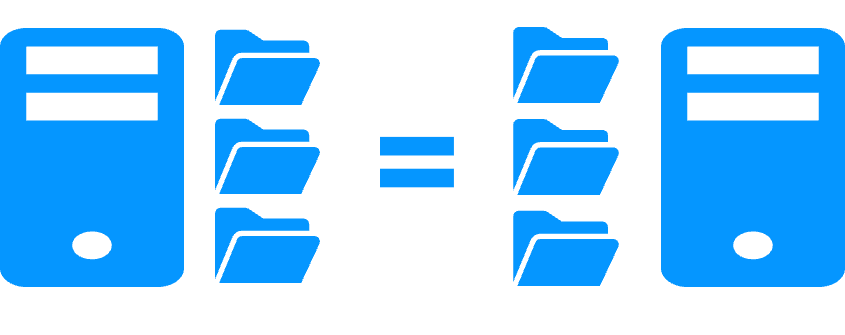

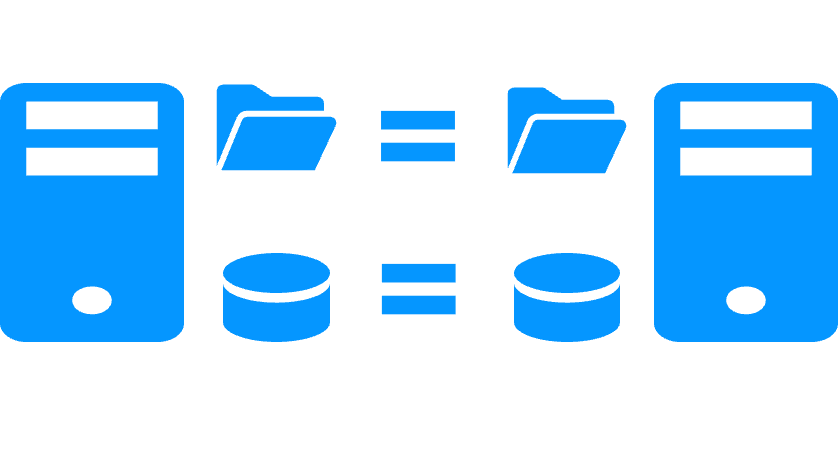

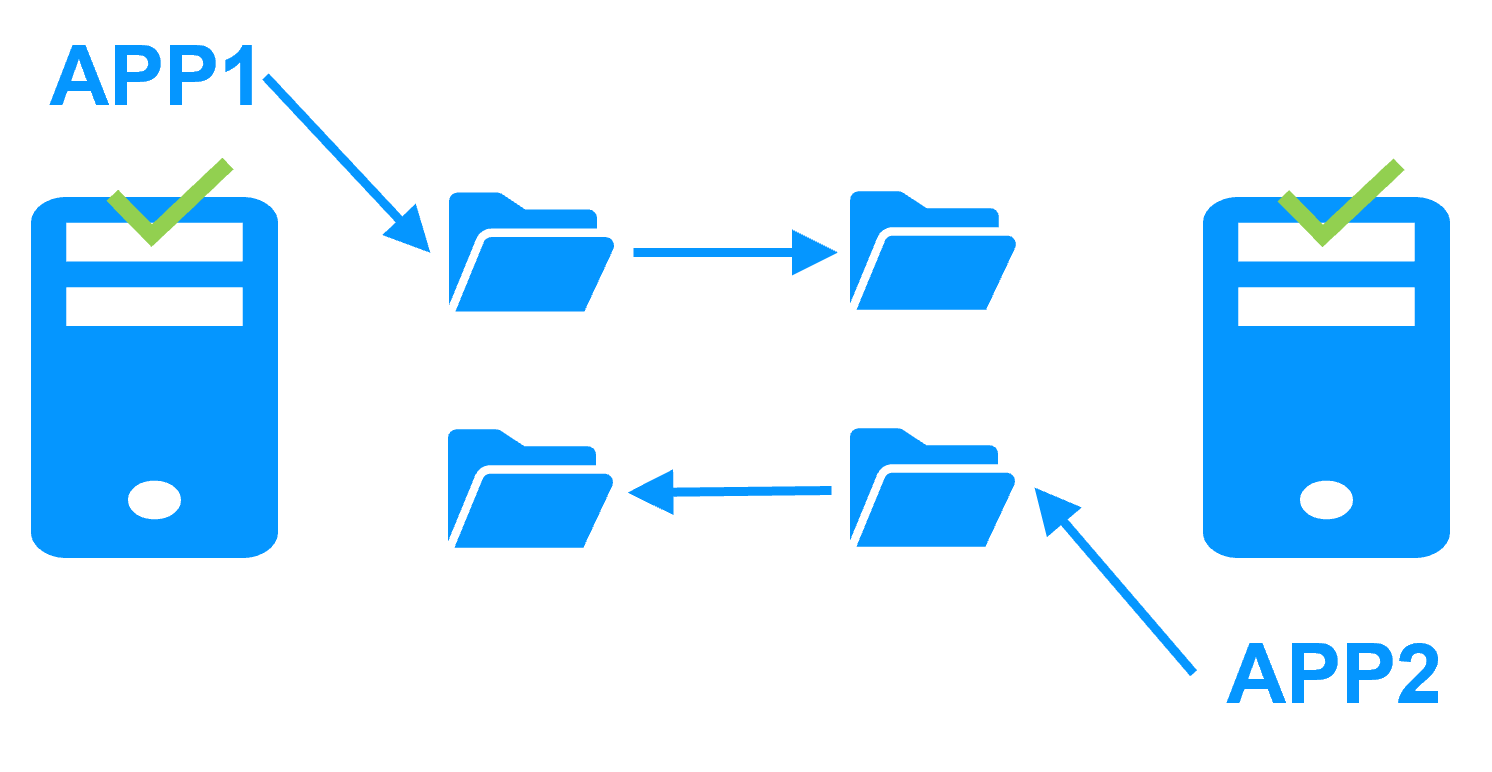

Le cluster miroir de SafeKit est un cluster logiciel de haute disponibilité avec réplication synchrone en temps réel des données et basculement applicatif automatique.

Le RTO du cluster miroir de SafeKit est de l'ordre de 1 mn et peut être diminué si vous configurez le timeout des heartbeats.

Pour une panne matérielle dans un cluster miroir, RTO = timeout des heartbeats (par défaut 30 s) + délai pour redémarrer l'application.

Pour une défaillance logicielle ou un basculement administrateur, RTO = temps d'arrêter l'application + temps de la redémarrer.

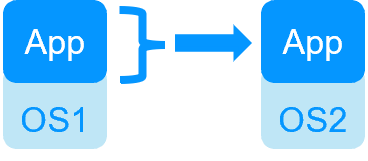

Avec les solutions qui redémarrent une machine virtuelle complète en cas de panne, le RTO inclut le temps de reboot de la machine virtuelle.

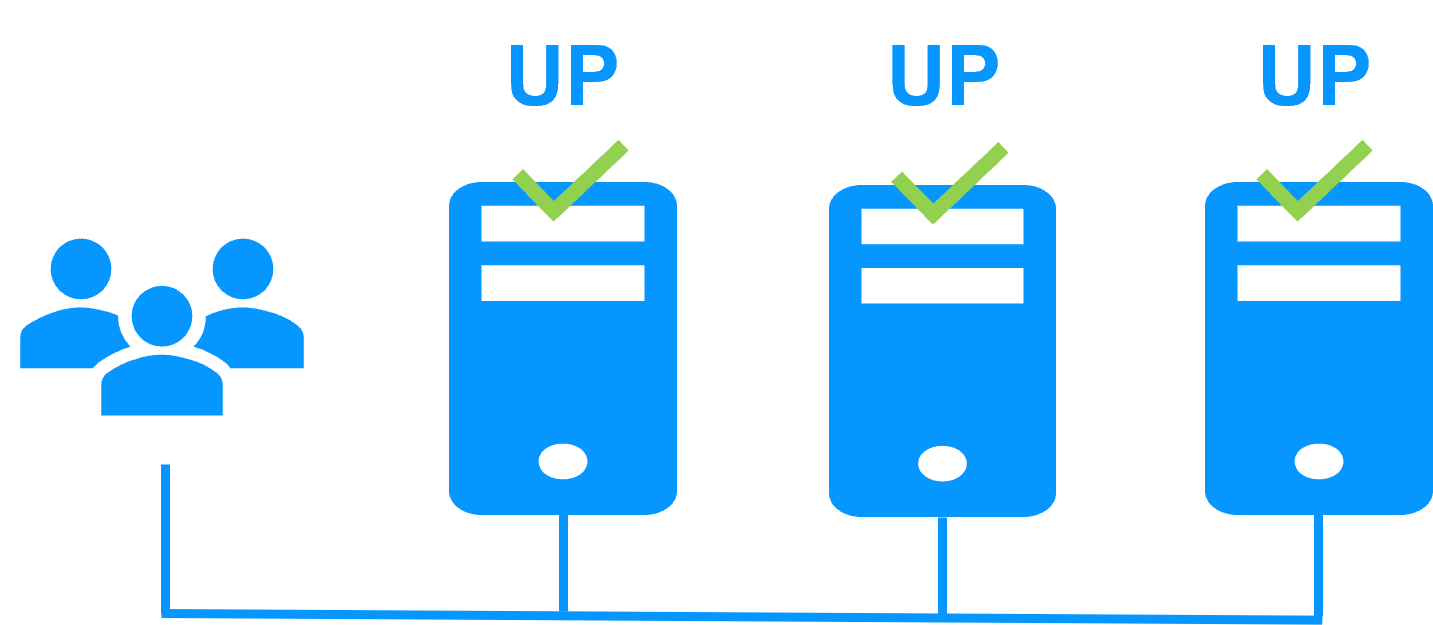

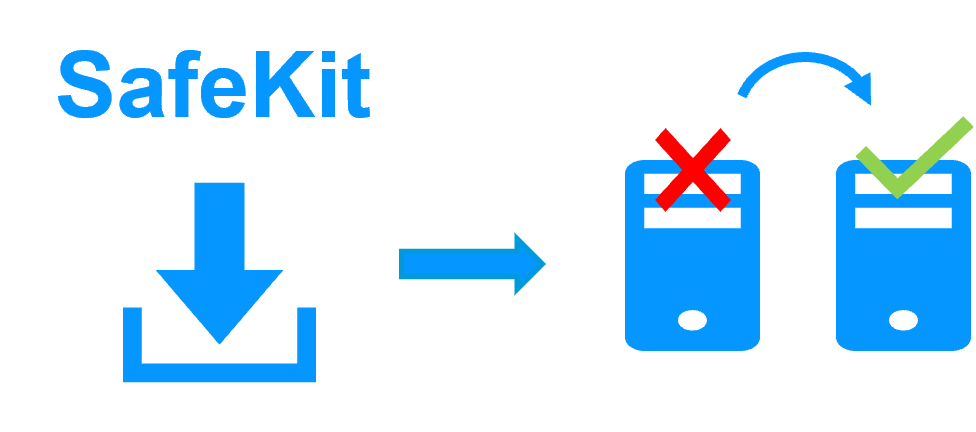

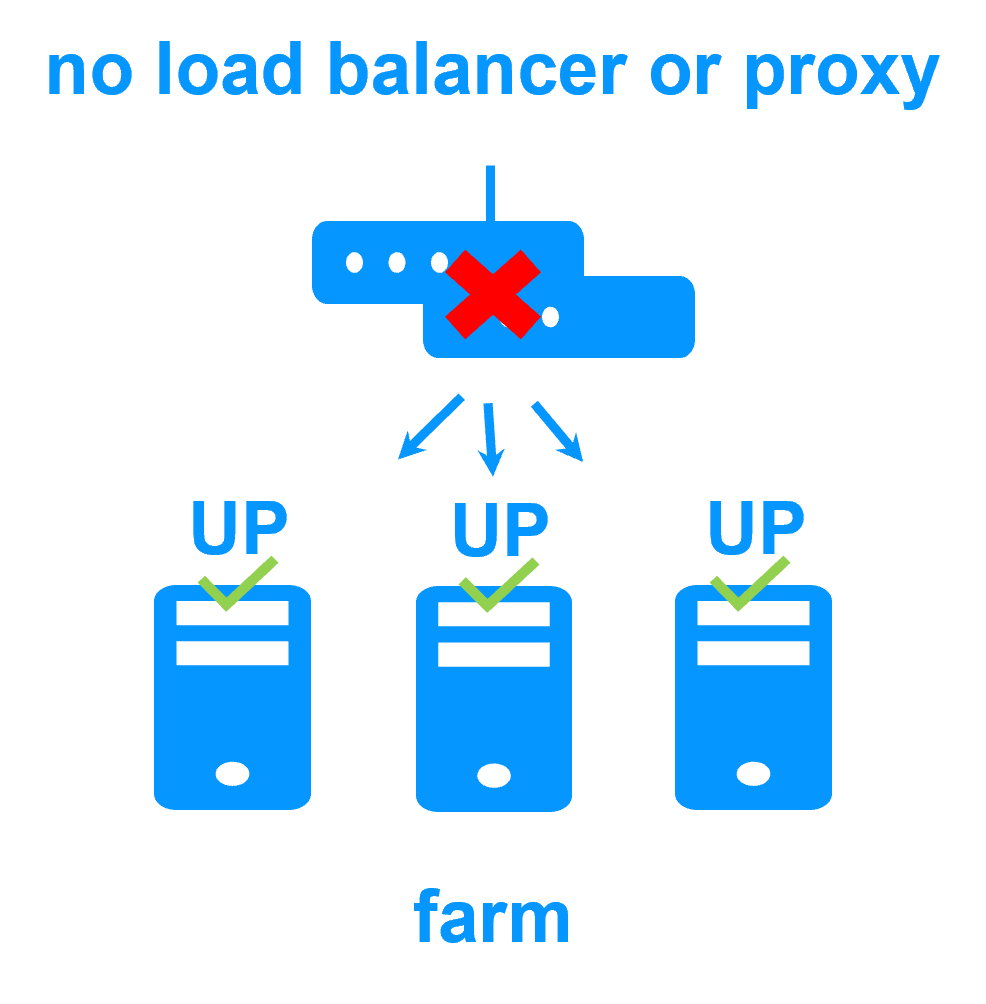

RTO avec l'exemple du cluster ferme de SafeKit

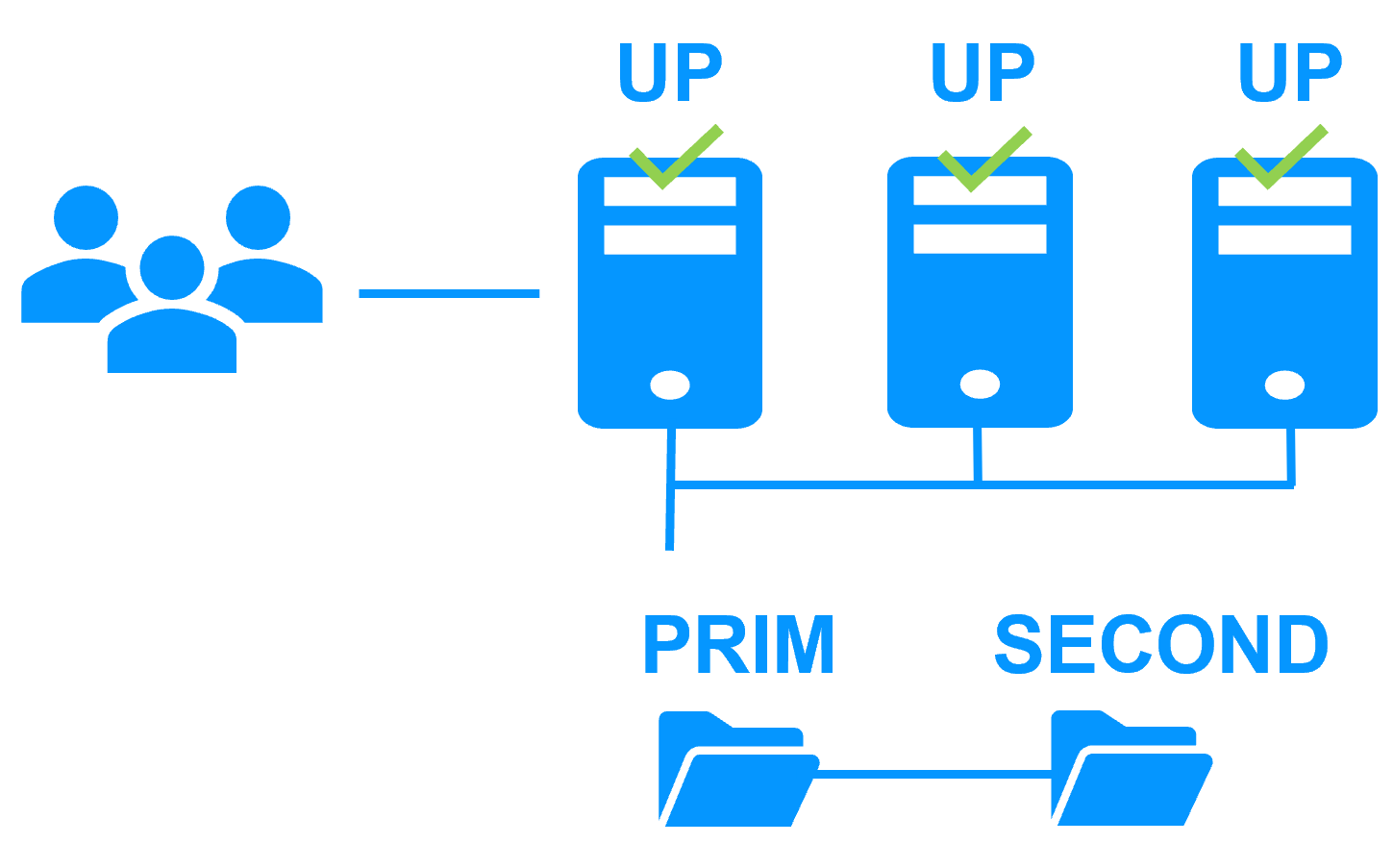

Le cluster ferme SafeKit est un cluster logiciel de haute disponibilité avec équilibrage de charge réseau et reprise applicative automatique.

Le RTO du cluster ferme de SafeKit est de l'ordre de quelques secondes.

Pour une panne matérielle, RTO = timeout sur la détection de panne via les voies de surveillance (par défaut quelques secondes). Après le timeout, les filtres de load balancing sont reconfigurés.

Pour une défaillance logicielle ou une relance administrateur, RTO = temps d'arrêter l'application + temps de la redémarrer.

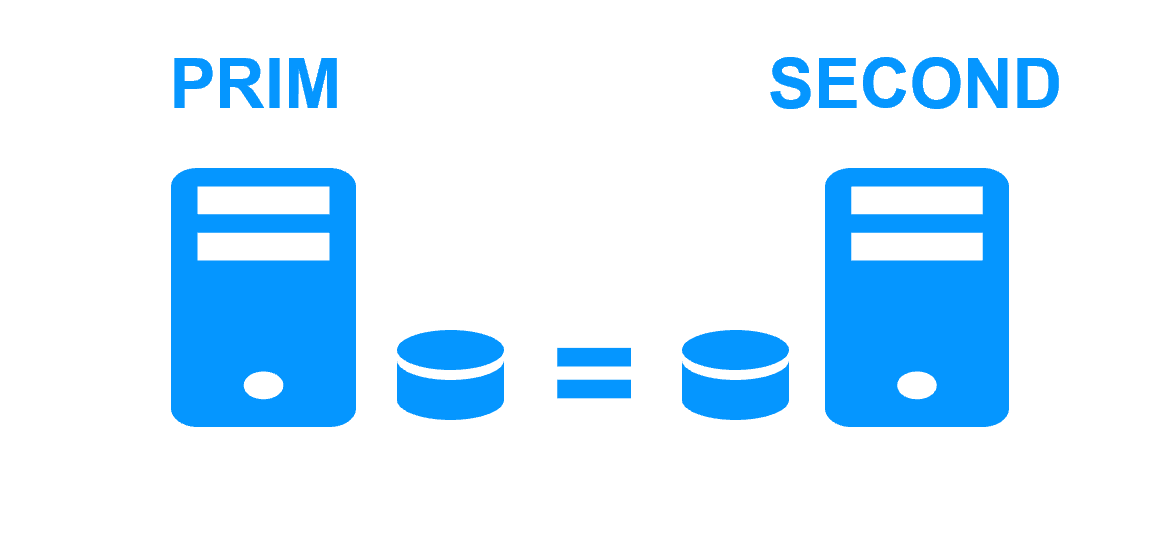

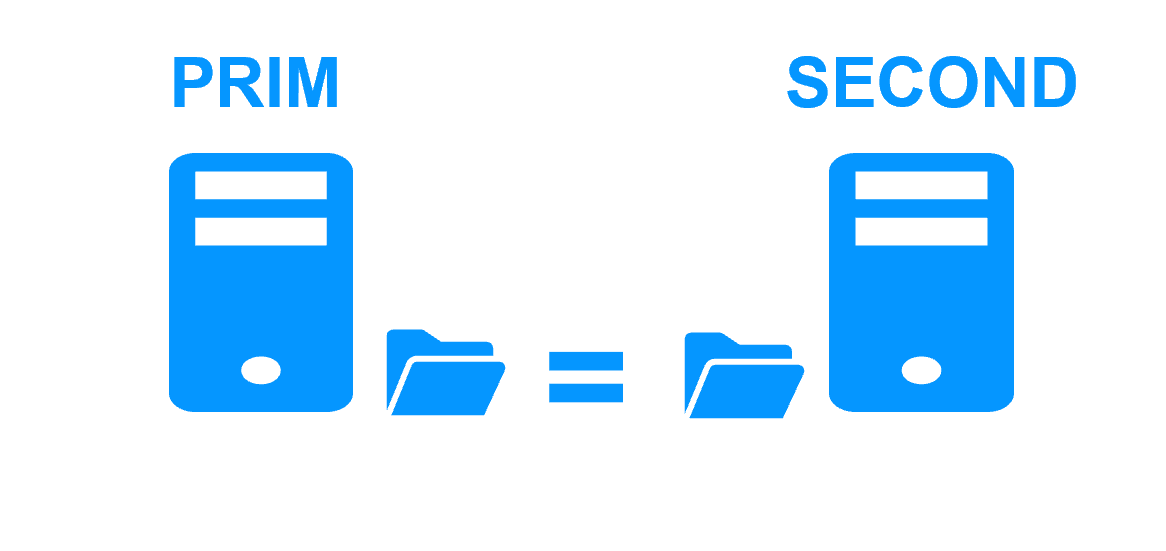

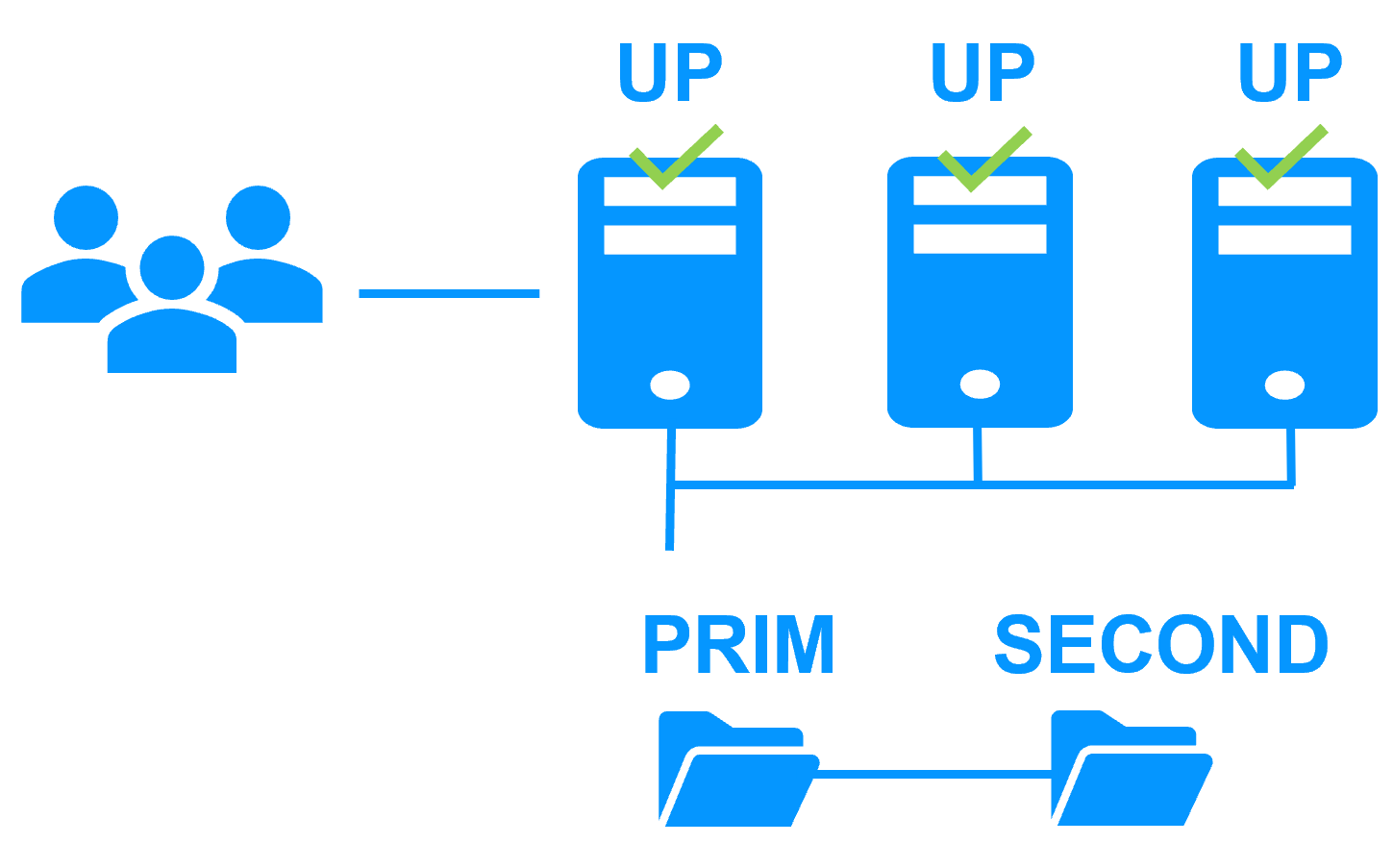

RPO avec l'exemple du cluster miroir de SafeKit

Le RPO du cluster miroir de SafeKit est 0 car la réplication est synchrone et temps réel.

Attention, avec la réplication asynchrone, le RPO n'est pas 0 et il y a perte de données en cas de panne lorsque l'application redémarre sur le serveur secondaire.

RPO avec l'exemple du cluster ferme de SafeKit

N/R. Il n'y a pas de réplication de données dans un cluster ferme.

Partenaires, le succès avec SafeKit

Cette solution indépendante de la plateforme est idéale pour un partenaire revendant une application critique et qui souhaite proposer une option de redondance et de haute disponibilité simple à déployer auprès de nombreux clients.

Avec de nombreuses références dans de nombreux pays gagnées par des partenaires, SafeKit s'est avéré être la solution la plus simple à mettre en œuvre pour la redondance et la haute disponibilité des logiciels de gestion des bâtiments, vidéosurveillance, contrôle d'accès, systèmes SCADA...

Quels sont les avantages d'un cluster miroir ?

- Faible complexité

- Déploiement Plug & Play sans compétences spécifiques

- Convient aux déploiements sur de nombreux sites (très simple à déployer)

- 2 nœuds virtuels ou physiques

- Aucune exigence de stockage partagé

- Aucune exigence de contrôleur de domaine

- Même solution sous Windows et Linux

- Supporte les éditions OS Windows Server et Client

- API et support bien documentés

- Réplication synchrone des données (aucune perte de données en cas de panne)

- Les répertoires répliqués peuvent être dans le disque système

- Multiples heartbeats et adresses IP virtuelles supportés

- Offre des checkers logiciels, matériels et réseaux configurables

- Pour le problème de split brain et de quorum, ne nécessite pas de disque spécial ou de troisième machine ou de lien spécifique entre les 2 serveurs

- Basculement automatique de l'application avec un temps de reprise de l'ordre d'une minute

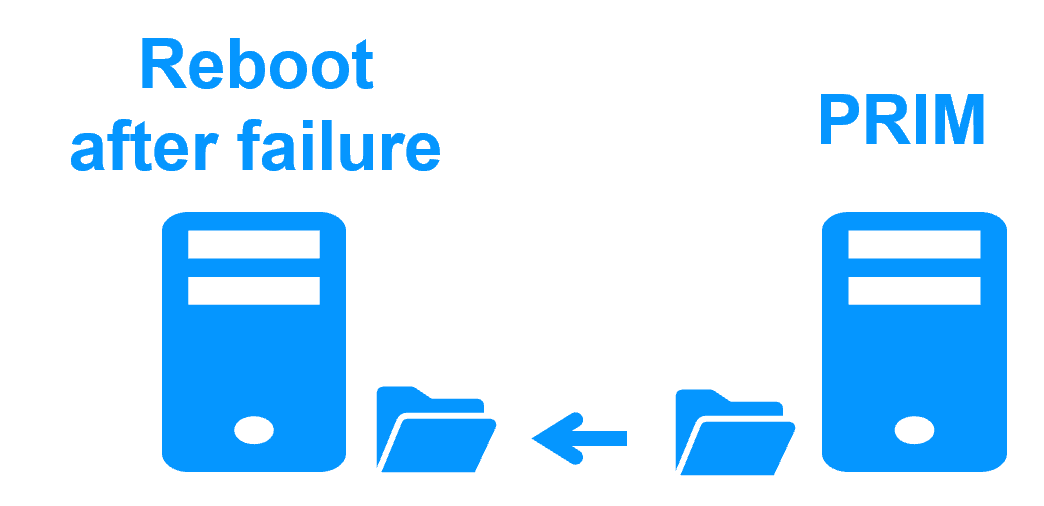

- Réintégration automatique d'un serveur après panne (aucune opération manuelle)

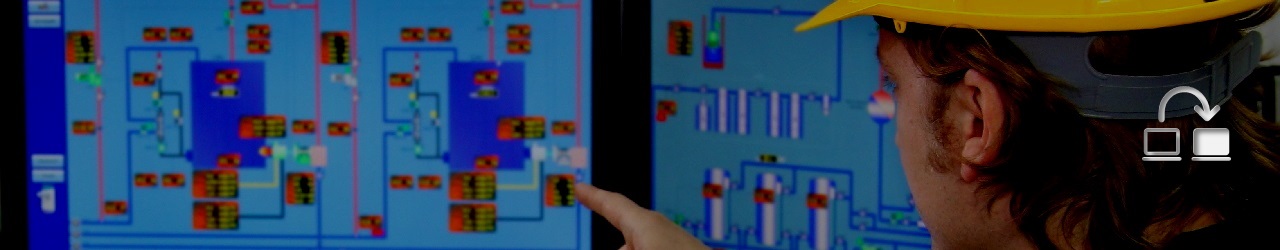

- Une console très simple pour déployer la solution et la maintenir ensuite pour le client final

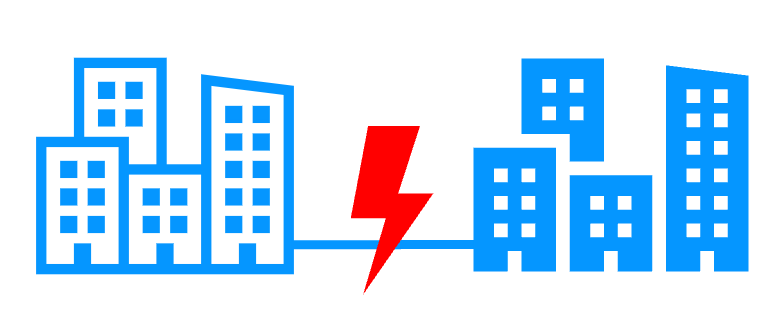

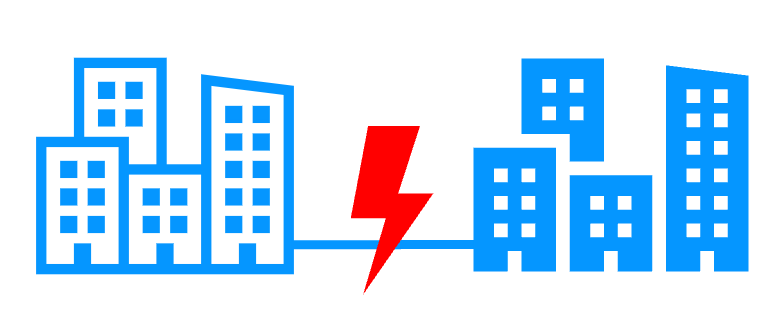

- Supporte les défaillances du matériel et de son environnement (20% des causes d'indisponibilité), y compris la panne complète d'une salle informatique avec 2 nœuds dans deux sites distants

- Supporte les défaillances logicielles (40% des causes d'indisponibilité) : bug logiciel, régression sur les mises à jour logicielles (les versions N et N+1 peuvent coexister)

- Supporte les erreurs humaines (40% des causes d'indisponibilité) : la simplicité d'utilisation évite l'erreur d'administration de l'application critique

Quels sont les avantages d'un cluster ferme ?

- Faible complexité

- Déploiement Plug & Play sans compétences spécifiques

- Convient aux déploiements sur de nombreux sites (très simple à déployer)

- 2 nœuds ou plus

- Aucune exigence sur des load balancers réseaux

- Aucune exigence sur des serveurs proxy (au dessus du cluster ferme)

- Aucune exigence de contrôleur de domaine

- Aucune restriction dans VMware dûe à une adresse multicast ou unicast

- Même solution sur Windows et Linux

- Supporte les éditions OS Windows Server et Client

- API et support bien documentés

- Supporte de multiples voies de surveillance sur de multiples réseaux pour détecter la panne d'un serveur

- Supporte de multiples adresse IP virtuelles

- Offre des checkers logiciel, matériel et réseau configurables

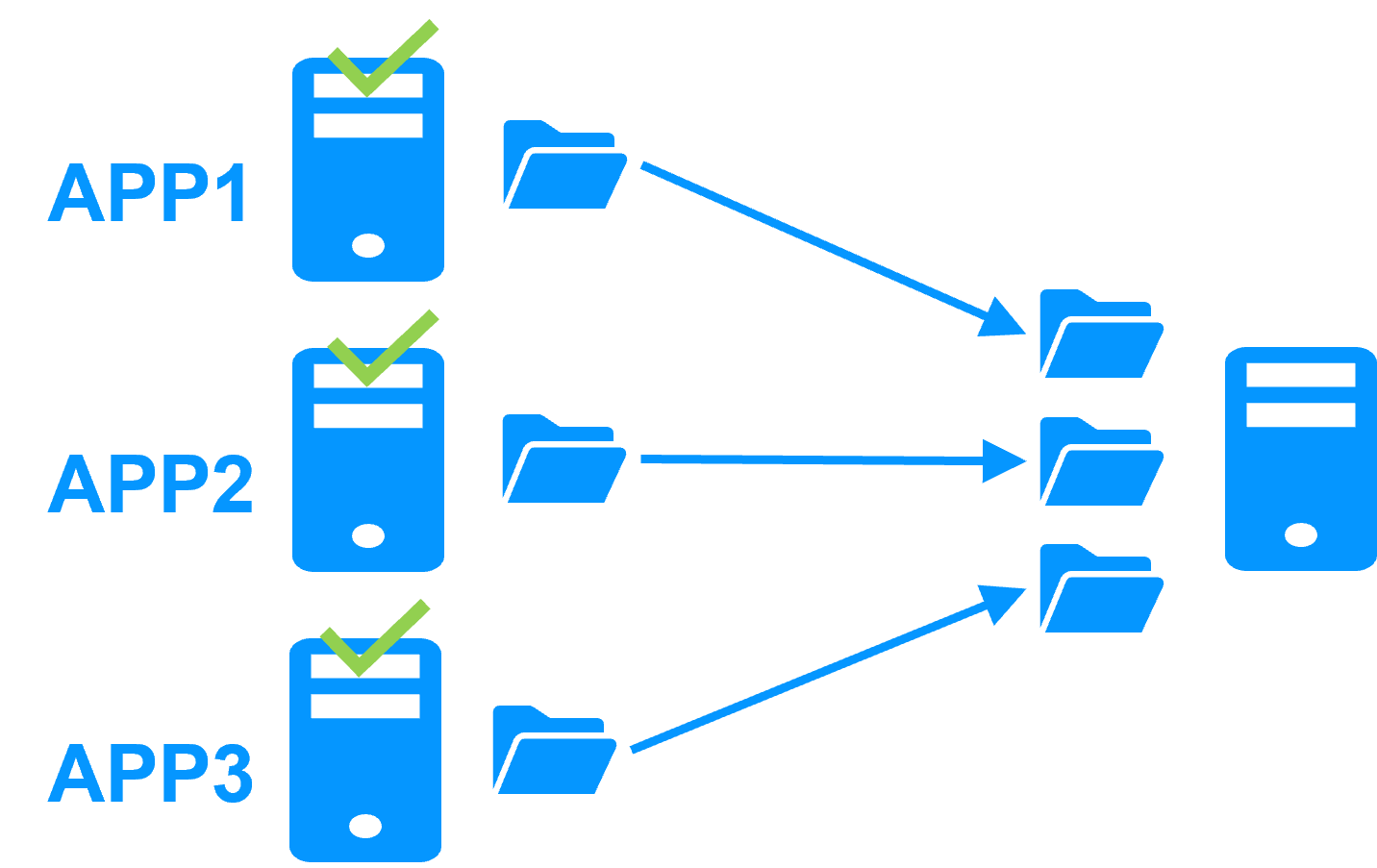

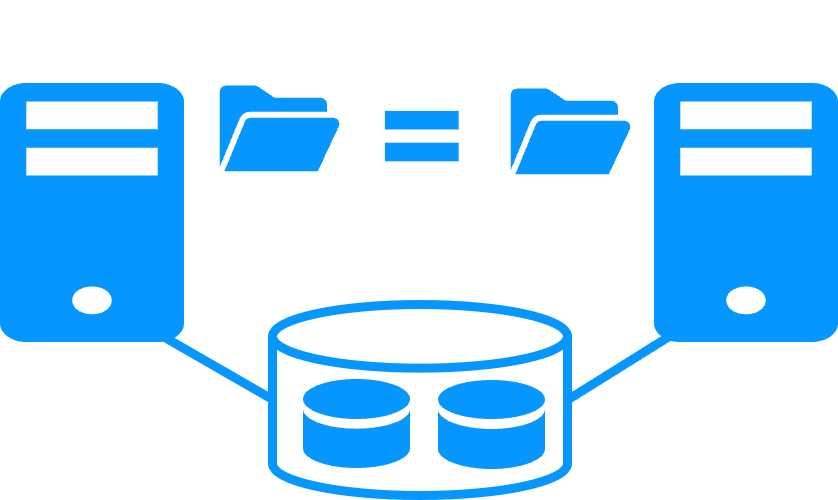

- Offre le cluster miroir avec réplication temps réel synchrone et reprise sur panne pour mettre en œuvre une architecture 3-tiers ferme+miroir

- Basculement automatique avec un temps de reprise de l'ordre de quelques secondes

- Réintégration automatique d'un serveur après panne (aucune opération manuelle)

- Une console très simple pour déployer la solution et la maintenir ensuite pour le client final

- Supporte les défaillances du matériel et de son environnement (20% des causes d'indisponibilité), y compris la panne complète d'une salle informatique avec 2 nœuds dans deux sites distants

- Supporte les défaillances logicielles (40% des causes d'indisponibilité) : bug logiciel, régression sur les mises à jour logicielles (les versions N et N+1 peuvent coexister)

- Supporte les erreurs humaines (40% des causes d'indisponibilité) : la simplicité d'utilisation évite les erreurs d'administration de l'application critique

Partage de charge réseau et reprise sur panne |

|

|

Windows farm |

Linux farm |

| Generic farm > | Generic farm > |

| Microsoft IIS > | - |

| NGINX > | |

| Apache > | |

| Amazon AWS farm > | |

| Microsoft Azure farm > | |

| Google GCP farm > | |

| Other cloud > | |

Architectures de clustering avancée

Plusieurs modules peuvent être déployés dans le même cluster. Ainsi, des architectures de clustering avancées peuvent être mises en œuvre :

- un cluster qui mixte ferme et miroir avec le déploiement d’un module ferme et d’un module miroir dans le même cluster,

- un cluster actif/actif avec réplication en déployant plusieurs modules miroirs sur 2 serveurs,

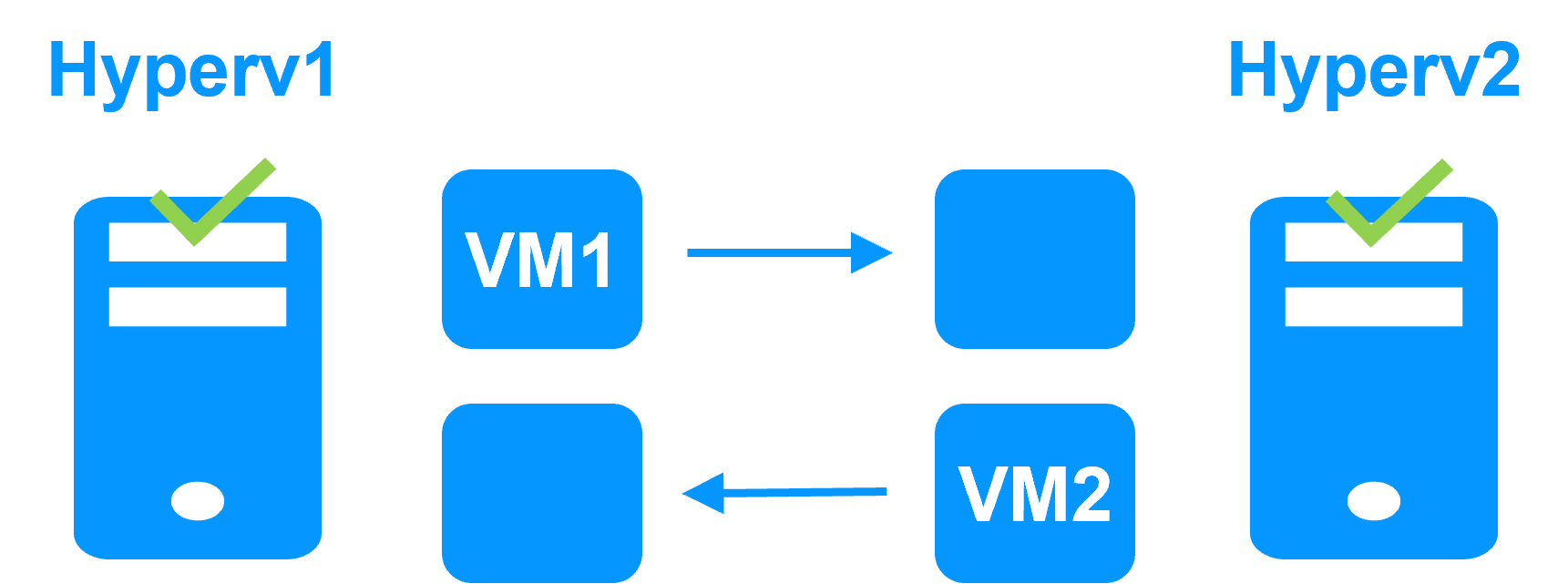

- un cluster Hyper-V ou un cluster KVM avec réplication temps réel et reprise de machines virtuelles complètes entre 2 hyperviseurs actifs,

- un cluster N-1 avec le déploiement de N modules miroirs sur N+1 serveurs.

Réplication de fichiers temps réel et reprise sur panne |

|||||||||||||||||||||||||||||||

|

Windows mirror |

Linux mirror |

||||||||||||||||||||||||||||||

| Generic mirror > | Generic mirror > | ||||||||||||||||||||||||||||||

| Microsoft SQL Server > | - | ||||||||||||||||||||||||||||||

| Oracle > | |||||||||||||||||||||||||||||||

| MariaDB > | |||||||||||||||||||||||||||||||

| MySQL > | |||||||||||||||||||||||||||||||

| PostgreSQL > | |||||||||||||||||||||||||||||||

| Firebird > | |||||||||||||||||||||||||||||||

| Windows Hyper-V > | Linux KVM > | ||||||||||||||||||||||||||||||

| - | Docker > Podman > Kubernetes K3S > |

||||||||||||||||||||||||||||||

| - | |||||||||||||||||||||||||||||||

| - | Elasticsearch > | ||||||||||||||||||||||||||||||

| Milestone XProtect > | - | ||||||||||||||||||||||||||||||

| Genetec SQL Server > | - | ||||||||||||||||||||||||||||||

|

Hanwha Vision > Hanwha Wisenet > |

- | ||||||||||||||||||||||||||||||

| Nedap AEOS > | - | ||||||||||||||||||||||||||||||

|

Siemens SIMATIC WinCC > Siemens SIMATIC PCS 7 > Siemens Desigo CC > Siemens Siveillance suite > Siemens Siveillance VMS > Siemens SiPass > Siemens SIPORT > |

- | ||||||||||||||||||||||||||||||

|

Bosch AMS > Bosch BIS > Bosch BVMS > |

- | ||||||||||||||||||||||||||||||

| Amazon AWS mirror > | |||||||||||||||||||||||||||||||

| Microsoft Azure mirror > | |||||||||||||||||||||||||||||||

| Google GCP mirror > | |||||||||||||||||||||||||||||||

| Other cloud > | |||||||||||||||||||||||||||||||

Cluster miroir d'Evidian SafeKit avec réplication de fichiers temps réel et reprise sur panne |

|

|

Économisez avec 3 produits en 1

|

|

|

Configuration très simple

|

|

|

Réplication synchrone

|

|

|

Retour d'un serveur tombé en panne totalement automatisé (failback)

|

|

|

Réplication de n'importe quel type de données

|

|

|

Réplication de fichiers vs réplication de disque

|

|

|

Réplication de fichiers vs disque partagé

|

|

|

Sites distants et adresse IP virtuelle

|

|

|

Split brain et quorum En savoir plus >

|

|

|

Cluster actif/actif

|

|

|

Solution de haute disponibilité uniforme

|

|

|

|

Cluster ferme d'Evidian SafeKit avec load balancing et reprise sur panne |

|

|

Pas de load balancer, ni de serveur proxy dédié, ni d'adresse Ethernet multicast spéciale En savoir plus >  |

|

|

Toutes les fonctionnalités de clustering En savoir plus >  |

|

|

Sites distants et adresse IP virtuelle En savoir plus >  |

|

|

Solution de haute disponibilité uniforme En savoir plus >  |

|

|

|

|

|

Cluster de type "shared nothing"" vs cluster à disque partagé |

|

|

|

|

|

|

|

|

Haute disponibilité vs tolérance aux fautes |

|

|

|

|

|

Réplication synchrone vs réplication asynchrone |

|

|

|

|

|

Réplication de fichiers au niveau octet vs réplication de disque au niveau du bloc |

|

|

|

|

|

Heartbeat, reprise sur panne et quorum pour éviter 2 serveurs maîtres |

|

|

|

|

|

|

|

- Demonstration

- Examples of redundancy and high availability solution

- Evidian SafeKit sold in many different countries with Milestone

- 2 solutions: virtual machine cluster or application cluster

- Distinctive advantages

- More information on the web site

Evidian SafeKit 8.2

Toutes les nouvelles fonctionnalités par rapport à la SafeKit 7.5 décrites dans le release notes

Packages

- Windows (with Microsoft Visual C++ Redistributable)

- Windows (without Microsoft Visual C++ Redistributable)

- Linux

- OS supportés et derniers fixes

Licence d'essai gratuit d'un mois

Documentation technique

Training

Information produit

Introduction

-

- Demonstration

- Examples of redundancy and high availability solution

- Evidian SafeKit sold in many different countries with Milestone

- 2 solutions: virtual machine or application cluster

- Distinctive advantages

- More information on the web site

- SafeKit training

-

- Cluster of virtual machines

- Mirror cluster

- Farm cluster

Installation, Console, CLI

- Install and setup / pptx

- Package installation

- Nodes setup

- Upgrade

- Web console / pptx

- Configuration of the cluster

- Configuration of a new module

- Advanced usage

- Securing the web console

- Command line / pptx

- Configure the SafeKit cluster

- Configure a SafeKit module

- Control and monitor

Advanced configuration

- Mirror module / pptx

- start_prim / stop_prim scripts

- userconfig.xml

- Heartbeat (<hearbeat>)

- Virtual IP address (<vip>)

- Real-time file replication (<rfs>)

- How real-time file replication works?

- Mirror's states in action

- Farm module / pptx

- start_both / stop_both scripts

- userconfig.xml

- Farm heartbeats (<farm>)

- Virtual IP address (<vip>)

- Farm's states in action

Troubleshooting

- Troubleshooting / pptx

- Analyze yourself the logs

- Take snapshots for support

- Boot / shutdown

- Web console / Command lines

- Mirror / Farm / Checkers

- Running an application without SafeKit

Support

- Evidian support / pptx

- Get permanent license key

- Register on support.evidian.com

- Call desk