Comment fonctionne une adresse IP virtuelle (Windows/Linux) ?

Evidian SafeKit

Comment fonctionne une adresse IP virtuelle primaire/secondaire dans le même sous-réseau ?

Cas du cluster miroir avec 2 serveurs Windows ou Linux

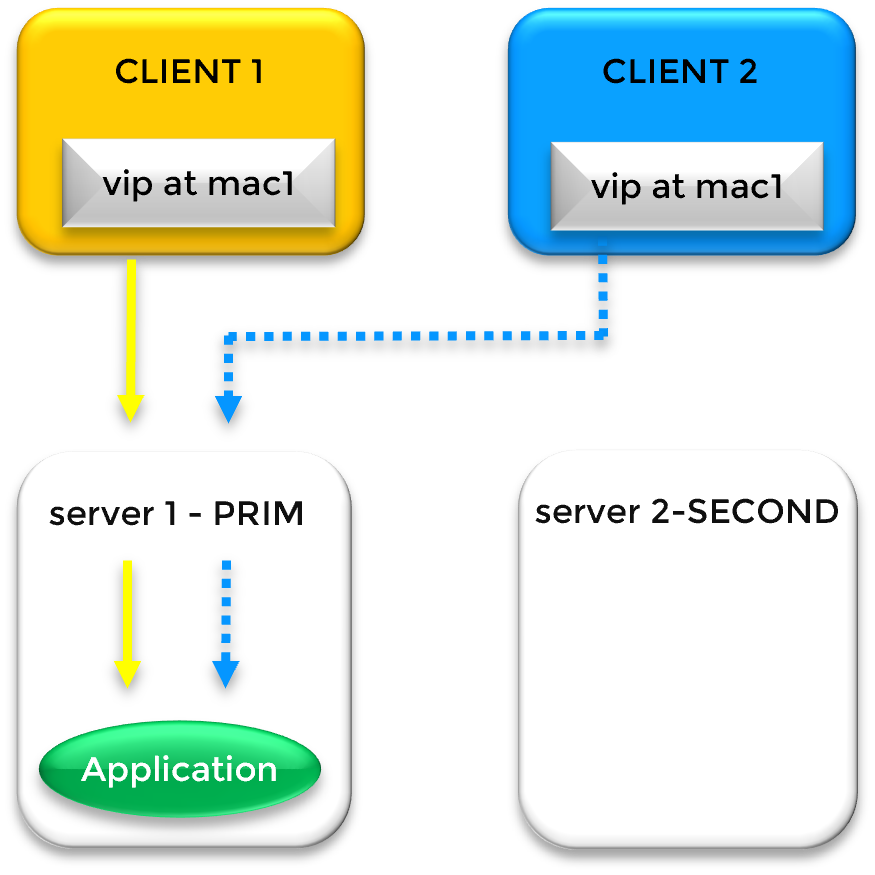

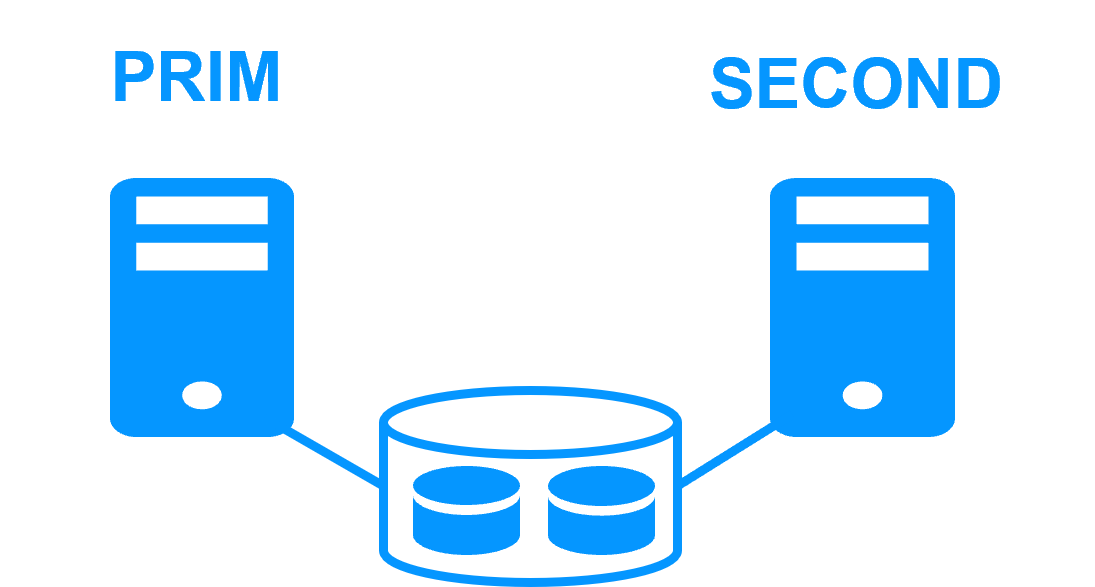

Lorsque les deux serveurs d'un cluster miroir sont dans le même sous-réseau, l'adresse IP virtuelle est définie sur la carte Ethernet du serveur primaire (via l'aliasing IP). L'adresse IP virtuelle est une troisième adresse IP venant s'ajouter aux deux adresses IP physiques du serveur 1 et du serveur 2. Notez qu'avec SafeKit, plusieurs adresses IP virtuelles peuvent être définies dans le cluster sur la même carte Ethernet ou sur différentes cartes Ethernet.

Si le serveur 1 est le serveur primaire, l'adresse IP virtuelle est associée à l'adresse MAC Ethernet du serveur 1 dans les caches ARP des clients : mac1 dans la figure. En cas de panne du serveur 1 et de basculement sur le serveur 2, SafeKit envoie automatiquement un ARP gratuitous pour rediriger les caches ARP des clients avec l'adresse Ethernet mac2 du serveur 2. Ainsi, les clients sont reconnectés au serveur 2 exécutant l'application qui a été redémarrée sur ce serveur par les mécanismes de clustering SafeKit.

Lorsque deux serveurs se trouvent sur des sites distants, les algorithmes d'adresse IP virtuelle précédents fonctionnent s'ils sont connectés dans le même sous-réseau via un LAN/VLAN étendu. C'est le cas d'utilisation le plus simple pour des sites distants.

Comment fonctionne une adresse IP virtuelle primaire/secondaire dans différents sous-réseaux ?

Cas du cluster miroir avec 2 serveurs Windows ou Linux

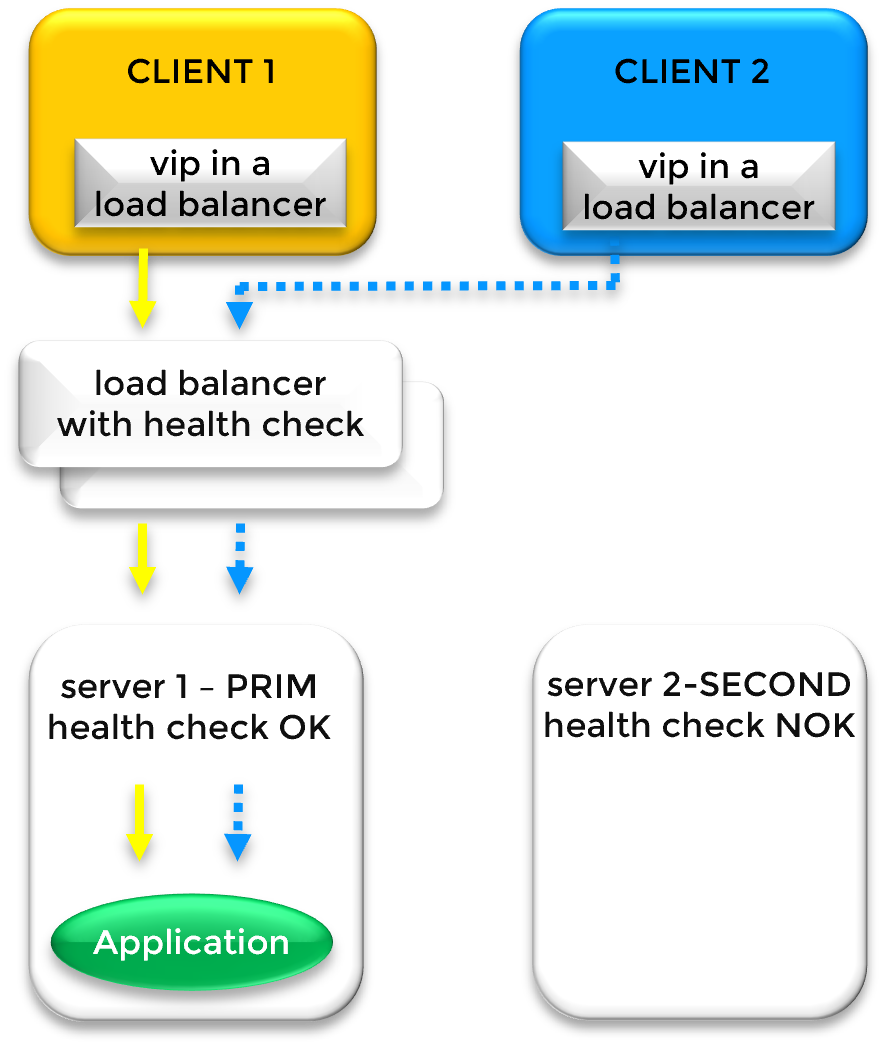

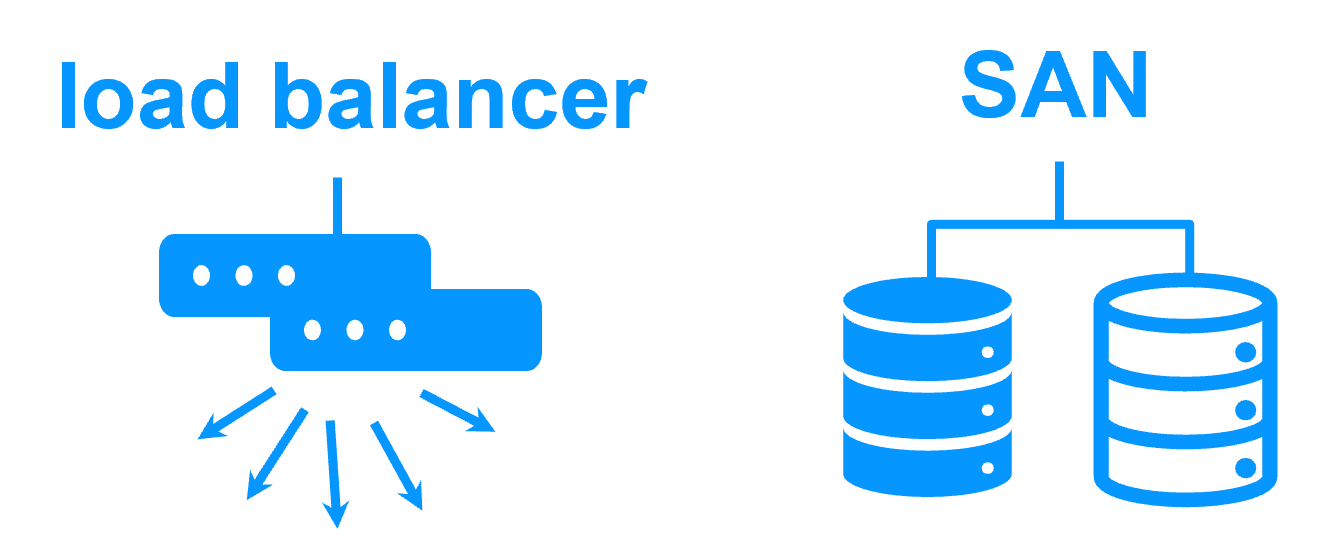

Si les serveurs se trouvent dans différents sous-réseaux, l'adresse IP virtuelle peut être définie au niveau d'un équilibreur de charge. L'équilibreur de charge est configuré avec les deux adresses IP physiques des deux serveurs dans leurs sous-réseaux respectifs. Et l'équilibreur de charge achemine le trafic en fonction d'un vérificateur d’état (health check) vers les serveurs.

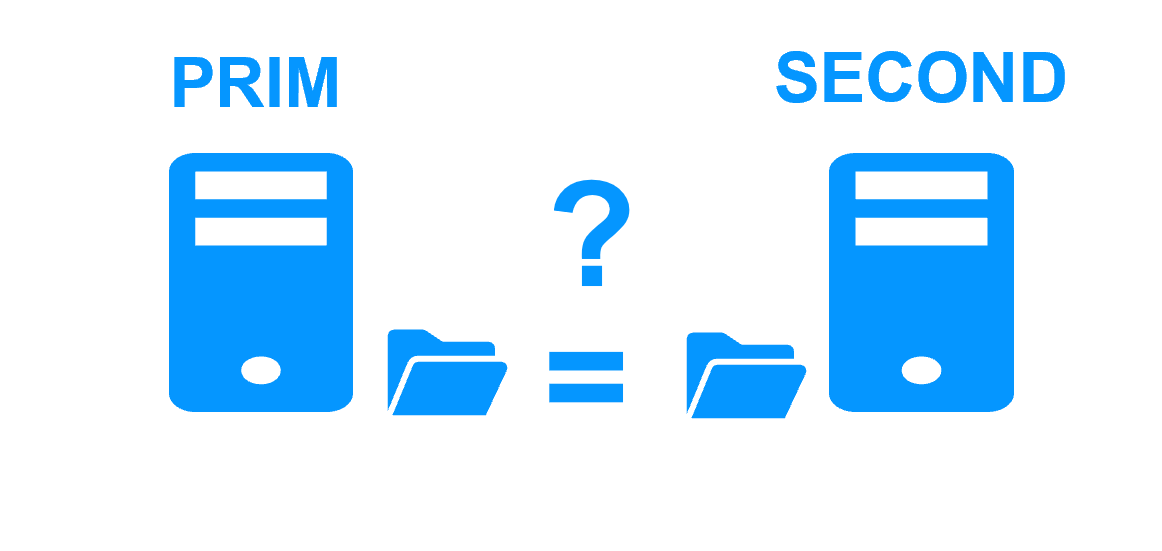

Le vérificateur d’état est basée sur une URL gérée par les serveurs SafeKit et répondant OK ou NOT FOUND selon l'état d'un serveur. Si le serveur est SECOND, le vérificateur d’état SafeKit renvoie NOT FOUND. Ainsi, aucun trafic n'est envoyé par l'équilibreur de charge au serveur secondaire. Et si le serveur est PRIM, le vérificateur d’état SafeKit renvoie OK. Ainsi, tout le trafic est envoyé par l'équilibreur de charge au serveur primaire. En cas de basculement, SafeKit modifie ses réponses au vérificateur d’état. Ainsi, le trafic de l'équilibreur de charge est redirigé.

Cette technique est celle utilisée dans les solutions SafeKit de type miroir dans le Cloud : Amazon AWS, Microsoft Azure et Google GCP.

Veuillez noter que SafeKit ne fournit pas de load balancer ; il propose uniquement des vérifications d’état. Le load balancer doit être fourni par l’infrastructure réseau entre les deux sous-réseaux.

Si nécessaire, il pourra être discuté avec l’équipe réseau de la possibilité de configurer un LAN étendu entre les deux sous-réseaux plutôt que de mettre en place un load balancer. De plus, lorsqu’un load balancer est utilisé, il est essentiel de s’assurer que l’application prend en charge les connexions des clients via l’adresse IP virtuelle du load balancer et qu’elle gère correctement les connexions arrivant via l’adresse IP physique traduite par le load balancer.

Ce problème ne se pose pas avec un LAN étendu, qui offre également une bande passante suffisante et une latence appropriée pour une réplication synchrone en temps réel sans perte de données.

Comment fonctionne une adresse IP virtuelle en load balancing dans le même sous-réseau ?

Cas du cluster ferme avec 2 serveurs Windows ou Linux

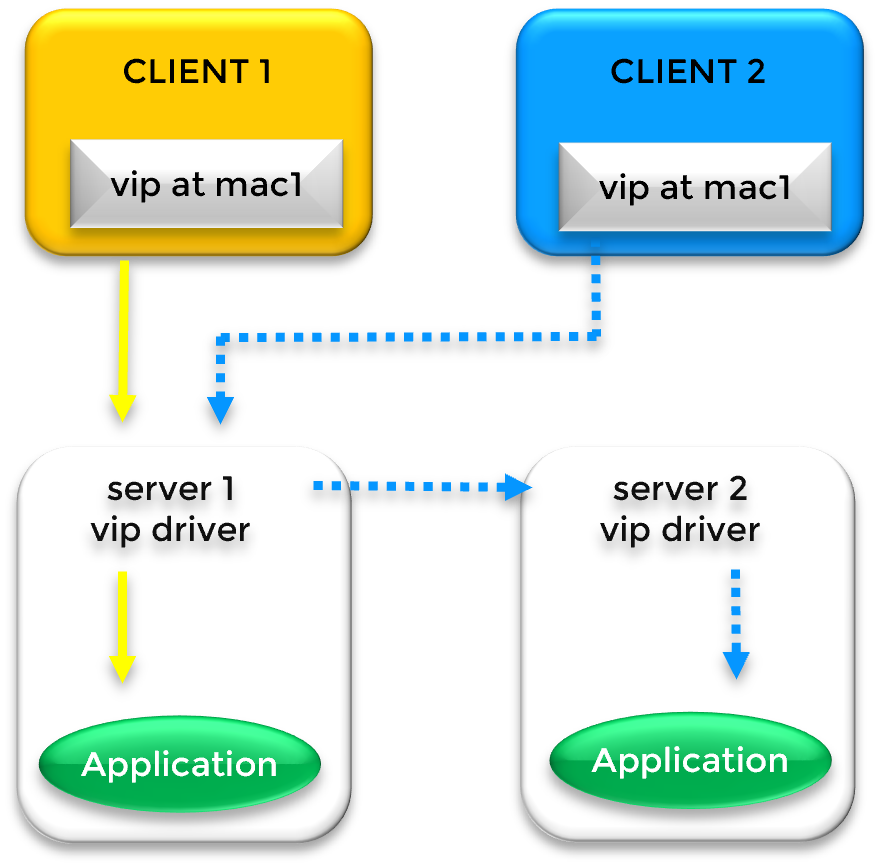

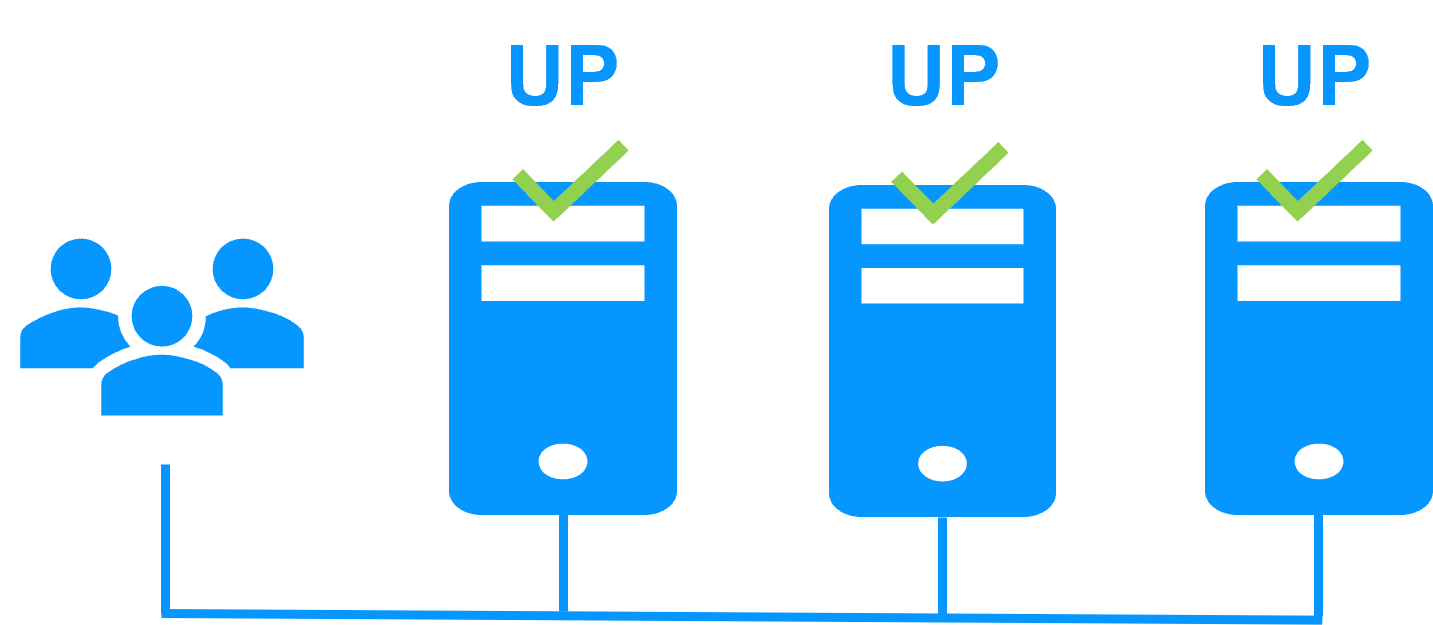

Dans un cluster ferme avec équilibrage de charge, une adresse IP virtuelle est requise pour équilibrer la charge des requêtes clientes et pour rediriger les clients en cas de basculement sur panne. Dans cet exemple, nous considérons seulement deux serveurs mais la solution fonctionne avec plus de deux serveurs.

Lorsque les deux serveurs du cluster sont dans le même sous-réseau, l'adresse IP virtuelle est définie sur la carte Ethernet des deux serveurs (alias IP).

Dans le cache ARP des clients, l'adresse IP virtuelle est associée à l'adresse MAC Ethernet d'un serveur: mac1 du serveur 1 sur la figure. Un filtre à l'intérieur du noyau du serveur 1 reçoit le trafic et le répartit selon l'identité des paquets client (adresse IP client, port TCP client).

En cas de panne du serveur 1, SafeKit envoie un ARP gratuitous pour rediriger les caches ARP des clients avec l'adresse Ethernet mac2 du serveur 2. Ainsi, les clients sont reconnectés au serveur 2.

Lorsque deux serveurs se trouvent sur des sites distants, les algorithmes d'adresse IP virtuelle précédents fonctionnent s'ils sont connectés dans le même sous-réseau via un LAN/VLAN étendu. C'est le cas d'utilisation le plus simple pour des sites distants.

Comment fonctionne une adresse IP virtuelle en load balancing dans différents sous-réseaux

Cas du cluster ferme avec 2 serveurs Windows ou Linux

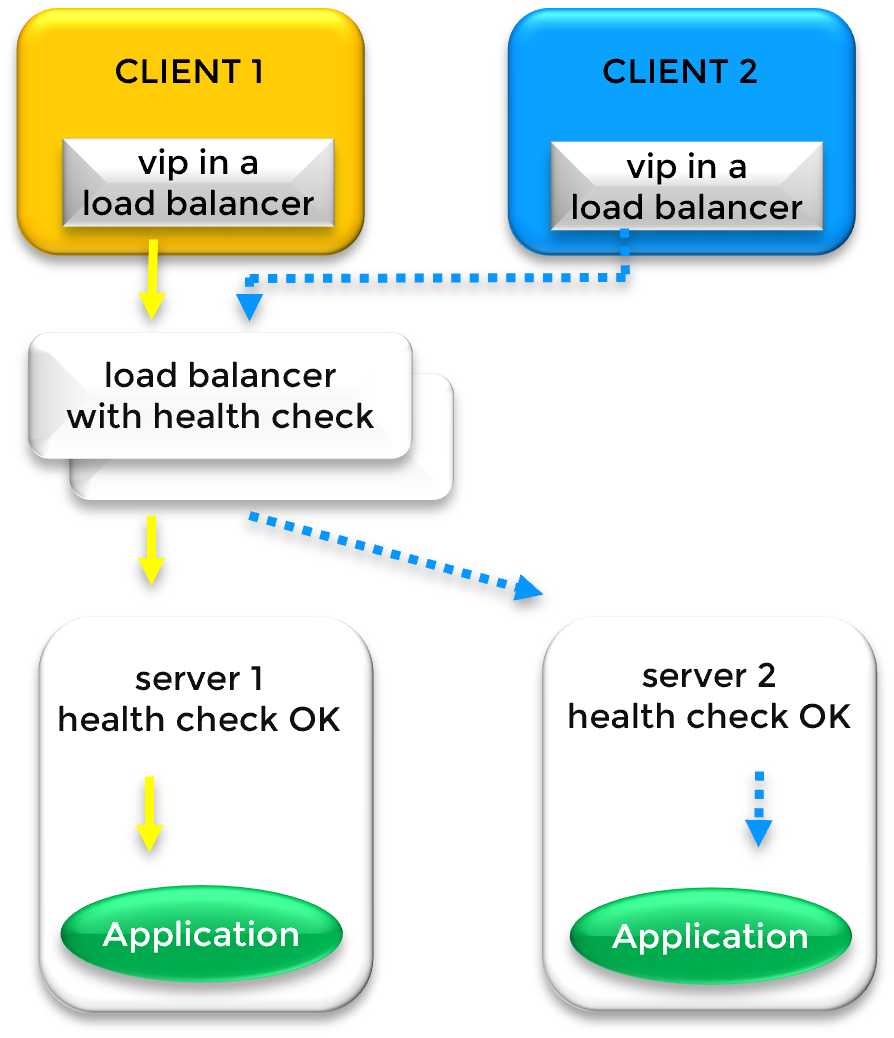

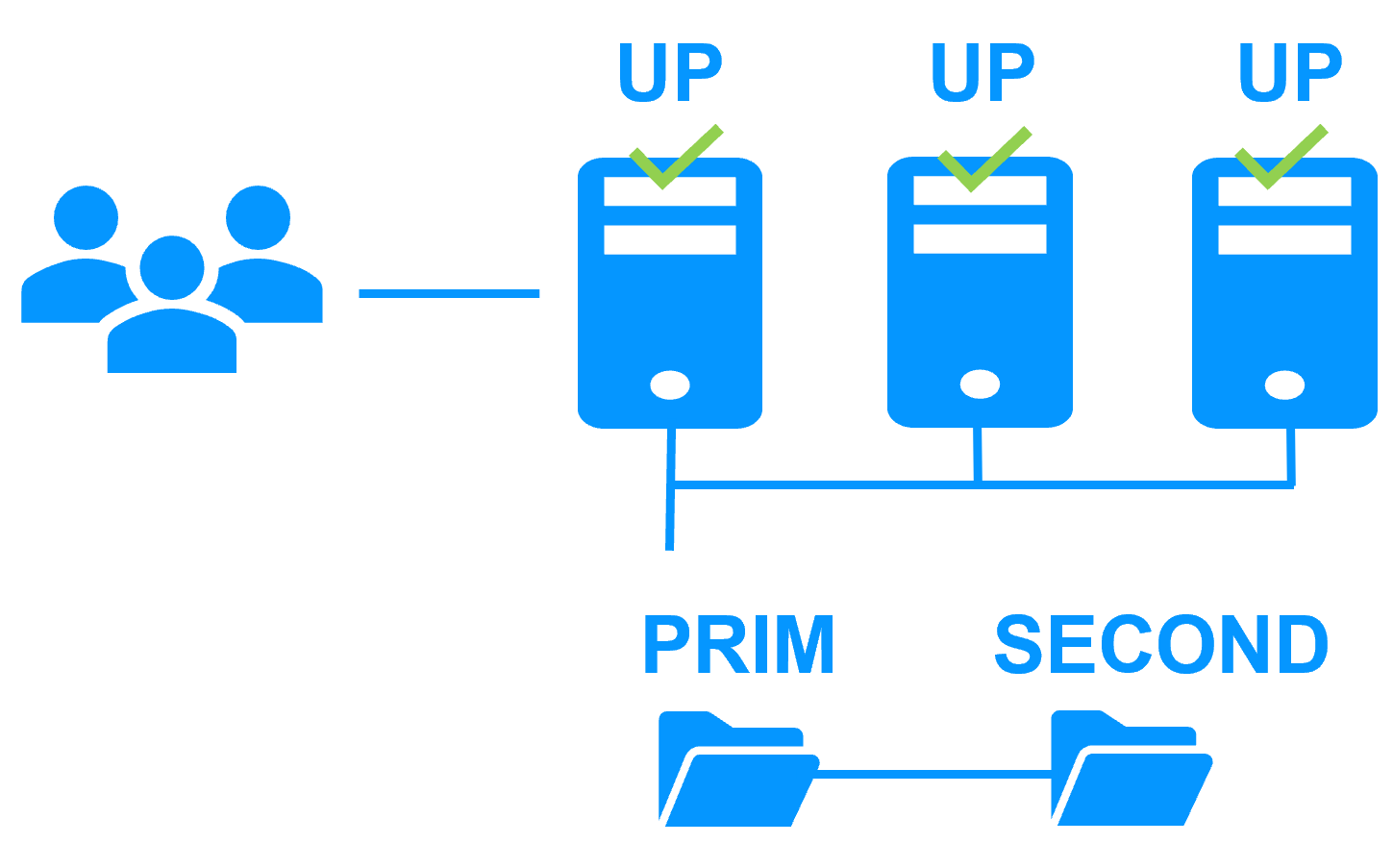

Si les serveurs se trouvent dans différents sous-réseaux, l'adresse IP virtuelle peut être définie au niveau d'un équilibreur de charge. L'équilibreur de charge est configuré avec les deux adresses IP physiques des deux serveurs dans leurs sous-réseaux respectifs. Et l'équilibreur de charge achemine le trafic en fonction des règles d'équilibrage de la charge (adresse IP du client, port TCP du client) et en fonction d'un vérificateur d'état des serveurs.

Le vérificateur d'état est basée sur une URL gérée par les serveurs SafeKit et répondant OK ou NOT FOUND selon l'état d'un serveur. Si le serveur est UP, le vérificateur d'état SafeKit renvoie OK, sinon NOT FOUND. En cas de basculement, SafeKit ne répond plus OK au vérificateur d'état sur le serveur défaillant. Ainsi, le trafic de l'équilibreur de charge est redirigé.

Cette technique est celle utilisée dans les solutions SafeKit de type ferme dans le Cloud : Amazon AWS, Microsoft Azure et Google GCP.

Notez qu'il existe une autre solution en redirigeant au niveau DNS. Mais cette solution ne fonctionne pas dans la plupart des cas. En effet, la condition préalable est que les clients effectuent une résolution DNS après un basculement pour être redirigés vers le nouveau serveur. La plupart du temps, ils ne le font pas et continuent leur exécution avec l'adresse IP résolue à leur démarrage.

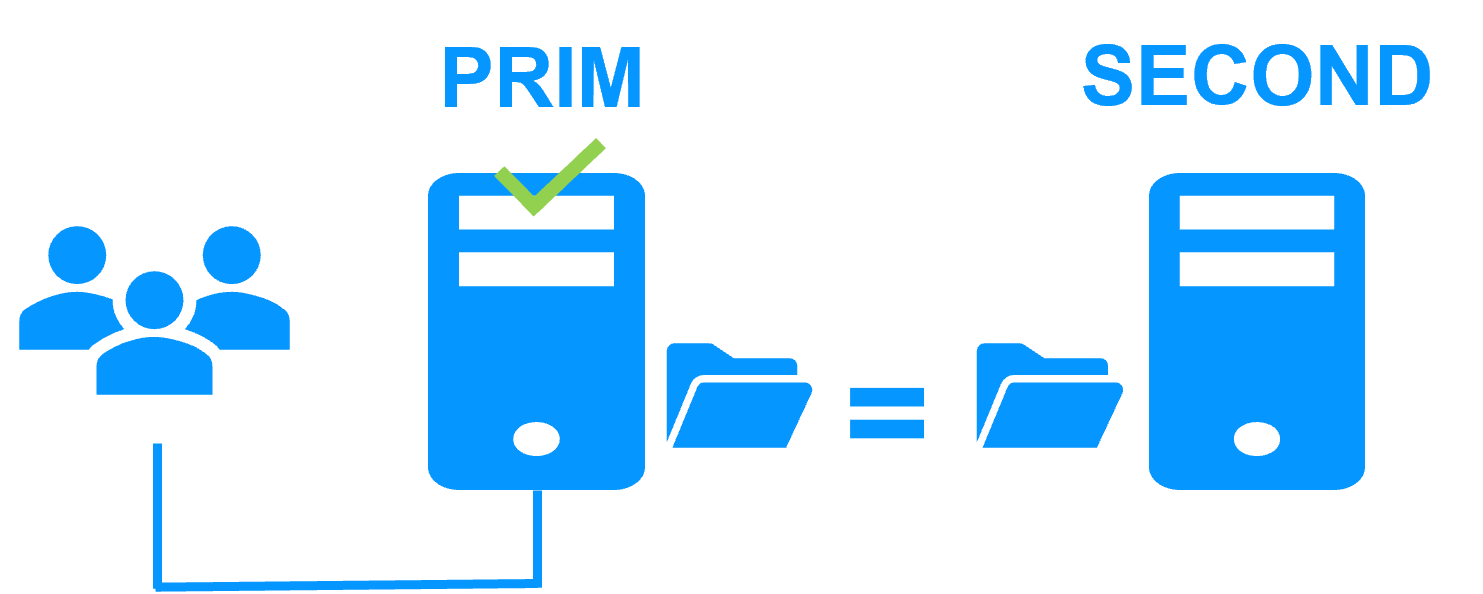

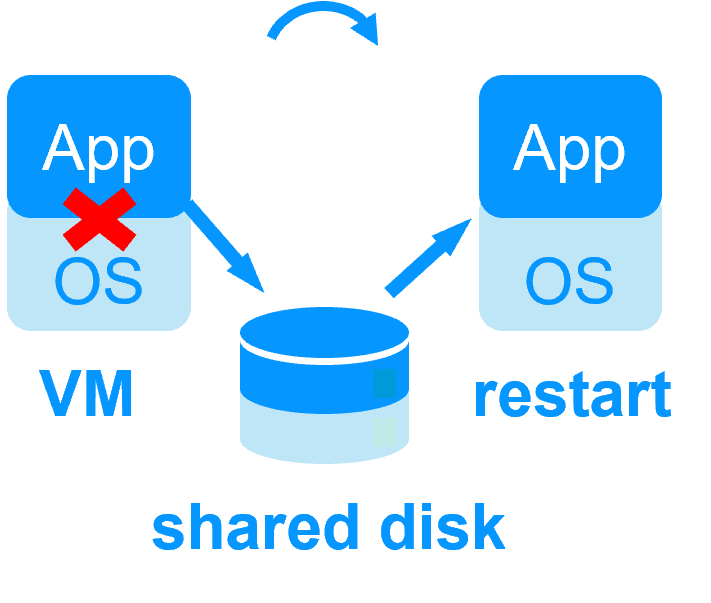

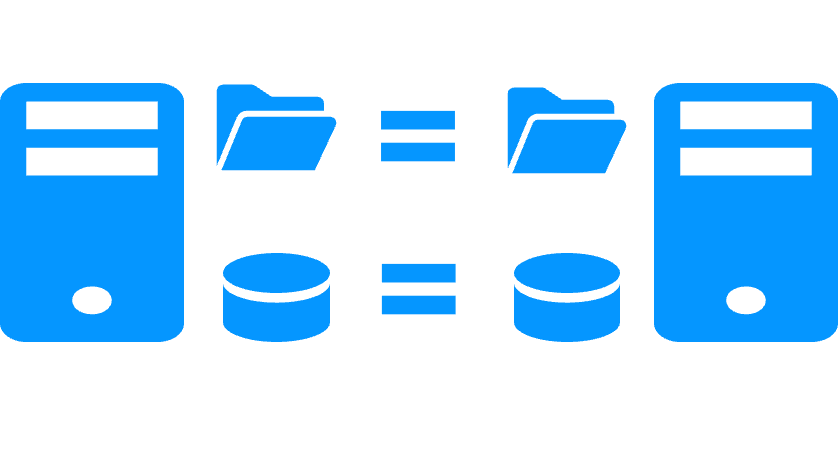

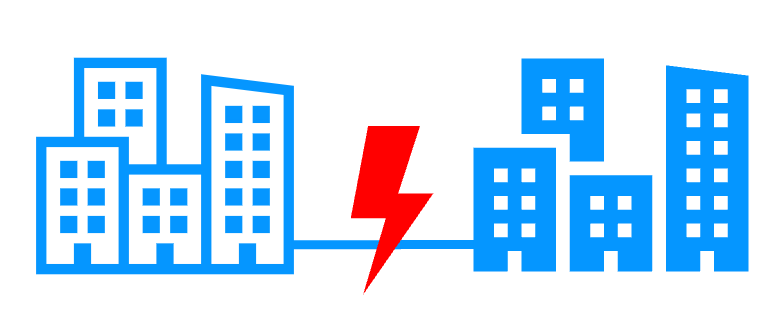

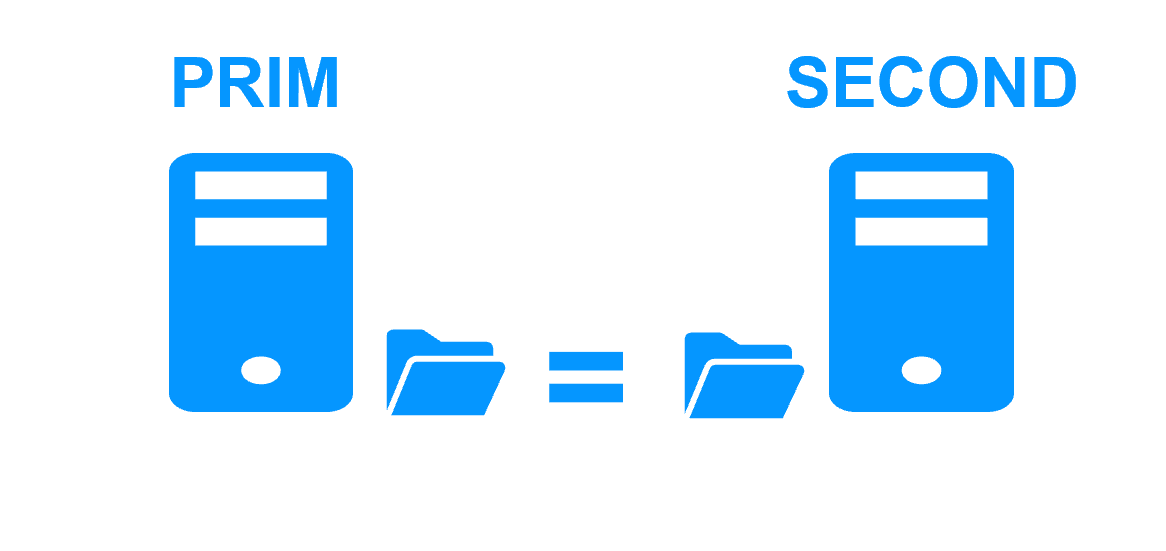

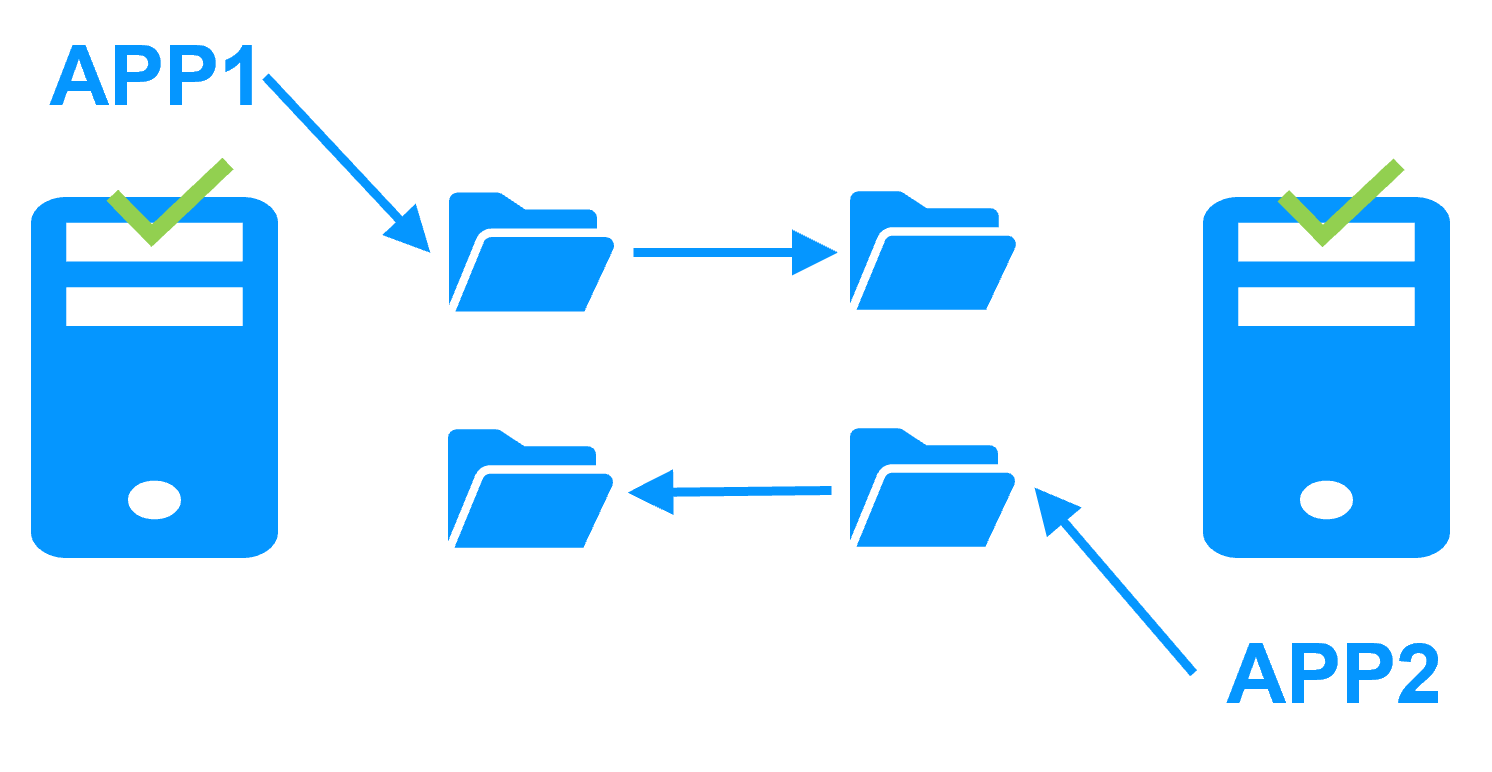

Etape 1. Réplication en temps réel

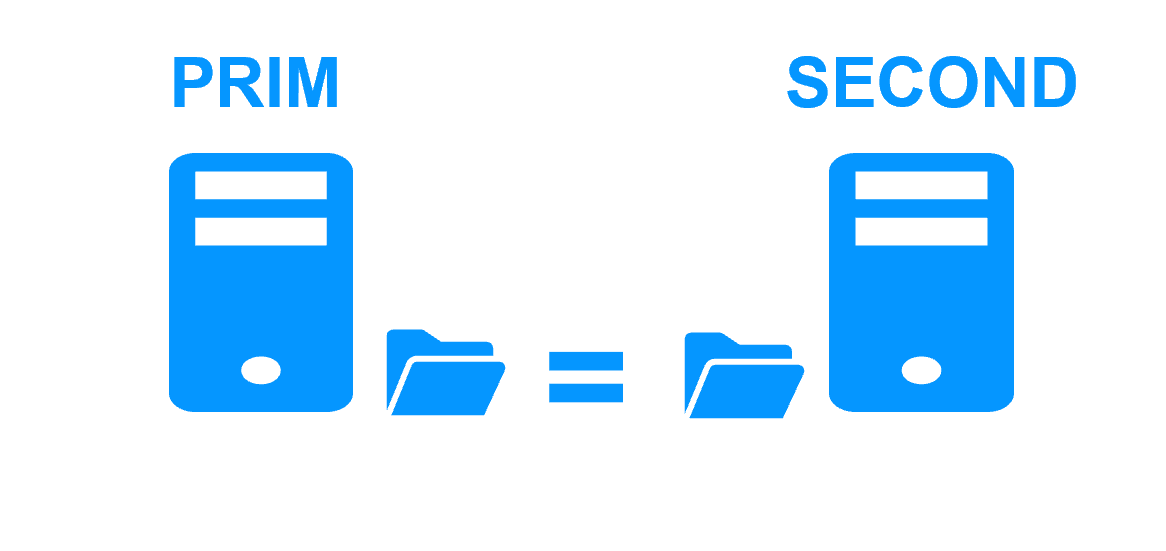

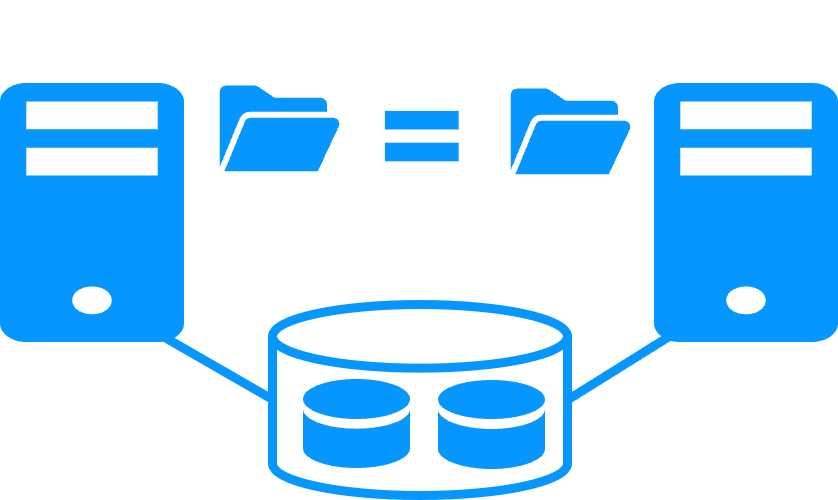

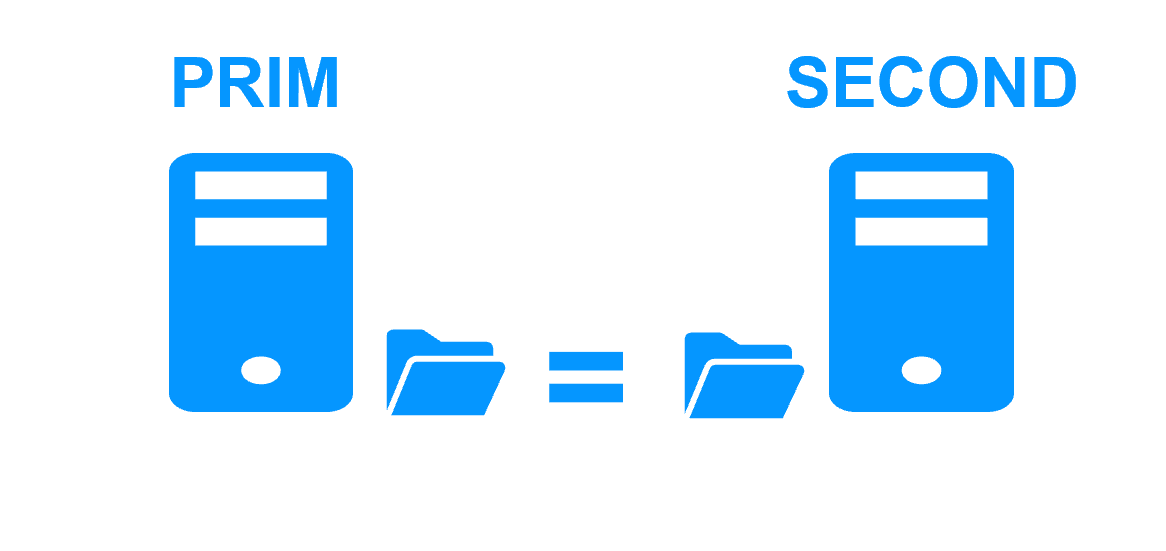

Le serveur 1 (PRIM) exécute l'application. Les utilisateurs sont connectés à une adresse IP virtuelle. Seules les modifications faites par l'application à l'intérieur des fichiers sont répliquées en continue à travers le réseau.

La réplication est synchrone sans perte de données en cas de panne contrairement à une réplication asynchrone.

Il vous suffit de configurer les noms des répertoires à répliquer dans SafeKit. Il n'y a pas de pré-requis sur l'organisation du disque. Les répertoires peuvent se trouver sur le disque système.

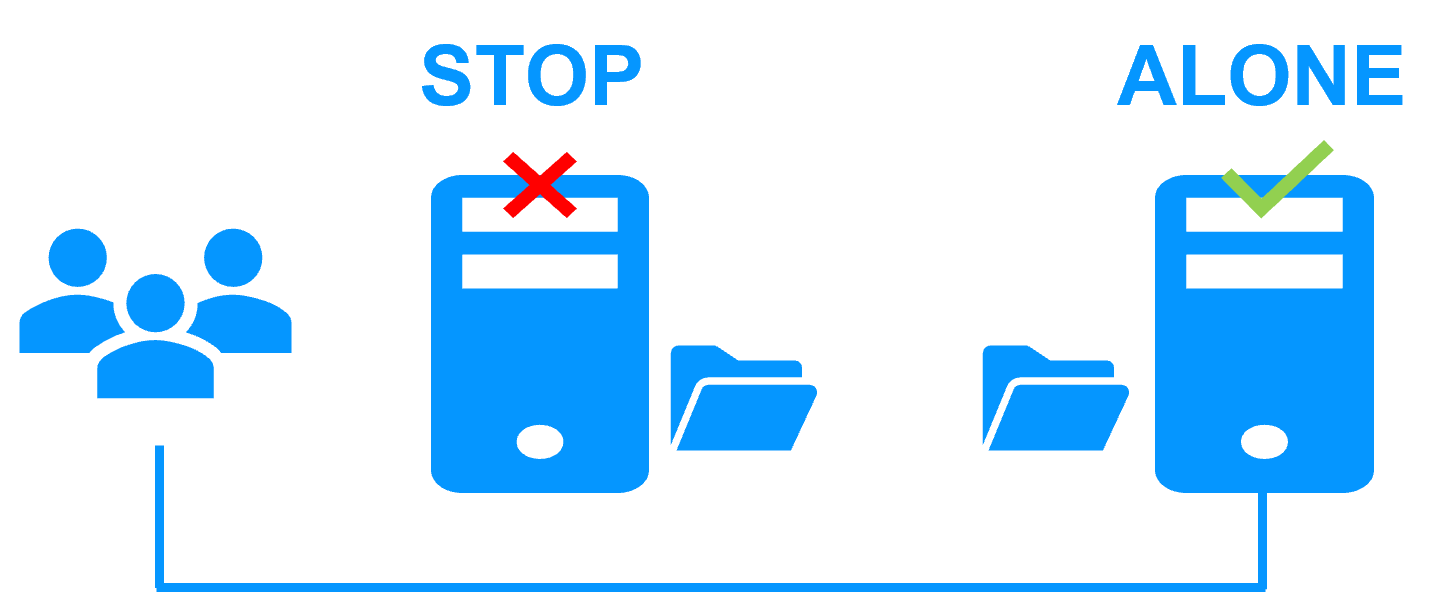

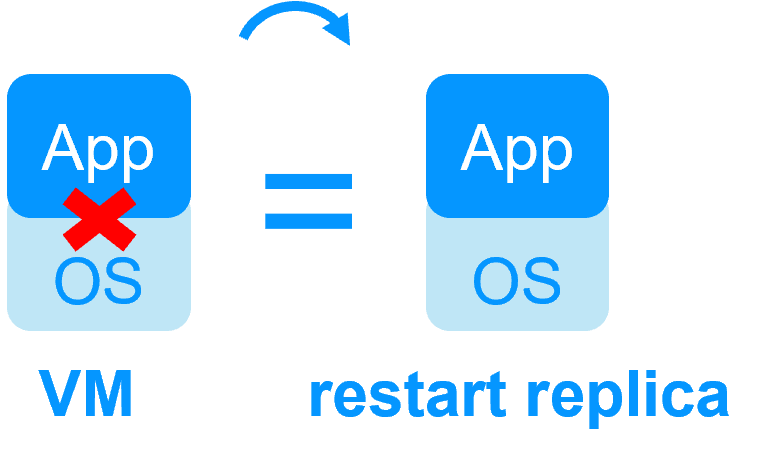

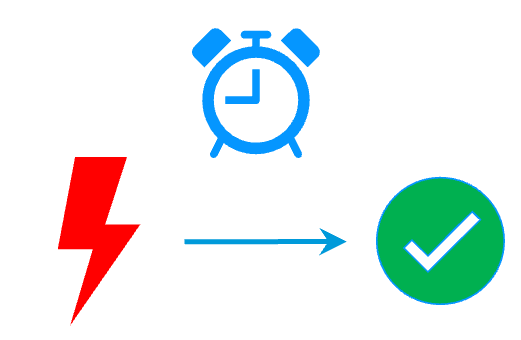

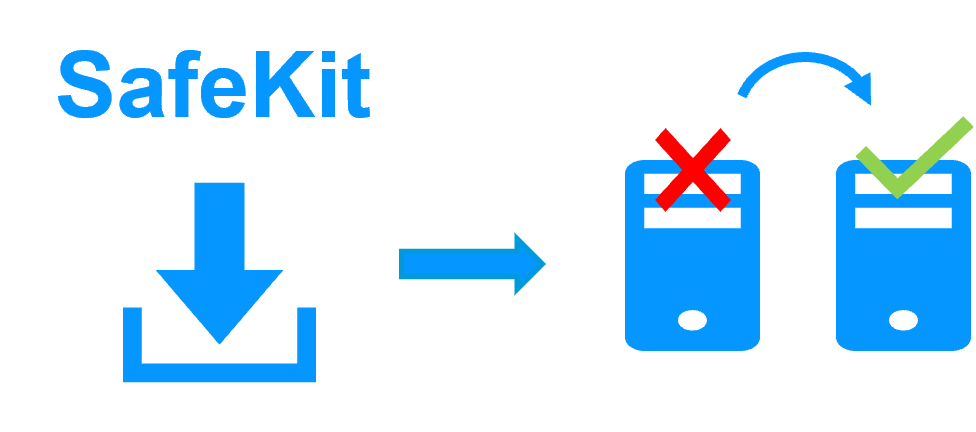

Etape 2. Basculement automatique

Lorsque le serveur 1 est défaillant, SafeKit bascule l'adresse IP virtuelle sur le serveur 2 et redémarre automatiquement l'application. L'application retrouve les fichiers répliqués à jour sur le serveur 2.

L'application poursuit son exécution sur le serveur 2 en modifiant localement ses fichiers qui ne sont plus répliqués vers le serveur 1.

Le temps de basculement est égal au temps de détection de la panne (30 secondes par défaut) et au temps de relance de l'application.

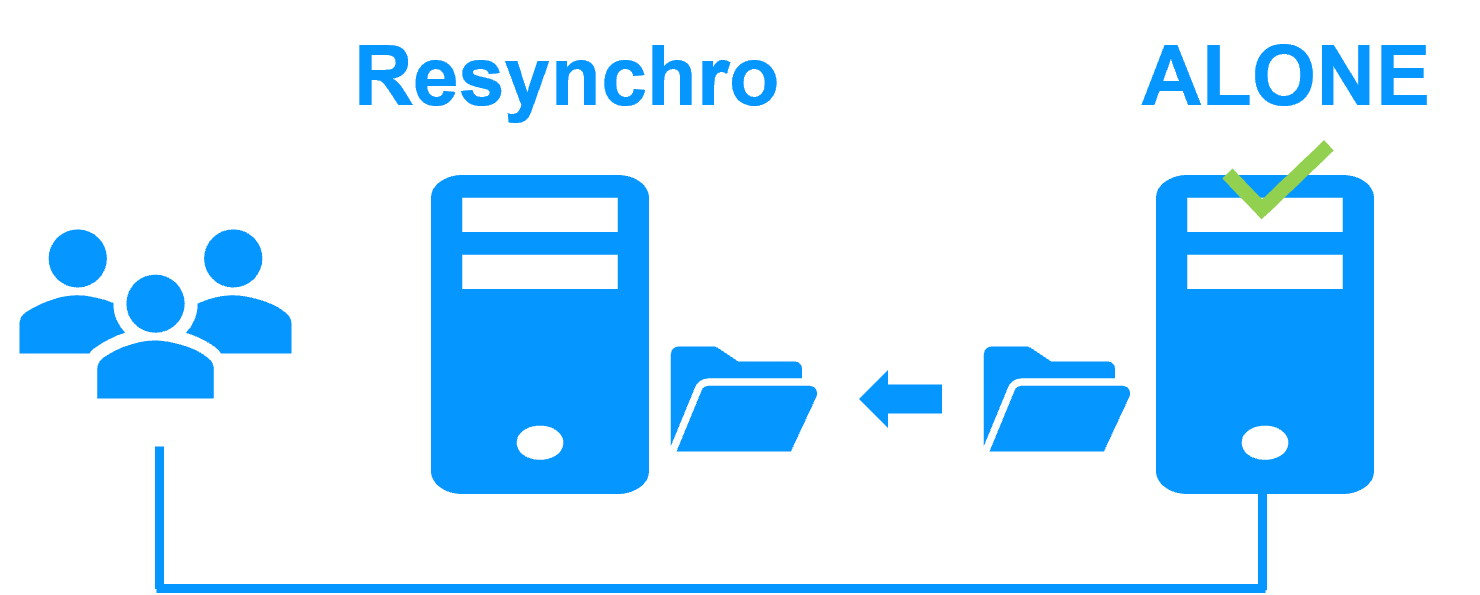

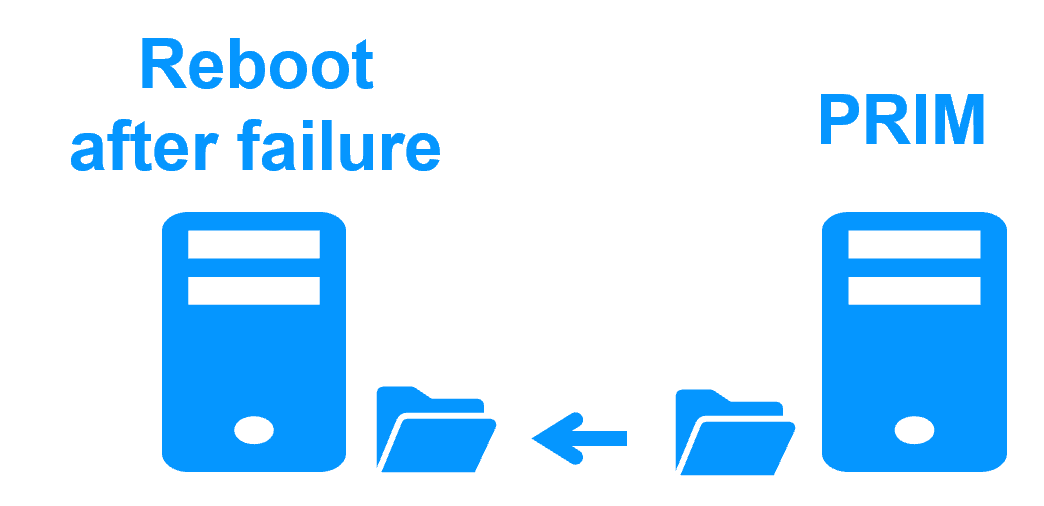

Etape 3. Réintégration après panne

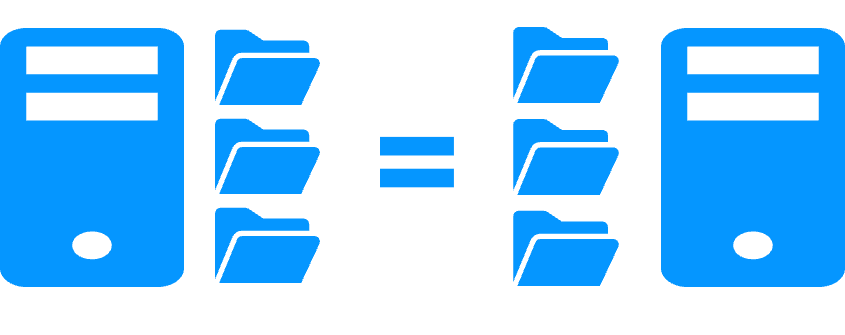

A la reprise après panne du serveur 1 (réintégration du serveur 1), SafeKit resynchronise automatiquement les fichiers de ce serveur à partir de l'autre serveur.

Seuls les fichiers modifiés sur le serveur 2 pendant l'inactivité du serveur 1 sont resynchronisés.

La réintégration du serveur 1 se fait sans arrêter l'exécution de l'application sur le serveur 2.

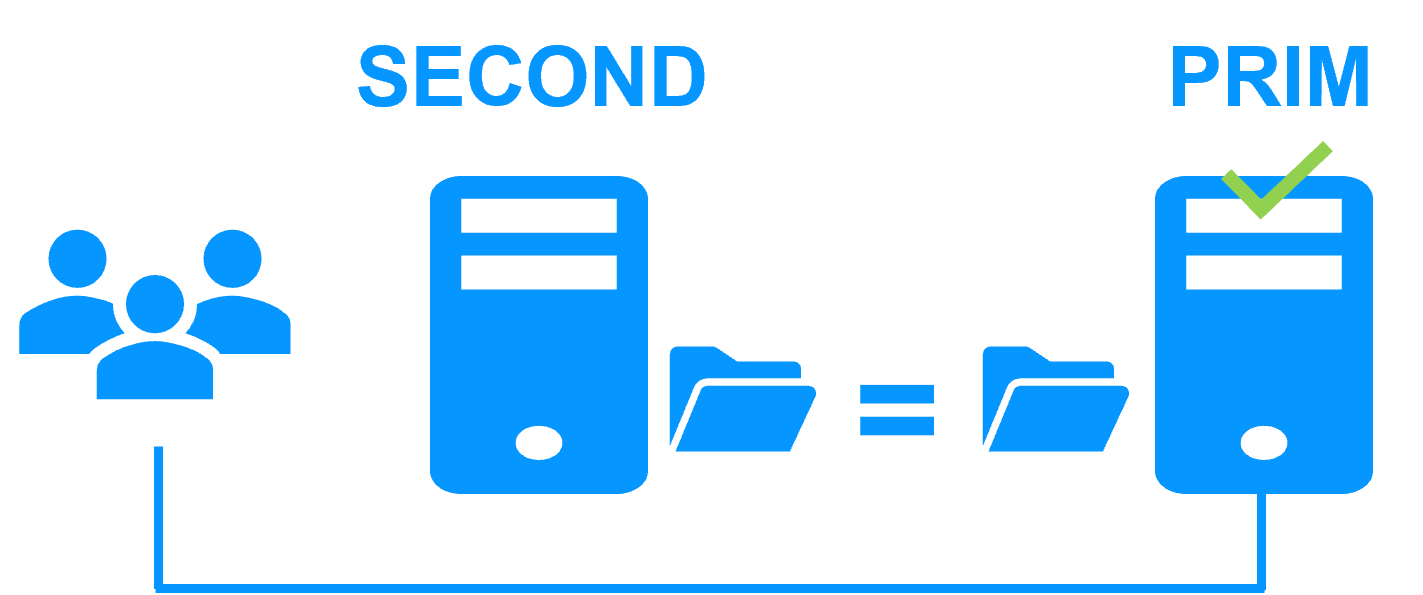

Etape 4. Retour à la normale

Après la réintégration, les fichiers sont à nouveau en mode miroir comme à l'étape 1. Le système est en haute disponibilité avec l'application qui s'exécute sur le serveur 2 et avec réplication temps réel des modifications vers le serveur 1.

Si l'administrateur souhaite que son application s'exécute en priorité sur le serveur 1, il peut exécuter une commande de basculement, soit manuellement à un moment opportun, soit automatiquement par configuration.

Plus d'information sur une coupure de courant et un isolement du réseau dans un cluster.

Pourquoi une réplication de quelques Tera-octets ?

Temps de resynchronisation après panne (étape 3)

- Réseau 1 Gb/s ≈ 3 heures pour 1 téraoctet.

- Réseau 10 Gb/s ≈ 1 heure pour 1 téraoctet ou moins en fonction des performances d'écriture disque.

Alternative

- Pour un grand volume de données, utilisez un stockage partagé externe.

- Plus cher, plus complexe.

Pourquoi une réplication < 1 000 000 fichiers ?

- Performance du temps de resynchronisation après panne (étape 3).

- Temps pour vérifier chaque fichier entre les deux nœuds.

Alternative

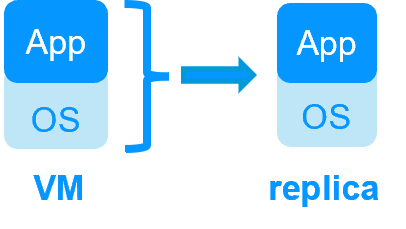

- Placez les nombreux fichiers à répliquer sur un disque dur virtuel / une machine virtuelle.

- Seuls les fichiers représentant le disque dur virtuel / la machine virtuelle seront répliqués et resynchronisés dans ce cas.

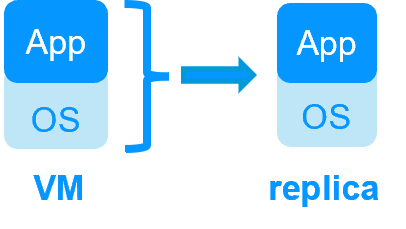

Pourquoi un basculement ≤ 32 VMs répliquées ?

- Chaque VM s'exécute dans un module miroir indépendant.

- Maximum de 32 modules miroir exécutés sur le même cluster.

Alternative

- Utilisez un stockage partagé externe et une autre solution de clustering de VMs.

- Plus cher, plus complexe.

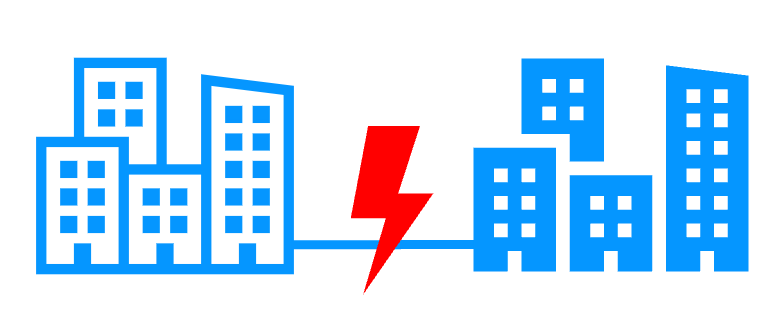

Pourquoi un réseau LAN/VLAN entre sites distants ?

- Basculement automatique de l'adresse IP virtuelle avec 2 nœuds dans le même sous-réseau.

- Bonne bande passante pour la resynchronisation (étape 3) et bonne latence pour la réplication synchrone (typiquement un aller-retour de moins de 2 ms).

Alternative

- Utilisez un équilibreur de charge pour l'adresse IP virtuelle si les 2 nœuds sont dans 2 sous-réseaux (supporté par SafeKit, notamment dans le cloud).

- Utilisez des solutions de backup avec réplication asynchrone pour un réseau à latence élevée.

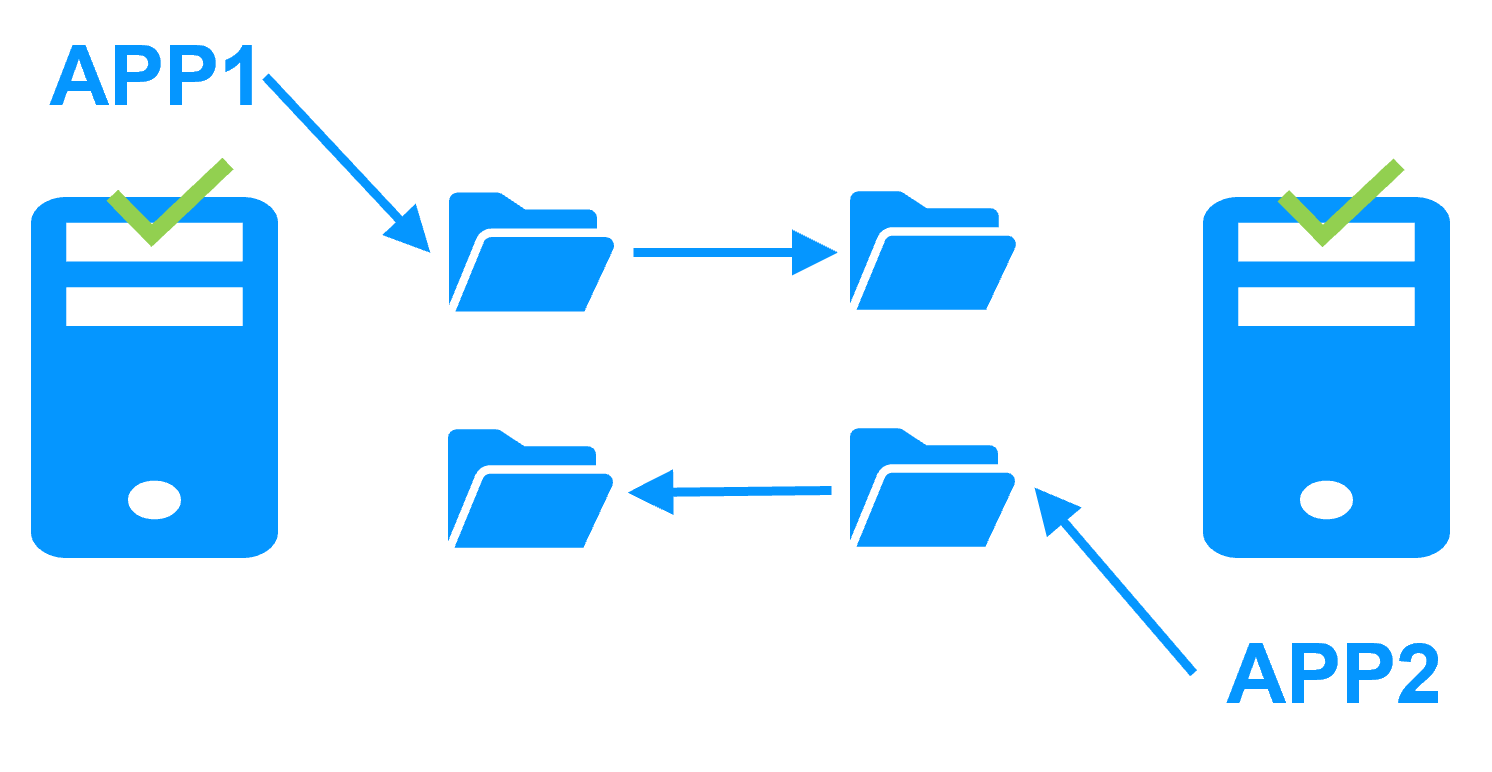

Adresse IP virtuelle dans un cluster feme

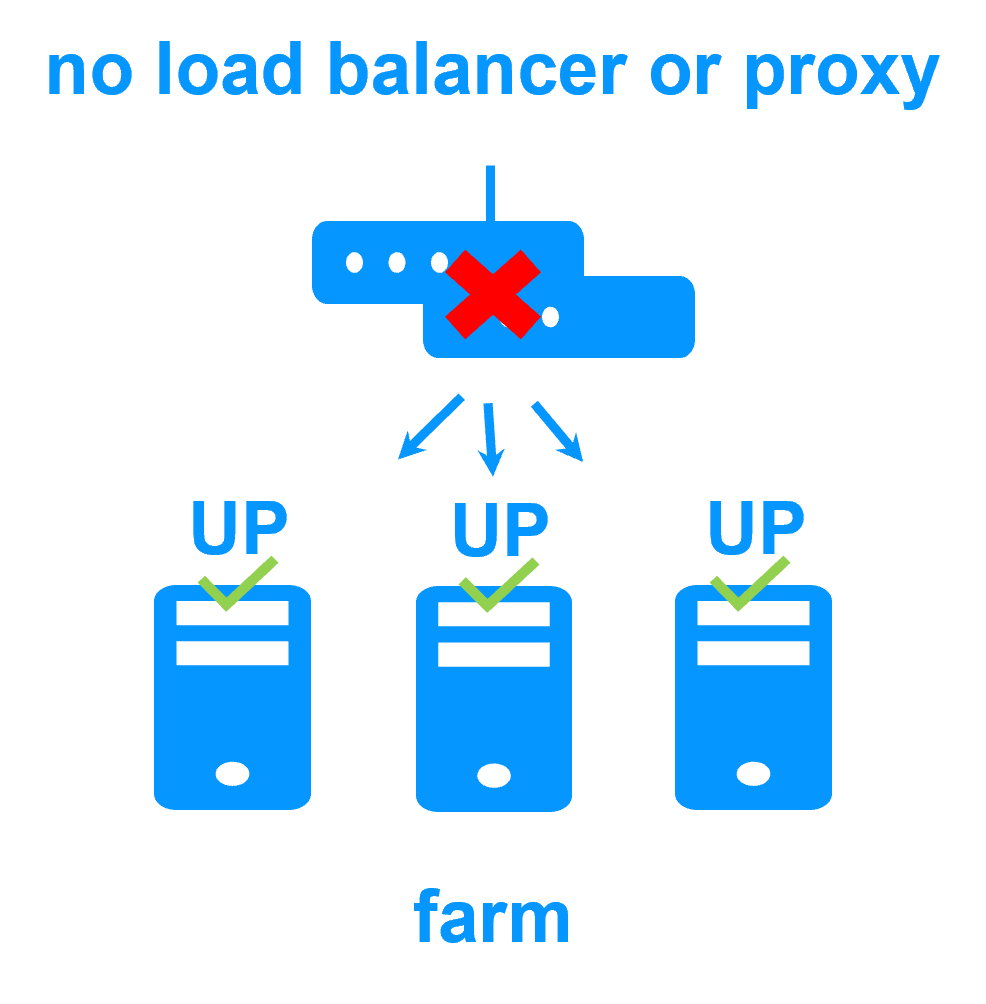

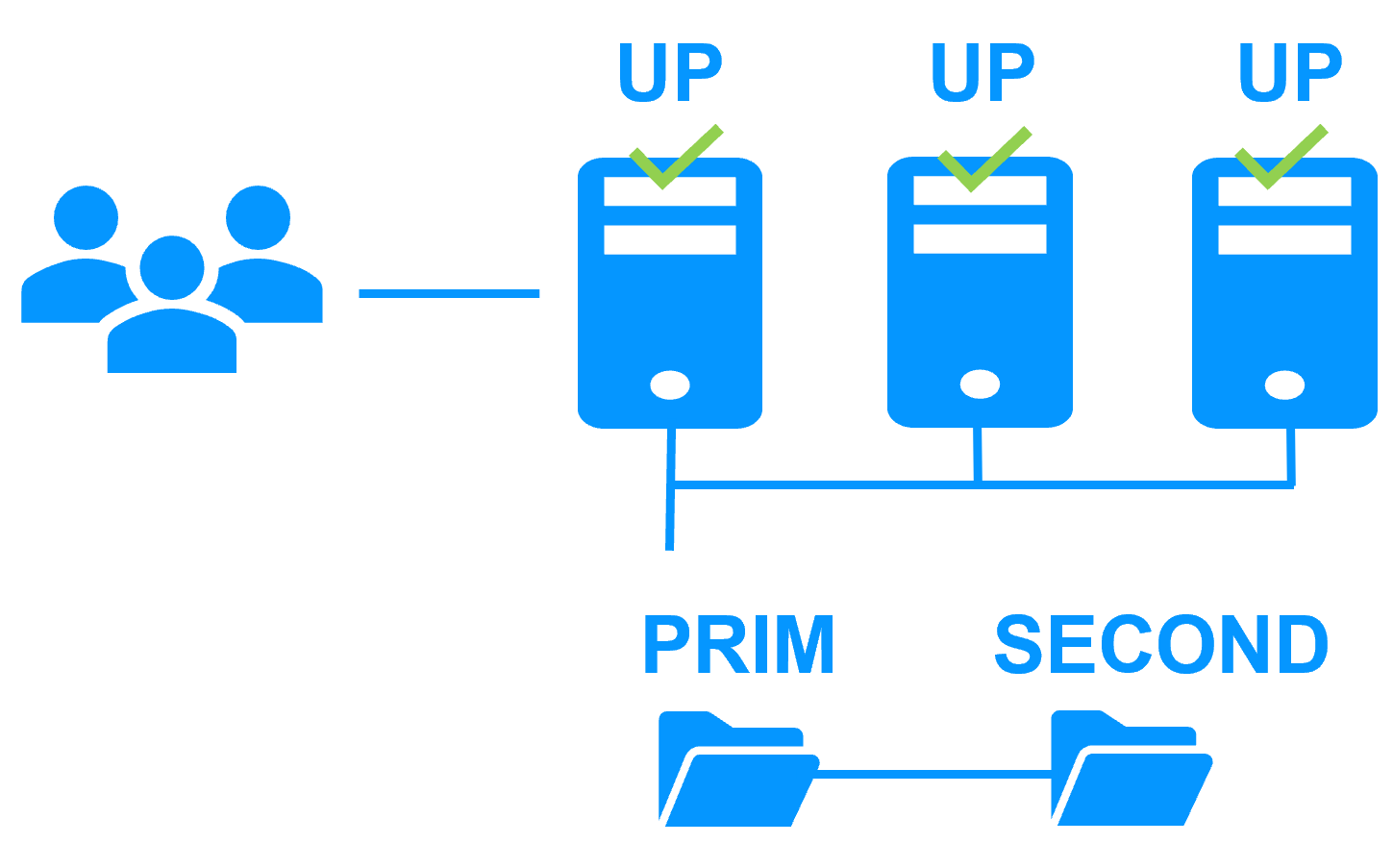

Sur la figure précédente, l'application tourne sur les 3 serveurs (3 est un exemple, il peut y en avoir 2 ou plus). Les utilisateurs sont connectés à une adresse IP virtuelle.

L'adresse IP virtuelle est configurée localement sur chaque serveur de la ferme.

Le trafic du réseau à destination de l'adresse IP virtuelle est reçu par l'ensemble des serveurs. Puis ce trafic est distribué entre les serveurs grâce à un filtre réseau chargé dans le noyau du système d'exploitation de chaque serveur.

SafeKit détecte les pannes matérielles et logicielles, reconfigure les filtres réseau en cas de panne et offre des checkers et des scripts de reprise applicatifs configurables.

Partage de charge dans un filtre réseau

L'algorithme de load balancing dans le filtre réseau est basé sur l'identité des paquets client (adresse IP client, port TCP client). Suivant l'identité du paquet client en entrée, seul un filtre dans un serveur accepte le paquet ; les autres filtres dans les autres serveurs le rejettent.

Une fois un paquet accepté par le filtre sur un serveur, seuls le CPU et la mémoire de ce serveur sont utilisés par l'application qui répond à la requête du client. Les messages de retour de l'application sont envoyés directement du serveur vers le client.

Lorsqu'un serveur est défaillant, le protocole de gestion du groupe des serveurs en vie reconfigure les filtres pour redistribuer le trafic vers les serveurs disponibles.

Applications à état et sans état

Avec une application à état, il y a affinité de session. Le même client doit être connecté sur le même serveur sur plusieurs sessions TCP pour retrouver son contexte sur le serveur. Dans ce cas, la règle de load balancing SafeKit est configurée sur l'adresse IP des clients. Ainsi, le même client est toujours connecté sur le même serveur sur plusieurs sessions TCP. Et différents clients sont répartis sur les différents serveurs de la ferme.

Avec une application sans état, il n'y a pas d'affinité de session. Le même client peut être connecté sur des serveurs différents dans la ferme lors de sessions TCP successives. Dans ce cas, la règle de load balancing SafeKit est configurée sur l'identité de la session TCP du client. Cette configuration est celle qui répartit le mieux les sessions entre les serveurs mais elle requiert un service TCP sans affinité de session.

Nouvelle application (réplication en temps réel et basculement)

- Windows (mirror.safe)

- Linux (mirror.safe)

Nouvelle application (répartition de charge réseau et basculement)

Base de données (réplication en temps réel et basculement)

- Microsoft SQL Server (sqlserver.safe)

- PostgreSQL (postgresql.safe)

- MySQL (mysql.safe)

- Oracle (oracle.safe)

- MariaDB (sqlserver.safe)

- Firebird (firebird.safe)

Web (répartition de charge réseau et basculement)

- Apache (apache_farm.safe)

- IIS (iis_farm.safe)

- NGINX (farm.safe)

Réplication en temps réel et basculement de VM ou de conteneur complet

- Hyper-V (hyperv.safe)

- KVM (kvm.safe)

- Docker (mirror.safe)

- Podman (mirror.safe)

- Kubernetes K3S (k3s.safe)

Amazon AWS

- AWS (mirror.safe)

- AWS (farm.safe)

Google GCP

- GCP (mirror.safe)

- GCP (farm.safe)

Microsoft Azure

- Azure (mirror.safe)

- Azure (farm.safe)

Autres clouds

- Toutes les solutions Cloud

- Générique (mirror.safe)

- Générique (farm.safe)

Sécurité physique (réplication en temps réel et basculement)

- Milestone XProtect (milestone.safe)

- Nedap AEOS (nedap.safe)

- Genetec SQL Server (sqlserver.safe)

- Bosch AMS (hyperv.safe)

- Bosch BIS (hyperv.safe)

- Bosch BVMS (hyperv.safe)

- Hanwha Vision (hyperv.safe)

- Hanwha Wisenet (hyperv.safe)

Siemens (réplication en temps réel et basculement)

- Siemens Siveillance suite (hyperv.safe)

- Siemens Desigo CC (hyperv.safe)

- Siemens Siveillance VMS (SiveillanceVMS.safe)

- Siemens SiPass (hyperv.safe)

- Siemens SIPORT (hyperv.safe)

- Siemens SIMATIC PCS 7 (hyperv.safe)

- Siemens SIMATIC WinCC (hyperv.safe)

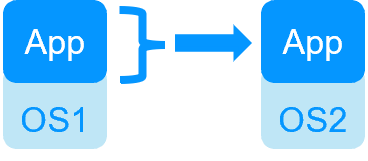

| HA de VMs avec le module Hyper-V ou KVM de SafeKit | HA d'application avec les modules applicatifs de SafeKit |

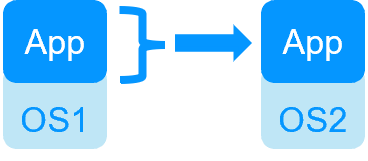

SafeKit dans 2 hyperviseurs: réplication et reprise de VM complète |

SafeKit dans 2 machines virtuelles ou physiques: réplication et reprise au niveau applicatif |

| Réplique plus de données (App+OS) | Réplique seulement les données applicatives |

| Reboot de la machine virtuelle sur l'hyperviseur 2 si l'hyperviseur 1 crash Temps de reprise dépendant du reboot de l'OS Checker de VM et reprise sur panne (la machine virtuelle ne répond pas, est tombée en panne ou a cessé de fonctionner) |

Temps de reprise rapide avec redémarrage de l'application sur OS2 en cas de panne du serveur 1 Autour d'1 mn ou moins (voir RTO/RPO ici) Checker applicatif et reprise sur panne logicielle |

| Solution générique pour n'importe quelle application / OS | Scripts de redémarrage à écrire dans des modules applicatifs |

| Fonctionne avec Windows/Hyper-V et Linux/KVM mais pas avec VMware | Indépendant de la plateforme, fonctionne avec les machines physiques ou virtuelles, une infrastructure cloud et tout hyperviseur, y compris VMware |

| SafeKit avec le module Hyper-V ou le module KVM | Microsoft Hyper-V Cluster & VMware HA |

|

|

Pas de disque partagé - réplication temps réel synchrone à la place avec 0 perte de données Pas de disque partagé - réplication temps réel synchrone à la place avec 0 perte de données |

Disque partagé et baie de disques externe spécifique Disque partagé et baie de disques externe spécifique |

Sites distants = pas de SAN pour la réplication Sites distants = pas de SAN pour la réplication |

Sites distants = baies de disques répliquées à travers un SAN Sites distants = baies de disques répliquées à travers un SAN |

Aucune compétence informatique spécifique pour configurer le système (avec hyperv.safe et kvm.safe) Aucune compétence informatique spécifique pour configurer le système (avec hyperv.safe et kvm.safe) |

Compétence informatique spécifique pour configurer le système Compétence informatique spécifique pour configurer le système |

| Notez que les solutions Hyper-V/SafeKit et KVM/SafeKit sont limitées à la réplication et au basculement de 32 machines virtuelles. | Notez que la réplication intégrée à Hyper-V ne peut pas être considérée comme une solution de haute disponibilité. En effet, la réplication est asynchrone, ce qui peut entraîner une perte de données en cas de panne, et elle ne dispose pas de fonctionnalités de basculement et de restauration automatiques. |

Cluster miroir d'Evidian SafeKit avec réplication de fichiers temps réel et reprise sur panne |

|

Économisez avec 3 produits en 1

En savoir plus >

|

|

Configuration très simple

En savoir plus >

|

|

Réplication synchrone

En savoir plus >

|

|

Retour d'un serveur tombé en panne totalement automatisé (failback)

En savoir plus >

|

|

Réplication de n'importe quel type de données

En savoir plus >

|

|

Réplication de fichiers vs réplication de disque

En savoir plus >

|

|

Réplication de fichiers vs disque partagé

En savoir plus >

|

|

Sites distants et adresse IP virtuelle

En savoir plus >

|

|

Split brain et quorum

En savoir plus >

|

|

Cluster actif/actif

En savoir plus >

|

|

Solution de haute disponibilité uniforme

En savoir plus >

|

|

RTO / RPO

En savoir plus >

|

|

Cluster ferme d'Evidian SafeKit avec load balancing et reprise sur panne |

|

Pas de load balancer, ni de serveur proxy dédié, ni d'adresse Ethernet multicast spéciale

En savoir plus >

|

|

Toutes les fonctionnalités de clustering

En savoir plus >

|

|

Sites distants et adresse IP virtuelle

En savoir plus >

|

|

Solution de haute disponibilité uniforme

En savoir plus >

|

|

|

|

|

Cluster de type "shared nothing"" vs cluster à disque partagé En savoir plus > |

|

|

|

|

|

|

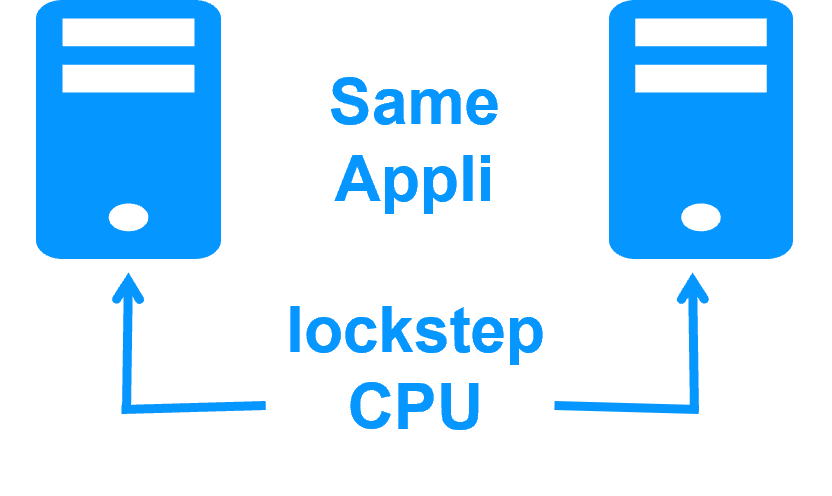

Haute disponibilité vs tolérance aux fautes En savoir plus > |

|

|

|

|

Réplication synchrone vs réplication asynchrone En savoir plus > |

|

|

|

|

Réplication de fichiers au niveau octet vs réplication de disque au niveau du bloc En savoir plus > |

|

|

|

|

Heartbeat, reprise sur panne et quorum pour éviter 2 serveurs maîtres En savoir plus > |

|

|

|

|

|